Professional Documents

Culture Documents

Capitolul1 2012

Uploaded by

Valentin AndreiOriginal Title

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Capitolul1 2012

Uploaded by

Valentin AndreiCopyright:

Available Formats

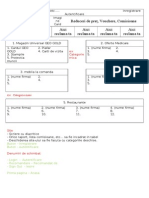

Sistem de compresie de date

sisteme de compresie fr pierderi

sisteme de compresie cu pierderi

raportul de compresie (raportul dintre dimensiunea datelor emise de

sursa [biti] si dimensiunea datelor comprimate [biti])

COMPRESIE FR PIERDERI

sistem de compresie fr pierderi

Sistemele de compresie fr pierderi conserv entropia sursei

Informaia de la o surs fr redundan nu poate fi comprimat

fr pierderi

Secvena X = (x

1

,x

2

, ... ,x

n

) reprezinta datele emise de surs,

simbolurile x

i

ce formeaz secvena aparin unui alfabet finit A.

Secvena binara B(X) = (b

1

, b

2

, ... , b

k

) se numete cuvntul de

cod, k reprezint lungimea secvenei B(X).

Raportul de compresie pentru un sistem de codare fr pierderi

este "r la 1", unde r este dat de

k

A n

r

| | log

2

(1.1)

unde |A| reprezint mrimea alfabetului.

Rata de compresie (bii de cod per dimensiune eantion date).

n

k

R (1.2)

Un sistem de compresie cu raport de compresie r mare este echivalent

cu un sistem de compresie cu rat de compresie R mic.

B( B )

EXEMPLUL 1.1

Considerm o surs de date care furnizeaz datele sub

forma unor imagini 4 4, reprezentate pe 4 culori R = rou, O =

orange, G = galben, V = verde: n figura 1.3 este reprezentat

o astfel de imagine

R R O G

R O O G

O O G V

G G G V

Fig. 1.3 Imagine 4x4 codat

Dac se scaneaz aceast imagine orizontal, asignnd

intensitile R 3 , O 2 , G 1 , V 0 , atunci imaginea poate

fi reprezentat sub forma urmtoarei secvene de date X = (3, 3, 2, 1,

3, 2, 2, 1, 2, 2, 1, 0, 1, 1, 1, 0).

Se comprim X utiliznd un codor definit de tabelul de codare

1.1.

tabel codare

3 001

2 01

1 1

0 000

Tab. 1.1. Tabel de codare a imaginii 4x4

Rezult urmtoarea secven comprimat:

B(X) =(0,0,1,0,0,1,0,1,1,0,0,1,0,1,0,1,1,0,1,0,1,1,0,0,0,1,1,1,0,0,0);

Raportul de compresie este (r la 1):

r =

Rata de compresie este

R =

bii de cod per dimensiune eantion date.

B( B )

COMPRESIE CU PIERDERI

sistem de compresie cu pierderi

nu se conserv entropia sursei, decodorul nu este n msur s

reconstruiasc perfect datele emise de surs.

Secvena X = (x

1

,x

2

, ... ,x

n

) reprezinta datele emise de surs.

Secventa

) x , ... , x , x ( X

n 2 1

reprezinta datele reconstruite.

Rata de compresie dat de

n

k

R .

Distorsiunea D definita in relatia

( )

n

1 i

i i

x x d

n

1

D ,

(1.3)

unde d reprezint o funcie distan.

Fie un sistem de compresie a datelor cu pierderi caracterizat de R

1

, D

1

, i un alt

sistem de compresie cu pierderi caracterizat de R

2

, D

2

; spunem c primul sistem

este mai bun dect al doilea sistem dac R

1

< R

2

i D

1

< D

2

.

Scopul proiectrii va fi atingerea celei mai mici valori pentru R cu D fixat, sau

cea mai mic valoare pentru D cu R fixat.

Pe langa metricile uzuale, in cazul compresiei de imagine se mai utilizeaza:

codor decodor

B( B )

cuantizor X

X

MSE (eroarea ptratic medie) :

( ) ( ) ( )

M

i

N

j

j i X j i X

N M

MSE

1 1

2

, ,

1

,

unde X(i,j) este imaginea original, de dimensiune MxN, iar ( ) j i X ,

reprezint

imaginea reconstruit.

PSNR (raportul semnal de vrf zgomot):

,

`

.

|

MSE

PSNR

D

1 2

log 20

10

,

unde D este numrul de bii pe care e reprezentat fiecare pixel al imaginii (pentru

imagini n tonuri de gri D = 8).

PSNR se msoar n decibeli i este cu att mai mare cu ct distorsiunea este mai mic.

Pentru descrierea performanelor algoritmilor de compresie de imagine se utilizeaz

curbe rat-distorsiune, ce reprezint calitatea reconstruciei la fiecare buget de bii

utilizat.

EXEMPLUL 1.2

Se efectueaz o compresie, cu pierderi, a imaginii 4 4 din

exemplul 1.2. Se cuantizeaz X = (3, 3, 2, 1, 3, 2, 2, 1, 2, 2, 1, 0,

1, 1, 1, 0) i se obine X

= (3, 3, 2, 1, 3, 2, 2, 1, 2, 2, 1, 1, 1, 1, 1,

1). Cuantizorul parcurge secvena eantion cu eantion, lsnd

nemodificate eantioanele cu valori 3, 2, 1 i convertind 0 n 1;

alfabetul este redus astfel de la {0, 1, 2, 3} la {1, 2, 3}. Pentru

codare se folosete codorul definit de tabelul de codare 1.2

tabel codare

3 001

2 01

1 1

Tab. 1.2 Tabel de codare cu pierderi

Rezult urmtoarea secven compresat:

B( X

) = (0, 0, 1, 0, 0, 1, 0, 1, 1, 0, 0, 1, 0, 1, 0, 1, 1, 0, 1, 0, 1, 1, 1,

1, 1, 1, 1).

Rata de compresie este

R =

bii de cod per dimensiune eantion date

Distorsiunea este:

D=

Imaginea reconstruit este reprezentat n figura 1.5.

R R O G

R O O G

O O G G

G G G G

FUNCTIA RATA-DISTORSIUNE

Considerand distorsiunea D definita de relatia:

( ) ( ) ( )

1

0

,

M

j

j X j

dx x y P x f y x d D

1. Pentru R fixat gaseste

( ) x y P

j care minimizeaza

( ) { y x d E ,

cu

constrangerea ( ) R Y X I ;

2. Pentru D fixat gaseste

( ) x y P

j care minimizeaza

( ) Y X I ;

cu

constrangerea ( ) { D Y X d E ,

Revine la:

( )

( ) {

( ) Y X I D R

D Y X d E x y P

j

; min

, : ) (

( ) ( ) ( ) { y x d E x y P D

j

,

Funcia rata-distorsiune R(D) este definit n funcie de minimizarea

transinformaiei, asigurnd creterea eficienei ntregului sistem de transmisie.

Exemplu: Functia rata-distorsiune pentru o sursa gaussiana

Se evalueaz R(D) pentru o surs de numere pseudo-aleatoare fr

memorie care genereaz eantioane distribuite dup o densitate gaussian de

medie 0 i dispersie

2

.

Fie f(x) funcia densitate de probabilitate gaussian

]

]

]

,

`

.

|

2

2

2

exp

2

1

) (

x

x f

a) consideram cazul

2

< D

( ) ( ) ( )

) ( ) (

) ( ) (

;

Y X H X H

Y Y X H X H

Y X H X H Y X I

se doreste maximizarea lui H(X-Y). Facand notatia: H(Z)=H(X-Y), H(Z)

este maxima daca Z este gaussian, si presupunand ca Z are dispersia D atunci

{

2

) ( Y X E D

) 2 ( log

2

1

) (

2

eD Z H

Cum X este gaussian:

) 2 ( log

2

1

) (

2

2

e X H

( ) ) 2 ( log

2

1

) 2 ( log

2

1

;

2

2

2

eD e Y X I

b) consideram cazul

2

D

{ D X E

2 2

) 0 (

Y=0; ( ) ( ) 0 0 ; ; X I Y X I

Combinand a) si b) rezulta:

funcia rat-distorsiune este data de:

'

0

log

2

1

) (

2

2

D

D R

Se noteaz cu D(R) inversa funciei R(D) si se numeste functia distorsiune-rata:

R

R D

2 2

2 ) (

Pentru o rat de compresie R fixat, sursa fr memorie gaussian este sursa

fr memorie care conduce la cea mai proast distorsiune. Fie D*(R) funcia

distorsiune-rat n decibeli pentru o surs non-gaussian fr memorie, i fie

D(R) este funcia rat-distorsiune exprimat n dB pentru o surs gaussian fr

memorie, atunci

) ( ) (

*

R D R D

Fig. 3 Functia rata-distorsiune pentru o sursa gaussiana

CLASIFICAREA METODELOR DE COMPRESIE

Criterii de clasificare a metodelor de compresie

- dupa modul in care se realizeaza reconstructia datelor emise de

surs (compresie fara pierderi (lossless)/cu pierderi (lossy))

dup natura semnalelor asociate informaiei ce trebuie comprimat

Tehnicile de compresie urmresc n principal:

reducerea redundanei sursei primare

scderea energiei necesare transmiterii semnalului prin reducerea

dimensiunilor spaiului n care poate fi reprezentat semnalul, in

spaiul primar sau spaii rezultate prin transformri ortogonale ale

spaiului primar;

reducerea corelaiei ntre simboluri.

Eficiena cu care sursa genereaz informaia depinde de:

probabilitatea cu care sunt emise simbolurile generate de surs;

corelaia existent ntre simbolurile generate de sursele cu memorie

redundana natural a sursei de informaie

COMPRESIA ENTROPIC

1 INTRODUCERE

Criterii de clasificare a metodelor de compresie entropic

Dup constructia arborilor de codare-decodare:

a) metode statice

b) metode dinamice

Dupa modul in care reduce redundana natural a mesajului iniial:

a) metode bazate pe frecvena de apariie a unei forme

b) metode bazate pe apariia grupat a aceleiai forme

1.1 Definitii

Prin procesul de codare a datelor se trece de la reprezentarea oferit de

alfabetul sursei X (constituit din simbolurile x

1

, ..., x

M

) la o reprezentare printr-

un alt alfabet Y.

Uzual, alfabetul Y este format din dou simboluri 0 sau 1. n acest fel fiecrui

simbol i se asociaz o secven finit de bii numit cuvnt de cod.

Codurile realizeaz o coresponden ntre mesajele sursei (secvene de

simboluri) i cuvintele de cod (secvene de bii).

Codurile pot fi clasificate n:

i) bloc-bloc (stabilesc o coresponden ntre mesaje ale sursei de lungime

fixat i cuvinte de cod de lungime fixat);

ii) bloc-variabile;

iii) variabile-bloc;

iv) variabile-variabile (stabilesc o coresponden ntre mesaje ale sursei de

lungime variabil i cuvinte de cod variabile);

EXEMPLUL 1.3

Se consider

X = { a, b, c, d, e, f, g, h, spaiu }

Y = { 0, 1}

Simboluri Cuvinte de cod

a 000

b 001

c 010

d 011

e 100

f 101

g 110

Spaiu 111

Tab. 2.1 Tabel de codare bloc-bloc

Codul din tabelul 2.1 este un cod bloc-bloc

EXEMPLUL 1.4

Se consider

X = { a, b, c, d, e, f, g, h, spaiu }

Y = { 0, 1}

Simboluri Cuvinte de cod

aa 0

bbb 1

cccc 10

ddddd 11

eeeeee 100

fffffff 101

gggggggg 110

spaiu 111

Tab. 2.2. Tabel de codare variabile-variabile

Se observ c pentru un mesaj :

aa_bbb_cccc_ddddd_eeeeee_fffffffgggggggg (40 simboluri in total)

se obine o lungime cod de 30 fa de o lungime de cod de 120 dac codarea s-

ar fi fcut conform tabelului 2.1 .

Un cod este distinct dac fiecare cuvnt de cod se poate discerne

n raport cu celelalte.

Un cod distinct este unic decodabil dac fiecare cuvnt de cod este

identificabil cnd se afl imersat ntr-o secven de cuvinte de cod.

Condiii suficiente care s asigure aceast proprietate sunt:

(a) utilizarea cuvintelor de cod de aceeai lungime (bloc)

(b) utilizarea unui semn distinct ntre cuvinte (separator)

Exist ns i coduri care nu necesit utilizarea unui mijloc suplimentar pentru

a asigura proprietatea de unic decodabil. Aceste coduri se numesc separabile.

Exemplul 1.5

n tabelul de mai jos sunt prezentate patru coduri separabile

mesaj A B C D

s

0

00 0 0 0

s

1

01 10 01 10

s

2

10 110 011 110

s

3

11 1110 0111 111

Un cod unic decodabil (UD) este un cod prefix dac are proprietatea

de prefix: nici un cuvnt de cod s nu fie prefixul altui cuvnt de cod.

Codurile prefix sunt decodabile instantaneu, in acest caz decodarea

este posibil imediat ce s-a primit ultimul bit al cuvntului de cod fr a

mai fi necesar recepionarea altor bii.

Exemplul 1. 6

Exemplu de cod prefix:

Exemplul 1.7

Exemplu de cod care este unic decodabil dar care nu are proprietatea de

prefix:

1.2 Alcatuirea unui Cod

Un criteriu convenabil de apreciere a unui cod este lungimea medie a unui

cuvnt de cod. O codare eficient (compresie) urmrete minimizarea lungimii medii

) (C l

a

a cuvintelor de cod.

C w s

a

w l s p C l

) , (

) ( ) ( ) (

(2.4)

Lungimea cuvntului de cod w, notat

) (w l

este numrul de litere (numr de bii)

care l formeaz, iar p(s) este probabilitatea de aparitie a simbolului.

Se spune despre un cod prefix C ca este un cod prefix optimal daca ) (C l

a

este

minima (pentru distributia de probabilitati data).

Exemplul 1.8

Fie S={s

1

, s

2

, s

3

, s

4

} cu p(s

1

)=1/2, p(s

2

)=1/4, p(s

3

)=p(s

4

)=1/8. Entropia sursei

are in acest caz valoarea: H(S)=1,75 biti

In tabelul de mai jos se prezinta trei posibilitati de codare si lungimile medii

corespunzatoare fiecarui cod:

Simbol Ex 1:Cod fara proprietatea UD Ex.2:Cod prefix Ex 3: Cod UD

s

1

0 0 0

s

2

1 10 01

s

3

00 110 011

s

4

11 111 0111

n 1,25 1,75 1,875

Observatii:

- Pentru codul fara proprietatea UD se obtine cel mai bun ) (C l

a

insa

codul este inutilizabil nefiind unic decodabil

- In cazul celor doua coduri UD (corespunzatoare Ex.2 si Ex. 3 din

tabel) cel mai bun rezultat (codul cu lungimea medie minima) se

obtine in cazul codului prefix.

Codurile prefix se pot reprezenta grafic asociind pentru fiecare cuvnt

de cod un nod frunz dintr-un arbore binar.

Pentru codul prefix {(s

1

, 0), (s

2

, 10), (s

3

, 110), (s

4

, 111)} se poate construi

urmatorul arbore binar de codare:

Exemplul 1.9

O condiie necesar i suficient ca un cod s fie cod prefix este dat

de teorema urmtoare:

TEOREMA 1 Inegalitatea lui Kraft- -McMillan

Pentru orice cod unic decodabil C,

rdcin

0

1

s1

0

1

0

1

s

2

s3

s4 ordin 1

ordin 2

( )

1 2

,

) (

M

C w s

w l

unde l(w)

este lungimea cuvantului de cod w.

Pentru orice set de lungimi de cuvinte de cod l cu

1 2

L l

l

exista un cod prefix C de aceeasi dimensiune astfel incat l(w

i

)=l

i

cu i=1... L

Dac

) (

2

i

w l

i

p

, i=1, 2, ..., M se obine

) (C l

a

=

Observaie:

n general ) (C l

a

H(S) i se urmrete ca ) (C l

a

s fie ct mai

aproape de H(S).

LEMA 1

Pentru orice sursa de informatie S de entropie H(S) si cod unic decodabil C

asociat este adevarata relatia:

) (C l

a

H(S)n

Demonstratie:

0 2 log )

) (

2

)(log ( ) 2 log

) (

1

)(log (

)) (

) (

1

)(log ( ) ( ) (

) (

1

log ) ( ) ( ) (

) (

) (

) (

S s

s l

S s

s l

s l

S s

S s S s S s

a

s p

s p

s p

s p

s l

s p

s p s l s p

s p

s p C l S H

demonstratia se bazeaza pe inegalitatea lui Jensen: fie f(x) concava atunci

) ) ( ( ) (

i

i i

i

i i

x p f x f p

cu p

i

probabilitati. Ultima linie se bazeaza pe

teorema Kraft- -McMillan

LEMA 2

Pentru orice sursa de informatie S de entropie H(S) si cod prefix optimal C

asociat este adevarata relatia: n

1 ) ( ) ( + S H C l

a

TEOREMA 2.

Daca C este un cod prefix optimal pentru probabilitatile {

n

p p ,.....,

1

atunci

j i

p p >

implica

) ( ) (

j i

c l c l

.

1.1 ELEMENTE DE TEORIA INFORMATIEI

Notiuni de teoria probabilitatilor

Probabilitatea evenimentui A verifica urmatoarele axiome.

(i)

P A ( ) 0

(ii)

P S ( ) 1

unde S - evenimentul sigur

(iii) Pentru evenimentele mutual exclusive

) ( ) ( ) ( B P A P B A P B A +

Corolare

(i)

P( ) 0

unde - evenimentul imposibil

(ii) P A P A ( ) ( ) 1 1 unde

A

- multimea complementara

multimii A fata de S

(iii)

P A B P A P B P A B P A P B ( ) ( ) ( ) ( ) ( ) ( ) + +

Probabilitatea conditionata

Probabilitatea conditionata a evenimentui A fata de B este

( )

P A B

P A B

P B

P B

>

( )

( )

( ) daca 0

sau:

( )

P A B P A B P B P B ( ) ( ) ( ) > 0

sau

( )

P A B P B A P A P A ( ) ( ) ( ) > 0

se poate scrie:

( )

( )

P A B

P B A P A

P B

( )

( )

Regula de inlantuire poate fi generalizata

( ) ( ) ( )

P A A A P A A A P A A A P A A P A

n n n n n

( ) ( ) ( ) ( )

1 2 2 3 1

Evenimente independente

Evenimentele A si B sunt denumite evenimente independente daca si

numai daca

P A B P A P B ( ) ( ) ( )

Se observa ca pentru doua evenimente independente ( )

P A B P A ( )

si

( )

P B A P B ( )

Proprietatile evenimentelor independente

(i)

P A B P A P B P A P B ( ) ( ) ( ) ( ) ( ) +

(ii) P A B P A P B ( ) ( ) ( )

Informatie. Entropie informationala

Cantitatea de informatie se defineste ca fiind

I m

p

k

k

( ) log

1

Entropia informaionala (Continutul mediu de informatie)

n

i

i i n

p p p p p H

1

2 , 1

log ) ,..., (

Proprietatile entropiei

a) Folosind conventia

p p log

2

0

pentru

p 0

, entropia este

pozitiva, simetrica si continua.

b) Oricare ar fi probabilitatile

p p p

n 1 2

, , ,

H p p p H

n n n

n

( , , , ) , , ,

1 2

1 1 1

|

.

`

,

Proprietatea arata ca entropia este maxima pentru evenimente

echiprobabile. Valoarea maxima a entropiei este

n H

2 max

log

.

c) Fie campul de evenimente

X

x x x x

p p p p

n n

n n

|

.

`

,

1 2 1

1 2 1

Se considera ca evenimentul

x

n

se descompune in

m

evenimente

disjuncte

x y y y

n m

1 2

cu probabilitatile

q q q

m 1 2

, , ,

satisfacand o relatie de tipul

q p

j

j

m

n

1

.

Se formeaza astfel un camp de evenimente

( ) X Y

x x y y

p p q q

n m

n m

,

|

.

`

,

1 1 1

1 1 1

Entropia acestui camp este

H p p q q H p p

n m n

( , , , ) ( , )

1 1 1 1

Prin impartirea unui eveniment in mai multe evenimente, entropia nu

poate sa scada.

Entropia legilor compuse

Fie doua campuri de evenimente caracterizate prin repartitiile:

A

a a

p p

n

n

|

.

`

,

1

1

si B

b b

q q

m

m

|

.

`

,

1

1

,

p k n p

k k

k

n

>

0 1 2 1

1

, , , ,

si

q l m q

l l

l

m

>

0 1 2 1

1

, , , ,

Cazul 1: evenimentele din cele doua campuri sunt statistic

independente; experimentul cumulat

( , ) A B

ale carui evenimente sunt

constituite din aparitia simultana a unui eveniment

a

k

din A si

b

l

din B, are

probabilitatile:

kl k l

p q

cu

kl

l

m

k

n

k

k

n

l

l

m

p q

1 1 1 1

1 1 1

Entropia experimentului cumulat este

) ( ) ( ) , ( B H A H B A H +

Deci entropia experimentului compus, daca evenimentele din cele doua

experimente sunt statistic independente, este egala cu suma entropiilor.

Cazul 2: probabilitatea de aparitie a evenimentelor

m

b b , ,

1

este

conditionata de aparitia evenimentelor

a a

n 1

, ,

.

Se considera ca aparitia evenimentului

a

k

din A determina pentru

evenimentele din B o repartitie de forma

b b b

q q q

m

k k km

1 2

1 2

|

.

`

,

cu

q

kl

l

m

1

1

Experimentul compus care reflect realizarea evenimentului b

1

condiionat de

apariia evenimentului a

k

este n acest caz caracterizat de probabilitatea:

kl k l k l k k kl

p a b p a p b a p q ( , ) ( ) ( )

Campul obtinut este un camp complet de evenimente, deoarece

p q p q

k kl

l

m

k

k

n

kl

l

m

k

n

1 1 1 1

1

p(x/y) y)log p(x,

H(A/y) ) ( } / {

Y y X x

Y y

y p B A H

Entropia experimentului cumulat este

H A B H A H B A ( , ) ( ) ( ) +

H A B H B H AB ( , ) ( ) ( ) +

0 2 + H B A H B H A B H A H B H A B ( ) ( ) ( , ) ( ) ( ) ( , )

Se constata ca entropia campului conjugat in cazul in care evenimentele

din cele doua campuri nu sunt statistic independente este mai mica decat suma

entropiilor. Relatia se poate generaliza pentru n campuri

A A

n 1

, ,

H A A H A H A

n n

( , , ) ( ) ( )

1 1

+ +

egalitatea fiind adevarata doar pentru campuri de evenimente statistic

independente.

Se defineste cantitatea de informatie mutuala continuta in A relativ la

B, ca fiind expresia

I A B H A H AB H B H B A ( , ) ( ) ( ) ( ) ( )

Relatia arata ca incertitudinea asupra lui A nu poate decat sa se reduca

prin cunoasterea realizarilor lui B.

I A B H A H B H A B ( , ) ( ) ( ) ( , ) +

Entropia unei legi continue

Fie o variabil aleatoare X avnd o lege de densitate de probabilitate ( ) x p :

( ) ( ) dx x p dx x X x p +

Mrimea:

( ) ( ) ( )

+

dx x p x p X H log

va fi definit entropie de lege continu de distribuie a probabilitii.

Astfel, pentru o lege de distribuie gaussian, presupus centrat:

( )

2

2

2

2

1

x

e x p

se calculeaza

( ) dx e

x

e X H

x

]

]

]

log

2

2 log

2

1

2

2

2

2

2

i rezult:

( ) ( ) e X H 2 log

Observatii :

Entropia continu poate fi negativa.

Entropia continu, in cazul unei variabile continue, centrate, de ordinul 2 (de

variant finit

2

) este mrginit. Se demonstreaz c

( ) ( ) e X H 2 log

, cu

alte cuvinte entropia este maxim dac variabila aleatoare e gaussian.

Fie dou variabile aleatoare X i Y continue, avnd urmtoarele densiti de

probabilitate:

( ) ( ) ( ) ( )

+

+

dx y x p y p dy y x p x p

Y X

, ; ,

( )

( )

( )

( )

( )

( ) x p

y x p

x y p

y p

y x p

y x p

X

X Y

Y

Y X

,

/ ;

,

/

/ /

Pe baza acestor probabiliti se definesc:

Entropia conjunct:

) , ( Y X H

( ) ( ) ( )

2

, log , ,

R

dxdy y x p y x p Y X H

Entropiile

) ( X H

i

) (Y H

:

( ) ( ) ( )

( ) ( ) ( )

+

+

dy y p y p Y H

dx x p x p X H

Y Y

X X

log

log

Entropiile condiionate:

( ) ( ) ( )

( ) ( ) ( )

2

2

/ log , /

/ log , /

/

/

R

X Y

R

Y X

dxdy x y p y x p X Y H

dxdy y x p y x p Y X H

Informaia mutual:

( ) ( )

( )

( ) ( )

dxdy

y p x p

y x p

y x p Y X I

Y X

,

log , ,

n cazul variabilelor independente, ca i n cazul discret:

( ) ( ) ( ) ( ) ( )

( ) ( ) ( ) 0 , , /

, / , ,

+

Y X I Y H X Y H

X H Y X H Y H X H Y X H

De asemenea:

( ) ( ) ( ) ( ) ( )

( ) ( ) ( ) Y X H Y H X H

Y X H X H X Y H Y H Y X I

,

/ / ,

+

You might also like

- PR Piroliza BZ Date-Obiective-Corelatii2 TMPP - 2014 Sgr31202-BBDocument13 pagesPR Piroliza BZ Date-Obiective-Corelatii2 TMPP - 2014 Sgr31202-BBValentin AndreiNo ratings yet

- Inginer Start and StopDocument1 pageInginer Start and StopValentin AndreiNo ratings yet

- Prezentare Curs Tuv-04.08Document40 pagesPrezentare Curs Tuv-04.08Valentin AndreiNo ratings yet

- 2-Sisteme de Achizitie A DatelorDocument5 pages2-Sisteme de Achizitie A Datelorcioranu_ionNo ratings yet

- Curs 5 - Tehnologii Moderne Pentru Transport UrbanDocument62 pagesCurs 5 - Tehnologii Moderne Pentru Transport UrbanValentin AndreiNo ratings yet

- Senzori 5Document12 pagesSenzori 5Lorena VizitiuNo ratings yet

- Manual UtilizareDocument2 pagesManual UtilizareValentin AndreiNo ratings yet

- Curs 1 - Utilizarea Programelor Informatice Pentru Optimizarea MunciiDocument64 pagesCurs 1 - Utilizarea Programelor Informatice Pentru Optimizarea MunciiValentin AndreiNo ratings yet

- Curs 1 - Utilizarea Programelor Informatice Pentru Optimizarea MunciiDocument64 pagesCurs 1 - Utilizarea Programelor Informatice Pentru Optimizarea MunciiValentin AndreiNo ratings yet

- Cerinte Site - Pentru Vali-1Document2 pagesCerinte Site - Pentru Vali-1Valentin AndreiNo ratings yet

- Tehnici de Calcul In Prelucrarea Numerica A SemnalelorDocument69 pagesTehnici de Calcul In Prelucrarea Numerica A SemnalelorVlad AndreiNo ratings yet

- Subiecte ExamenDocument2 pagesSubiecte ExamenValentin AndreiNo ratings yet

- PostaDocument3 pagesPostaValentin AndreiNo ratings yet

- PostaDocument3 pagesPostaValentin AndreiNo ratings yet

- Tema de Casa+Ghid Calcul Actionari 2011Document12 pagesTema de Casa+Ghid Calcul Actionari 2011Valentin AndreiNo ratings yet