Professional Documents

Culture Documents

RLMEJMPLO

Uploaded by

Cesario GillasCopyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

RLMEJMPLO

Uploaded by

Cesario GillasCopyright:

Available Formats

1

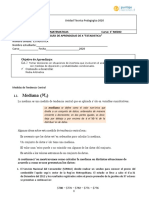

Ejemplo de los gastos de las computadoras personales segn su

antigedad y las horas diarias de trabajo

Supongamos que estamos interesados en explicar los gastos (en miles de

pesos) de las computadoras personales de un departamento comercial a partir

de su edad (en aos) y del nmero de horas diarias que trabajan (horas/da).

Se ha tomado una muestra de cinco computadoras personales y de las cuales se

han obtenido los resultados siguientes:

Gastos Y (miles de pesos ) Antigedad X1 ( aos) Horas de trabajo X2

(horas/da)

24.6 1 11

33.0 3 13

36.6 4 13

39.8 4 14

28.6 2 12

Se quiere encontrar un modelo de regresin de la forma:

0 1 1 2 2

y x x = + + +

Si desarrollamos esta ecuacin en odas las observaciones de la muestra,

obtenemos el sistema de siguiente:

1 0 1 2 1

2 0 1 2 2

3 0 1 2 3

4 0 1 2 4

5 0 1 2 5

y 1 11

y 3 13

y 4 13

y 4 14

y 2 12

= + + +

= + + +

= + + +

= + + +

= + + +

Que podemos escribir matricialmente como

Y X = + = + = + = +

Donde:

2

24.6

33.0

36.0

39.8

28.0

Y

(

(

(

( =

(

(

(

(

(

(

(

(

(

=

12 2 1

14 4 1

13 4 1

13 3 1

11 1 1

X

(

(

(

=

2

1

0

1

2

3

4

5

(

(

(

(

=

(

(

(

X es la parte correspondiente a la variacin de Y que queda explicada

por las variables X

i

es el trmino de los errores y que de alguna manera recoge el efecto

de aquellas variables que tambin afectan a Y; las cuales no se

encuentran incluidas en el modelo porque son desconocidas o porque

no se tienen datos suyos

Estimacin del vector de parmetros por Cuadrados Mnimos

A partir de las observaciones de la muestra se quiere encontrar una ecuacin

de regresin lineal mltiple estimada que predice la variable dependiente, Y, en

funcin de las variables independientes observadas X

j

. Tal modelo tiene la

forma

Donde:

j

son las estimaciones de los parmetros del modelo

i

y es el valor estimado por el modelo para y

i

i i i

e y y =

Es la diferencia entre los valores observados y los valores

estimados de la variable dependiente.

El vector de los residuos se puede escribir en forma matricial como:

e Y X = = = =

Para construir el modelo de ajuste se tiene que minimizar la suma de

cuadrados de los residuos.

i o 1 i1 2 i 2 p ip i

y x x ...... x e = + + + + +

( )

n n

2

2 T T

i i i

i 1 i 1

Q( ) e y y e e (Y X ) ( Y X )

= =

= = = =

3

Haciendo operaciones con los vectores y matrices

T T T T T T

T T T T T

Q( ) Y Y X Y Y X X X

Q( ) Y Y 2 X Y X X

= +

= +

Derivando Q con respecto a

e igualando a cero se obtiene el sistema de

ecuaciones normales

( )

T T

X X X Y =

Resolviendo para

se obtiene:

( )

1

T T

X X X Y

=

El vector

es el vector de los estimadores mnimos cuadrticos de los

parmetros del modelo.

Recordemos que si en la ecuacin matricial

( )

T T

X X X Y =

se

efecta la multiplicacin, se obtiene el sistema de ecuaciones normales de la

regresin

4

(

(

(

(

(

(

=

(

(

(

(

(

(

(

(

(

(

(

(

(

(

(

(

= = = =

= = = =

= = = =

= = =

k

k n

i

ik

n

i

i ik

n

i

i ik

n

i

ik

n

i

i ik

n

i

i

n

i

i i

n

i

i

n

i

i ik

n

i

i i

n

i

i

n

i

i

n

i

ik

n

i

i

n

i

i

e

e

e

e

x x x x x x

x x x x x x

x x x x x x

x x x n

3

2

1

2

1

0

1

2

1

2

1

1

1

1

2

1

2

2

1

2 1

1

2

1

1

1

2 1

1

2

1

1

1

1 1

2

1

1

Para nuestro ejemplo, tenemos:

24.6

33.0

36.0

39.8

28.0

Y

(

(

(

( =

(

(

(

(

(

(

(

(

(

=

12 2 1

14 4 1

13 4 1

13 3 1

11 1 1

X

(

(

(

=

12 14 13 13 11

2 4 4 3 1

1 1 1 1 1

T

X

Entonces,

(

(

(

=

(

(

(

(

(

(

(

(

(

=

799 182 63

182 46 14

63 14 5

12 2 1

14 4 1

13 4 1

13 3 1

11 1 1

12 14 13 13 11

2 4 4 3 1

1 1 1 1 1

X X

T

Y la inversa de esta matriz ser:

5

( )

(

(

(

=

(

(

(

7 . 1 4 . 1 5 . 17

4 . 1 3 . 1 14

5 . 17 14 5 . 181

799 182 63

182 46 14

63 14 5

1

1

X X

T

Por otro lado, se tiene:

T

24.6

1 1 1 1 1 162.6 33.0

X Y 1 3 4 4 2 486.4 36.6

11 13 13 14 12 2075.8 39.8

28.6

(

(

( (

(

( (

( = =

( (

(

( (

(

(

As el vector de parmetros estimados de la regresin

( )

1

T T

181.5 14 17.5 162.6 5

X X X Y 14 1.3 1.4 486.4 2.6

17.5 1.4 1.7 2075.8 2.4

( ( (

( ( (

= = =

( ( (

( ( (

La ecuacin de regresin queda:

2 1

4 . 2 6 . 2 5

x x y + + =

Interpretacin de los parmetros

De la misma manera que en la regresin lineal, una vez obtenido el modelo de

regresin lineal mltiple, es muy importante hacer una buena interpretacin de

los resultados obtenidos. De momento, slo hemos obtenido los parmetros

estimados del modelo de regresin:

Para interpretarlos correctamente, debemos tener presente el contexto que

estudiamos.

6

1. Interpretacin de

0

Este parmetro representa la estimacin del valor de Y cuando todas las X

j

toman valor cero. No siempre tiene una interpretacin vinculada al contexto

(geomtrica, fsica, econmica, etc.). Para que sea posible interpretarlo,

necesitamos lo siguiente:

a. Que sea realmente posible que las X

j

= 0.

b. Que se tengan suficientes observaciones cerca de los valores X

j

= 0.

2. Interpretacin de j

Representa la estimacin del incremento que experimenta la variable Y cuando

X

j

aumenta su valor en una unidad y las dems variables se mantienen

constantes.

Ejemplo de los gastos de las computadoras personales segn su

antigedad y las horas diarias de trabajo

Continuando con el ejemplo de las computadoras personales y a partir de los

resultados obtenidos en el ajuste:

0

5 =

Nos indica los gastos en miles de pesos de una computadora personal con cero

aos de antigedad y cero horas semanales de trabajo. Es evidente que en

este caso no tiene ningn sentido.

6 . 2

1

=

Nos indica el incremento de los gastos en miles de pesos por cada ao de

antigedad de una computadora personal, sin tener en cuenta el nmero de

horas diarias de uso. As pues, por cada ao que pase, tendremos 2,6 x 1.000

= 2600 computadora personal ms en los gastos de mantenimiento de una

computadora personal.

4 . 2

2

=

Nos indica el incremento en los gastos en miles de pesos por cada hora diaria

de uso sin tener en cuenta la antigedad de la computadora personal. Tenemos

que por cada hora de trabajo adicional, tendremos un incremento de 2,4 x 1.000

= 2.400 pesos en los gastos anuales de mantenimiento de una computadora

personal.

7

La calidad del ajuste

1. Introduccin

Una vez encontrado el modelo de regresin lineal mltiple a partir de los datos

de una muestra, queremos utilizarlo para hacer inferencias a toda la poblacin.

Sin embargo, antes es necesario llevar a cabo una comprobacin de la

idoneidad del modelo obtenido.

Ahora se debe calcular el coeficiente de determinacin para la regresin

mltiple como indicador de la calidad del ajuste. Tambin se utilizan los

grficos de los residuos como una importante herramienta de diagnstico del

modelo

Calidad del ajuste. El coeficiente de determinacin R

2

Si consideramos que la variabilidad del modelo puede dividirse en los

componentes

SCT = SCR + SCE

Variabilidad total muestral = variabilidad explicada + variabilidad no explicada

De la misma manera que en la regresin lineal simple, tambin podemos definir

ahora el coeficiente de determinacin R

2

como la proporcin de variabilidad

explicada por el modelo con respecto a la variabilidad total, es decir:

muestra la de total ad Variabilid

modelo el por explicada ad Variabilid

2

= R

Se puede expresar el coeficiente de determinacin as:

2

SCR SCE

R 1

SCT SCT

= =

Las ecuaciones de las varianzas:

( )

1 1

1

1

2

2

=

=

n

SCT

y y

n

S

n

i

i y

8

( )

n

2

2

y i

i 1

1 SCR

S y y

k k

=

= =

( )

n n

2

2 2

e i i i

i 1 i 1

1 1 SCE

S y y e

n k 1 n k 1 n k 1

= =

= = =

Donde

SCT = Suma de Cuadrados Totales

SCR = Suma de Cuadrados de la Regresin

SCE = Suma de Cuadrados de los residuos

Ya se demostr que:

SCT = SCR + SCE

Para calcular las sumas de cuadrados, podemos utilizar el clculo matricial.

Suma de los cuadrados totales

Siendo D el vector de desviaciones de las y

i

con respecto a la media y :

(

(

(

(

=

(

(

(

(

=

y y

y y

y y

d

d

d

D

n n

2

1

2

1

Se puede escribir la suma de los cuadrados totales de la forma siguiente:

( ) [ ]

(

(

(

(

= = =

=

y y

y y

y y

y y y y y y D D y y SCT

n

n

T

n

i

i

2

1

2 1

1

2

9

Suma de los cuadrados de la regresin:

A partir de los valores estimados

(

(

(

(

(

(

(

(

(

(

=

(

(

(

(

k

kn n n

k

k

n

x x x

x x x

x x x

y

y

y

1

1

1

2

1

0

2 1

2 22 12

1 21 11

2

1

Se puede calcular el vector de las desviaciones de los valores estimados

i

y

con respecto a la media y

(

(

(

(

=

(

(

(

(

=

y y

y y

y y

w

w

w

w

n n

2

1

2

1

de donde,

( ) [ ]

(

(

(

(

= = =

=

y y

y y

y y

y y y y y y w w y y SCR

n

n

T

n

i

i

2

1

2 1

1

2

Suma de los cuadrados de los errores

A partir de los residuos:

10

(

(

(

(

=

(

(

(

(

=

n n n

y y

y y

y y

e

e

e

e

2 2

1 1

2

1

de donde,

( ) [ ]

(

(

(

(

= = =

=

n n

n n

T

n

i

i i

y y

y y

y y

y y y y y y e e y y SCE

2 2

1 1

2 2 1 1

1

2

Para el ejemplo de los gastos de las computadoras personales segn su

antigedad y las horas diarias de trabajo

Se tiene que, 52 . 32 = y de manera que la suma de cuadrados totales vale:

( ) [ ] 97 . 147

98 . 3

28 . 7

08 . 4

48 . 0

92 . 7

98 . 3 28 . 7 08 . 4 48 . 0 92 . 7

1

2

=

(

(

(

(

(

(

= =

=

n

i

i

y y SCT

Los valores estimados por el modelo de regresin mltiple son:

1

2

3

4

5

y 1 1 11 24

y 5 1 3 13 34

y X 2.6 1 4 13 36.6

y 2.4 1 4 14 39

y 1 2 12 29

( ( (

( ( (

(

( ( (

(

( ( ( = = =

(

( ( (

(

( ( (

( ( (

11

De manera que la suma de cuadrados de la regresin es:

( ) [ ] 81 . 145

52 . 3

48 . 6

08 . 4

48 . 1

52 . 8

52 . 3 48 . 6 08 . 4 48 . 1 52 . 8

1

2

=

(

(

(

(

(

(

= =

=

n

i

i

y y SCR

La diferencia entre los valores observados y los valores estimados nos permite

obtener los residuos:

1 1 1

2 2 2

3 3 3

4 4 4

5 5 5

e y y 24.6 24 0.6

e y y 33 34 1

e e y y 36.6 36.6 0

e y y 39.8 39 0.8

e y y 28.6 29 0.4

( ( ( (

( ( ( (

( ( ( (

( ( ( ( = = = =

( ( ( (

( ( ( (

( ( ( (

Por lo tanto

( ) [ ] 16 . 2

4 . 0

8 . 0

0

1

6 . 0

4 . 0 8 . 0 0 1 6 . 0

1

2

=

(

(

(

(

(

(

= = =

=

e e y y SCE

T

n

i

i i

De esta manera el coeficiente de determinacin es:

12

2

2

SCR 145.81

R 0.985

SCT 147.97

SCE 2.16

R 1 1 1 0.015 0.985

SCT 147.97

= = =

= = = =

Este resultado nos dice que el modelo de regresin mltiple obtenido explica el

98,5% de la variabilidad de los gastos de las computadoras personales. Dado

que est muy cerca del 100%, por el momento se puede considerar como un

buen modelo.

El coeficiente de determinacin ajustado

El coeficiente de determinacin ajustado,

2

R , se define de la siguiente forma

( )

( )

2

SCE / n k 1

R 1

SCT / n 1

=

Esta medida se utiliza para tener en cuenta el hecho de que las variables

independientes irrelevantes provocan una pequea reduccin en la suma de

los cuadrados de los residuos. Por lo tanto, el

2

R permite comparar de mejor

manera los modelos de regresin lineal mltiple que tiene diferentes nmeros

de variables independientes

El

2

R para el ejemplo ser entonces:

( )

( )

2

SCE / n k 1

2.16 / 2

R 1 1 0,970804

SCT / n 1 147.97 / 4

= = =

13

Contrastacin conjunta del modelo

Hemos visto cmo hay que hacer el contraste de hiptesis para ver si cada una

de las variables X

i

, individualmente, contribuye a explicar la variable Y.

Ahora queremos contrastar el modelo de forma global, teniendo en cuenta

todas las variables X

i

que hemos utilizado para encontrarlo.

Establecemos las hiptesis:

Hiptesis nula: H

0

:

1

=

2

= ... =

K

= 0.

Nos indica que no existe relacin lineal entre la variable Y y ninguna de las

variables Xi.

Hiptesis alternativa: H

1

: al menos una

i

0

Calculamos el estadstico de contraste.

Esta prueba se basa en un estadstico de contraste que es una observacin de

una distribucin F cuando H

0

es cierta.

Buscaremos una relacin entre la variacin explicada por el modelo de

regresin mltiple y la no explicada por el mismo modelo. Si la proporcin de

variacin explicada en relacin con la no explicada es grande, entonces se

confirmar la utilidad del modelo y no rechazaremos la hiptesis nula H

0

.

A partir de la descomposicin de la suma de cuadrados totales segn la suma

de cuadrados de la regresin ms la suma de los cuadrados de los errores:

Bajo la hiptesis nula, H

0

:

1

=

2

= ... =

K

= 0.

SCR tiene una distribucin

2

con k grados de libertad.

SCE tiene una distribucin

2

con n k - 1 grados de libertad.

SCR y SCE son independientes.

El cociente de dos variables

2

divididas por sus grados de libertad da una

variable F de Snedecor con los grados de libertad correspondientes al

numerador y denominador del cociente.

Si la hiptesis nula es cierta y, por tanto, no existe ningn tipo de relacin lineal

entre Y y las variables X

i

, el estadstico tendr un valor cercano a uno. Pero

cuando existe cierta relacin, la suma de los cuadrados de la regresin

(numerador) aumenta y la suma de los cuadrados de los errores (denominador)

disminuye, de manera que el valor del estadstico de contraste aumenta. Si

este valor supera un valor crtico de la distribucin F, entonces rechazamos la

hiptesis nula.

As pues, podemos definir el estadstico de contraste:

14

) 1 /(

/

=

k n SCE

k SCR

F

Es una observacin de una distribucin F de Snedecor con k y n k - 1 grados

de libertad.

Si la hiptesis nula es cierta y, por tanto, no existe ningn tipo de relacin lineal

entre Y y las variables X

i

, el estadstico tendr un valor cercano a uno. Pero

cuando existe cierta relacin, la suma de los cuadrados de la regresin

(numerador) aumenta y la suma de los cuadrados de los errores (denominador)

disminuye, de manera que el valor del estadstico de contraste aumenta. Si

este valor supera un valor crtico de la distribucin F, entonces rechazamos la

hiptesis nula.

Establecemos un criterio de decisin a partir de un nivel de significacin :

A partir de este valor crtico de la distribucin F de Snedecor:

Si F > F

; k; n-k-1

, rechazamos H

0

; por tanto, el modelo explica

significativamente la variable Y. Es decir, el modelo s que contribuye con

informacin a explicar la variable Y.

Si F < F

; k; n-k-1,

no rechazamos H

0

; por tanto, el modelo no explica de forma

significativa la variable Y.

Tambin podemos hacerlo a partir del p-valor: p = P(F

; k; n-k-1

> f ).

Si p , se rechaza la hiptesis nula H

0

.

Si p > , no se rechaza la hiptesis nula H

0

.

Los clculos necesarios se pueden resumir en la tabla siguiente, conocida

como TABLA DE ANLISIS DE VARAINZA

Fuente de

Variacin

Suma de

cuadrados

Grados

de

libertad

Cuadrados medios

Estadstico

de prueba

x1,x2,.xk SCR k CMR=SCR/k

e SCE n - k - 1 CME=SCE/(n - k - 1)

y SCT n - 1

CMR/CME

Es muy importante tener presente el hecho siguiente: que el modelo lineal

explique de forma significativa la variable Y no implica que todas las variables

sean explicativas; para saberlo, deberemos contrastarlas de una en una, tal

como se ha explicado en el apartado anterior.

15

Ejemplo de los gastos de las computadoras personales segn su

antigedad y las horas diarias de trabajo

Ahora realizaremos un contraste conjunto del modelo obtenido anteriormente

para las computadoras personales.

Tomaremos = 0,05.

1. Establecemos las hiptesis nula y alternativa:

Hiptesis nula: H

0

:

1

=

2

= 0.

Hiptesis alternativa: H

1

: al menos una

i

0, i = 1, 2.

2. Calculamos el estadstico de contraste:

Tenemos que:

Fuente

de

Variacin

Suma de

cuadrados

Grados de

libertad

Cuadrados medios

Estadstico

de prueba

x1,x2 145,81 2 72,955

E 2,16 5 -2- 1 1,08

Y 147,97 5 -1

67,5509259

Establecemos un criterio de decisin a partir de un nivel de significacin =

0,05. Mirando las tablas de la distribucin F de Snedecor, tenemos que el valor

crtico para = 0,05 y 2 grados de libertad en el numerador y 2 en el

denominador es F

0,05;2;2

= 19,0.

Puesto que 67,5 > 19,0, entonces rechazamos la hiptesis nula, de manera

que el modelo en conjunto es bueno para explicar la variable Y.

Con el p-valor tenemos que: p = P(F

0,05;2;2

> 67,5) = 0,0146 el cual es menor

que 0,05; por tanto, rechazamos la hiptesis nula.

Inferencia en la regresin lineal mltiple

1. Introduccin

Una vez estimado el modelo de regresin, interesa poder aplicarlo, hacer

inferencia, a la poblacin de la que se ha sacado la muestra. Ahora se

determina los intervalos de confianza para los parmetros del modelo y se

realizan contrastes de hiptesis para as poder detectar cules son las

variables realmente significativas.

Finalmente, se realizan la validacin de los supuestos; en especial cmo se

puede detectar y evitar el problema de la duplicacin de informacin que surge

16

cuando se utilizan variables correlacionadas, conocido con el nombre de

multicolinealidad.

2. Estimacin de la varianza de los errores

Dada una muestra de observaciones, el modelo estar totalmente determinado

una vez que se especifiquen los valores estimados de los coeficientes

0

,

1

,...,

k

y se estime la varianza comn de los errores

2

. Para determinar una

estimacin insesgada de esta ltima, se considera los residuos como

estimaciones de los valores del trmino de error, entonces se puede estimar la

varianza de este trmino a partir de la varianza de los residuos:

( )

n

2

2

e i i

i 1

1 SCE

s y y

n k 1 n k 1

=

= =

Donde k es el nmero de variables independientes en el modelo de regresin.

La raz cuadrada de la varianza s

e

, se conoce tambin como error tpico de la

estimacin ( Standard Error of Est. )

3. Distribuciones probabilsticas de los parmetros de la regresin

As,

0

,

1

,...,

k

son unas variables aleatorias que habr que estudiar para

poder inferir nuestros resultados a la poblacin de la que hemos extrado las

muestras. Primero las caracterizaremos calculando sus valores esperados y las

desviaciones estndar:

a) Valor esperado de

j

( )

j j

E =

para j = 1, ..., k. Se observa que los valores esperados de estos parmetros

son iguales a los valores poblacionales de stos. Aunque estos valores sean

desconocidos, este resultado ser de gran utilidad a la hora de hacer inferencia

estadstica.

b) Varianza de

j

. Las varianzas de las

j

son los elementos de la diagonal

de la matriz

( )

1

2 T

X X

, es decir:

( )

( )

( )

( )

0

1

1 2 T

k

var

var

diag X X

var

(

(

(

(

=

(

(

(

17

Ya se ha calculado la media y la varianza de los estimadores. Puesto que la

variable Y se distribuye normalmente y las

j

son combinacin lineal de las

observaciones y

j

, se puede asegurar que las

j

se distribuirn normalmente:

( ) j j ij

N , q

donde q

jj

es el elemento de la fila j y columna j de la matriz (X

T

X)

-1

. Dado que la

varianza

2

es desconocida, se utiliza el valor estimado a partir de los datos de

la muestra, es decir

2

e

s

( )

n

2

2

e i i

i 1

1 SCE

s y y

n k 1 n k 1

=

= =

De manera que:

( )

( )

( )

( )

0

1

1 2 T

e

k

var

var

s diag X X

var

(

(

(

(

=

(

(

(

As, las desviaciones estndar de los estimadores sern:

( )

j

j

s var , para j 1,2,...,k

= =

18

Para el ejemplo de las computadoras personales

( )

1

T

181.5 14 17.5

X X 14 1.3 1.4

17.5 1.4 1.7

(

(

=

(

(

La ecuacin de regresin qued:

2 1

4 . 2 6 . 2 5 x x y + + =

Adems

2

e

SCE 2.16

s 1.08

n k 1 2

= = =

De esta manera:

( )

0

0

var 1.08 181.5 195,912 s 13.99 14

= = = =

( )

1

1

var 1.08 1.3 1.404 s 1.18

= = =

( )

2

2

var 1.08 1.7 1.836 s 1.35

= = =

Intervalos de confianza de los parmetros del modelo

En los modelos de regresin lineal mltiple resulta til construir estimaciones

de intervalos de confianza para los coeficientes de la regresin. Como hemos

visto en el apartado anterior, los estimadores siguen distribuciones. Por tanto,

se puede demostrar que la variable tipificada:

j

j j

sigue una distribucin t de Student con n k -1 grados de libertad. Puesto que:

19

j

j j

/ 2,n k 1 / 2,n k 1

P t t 1

s

| |

|

=

|

\

Un intervalo de confianza con un nivel de confianza de 100(1 )% para el

coeficiente

j

de la regresin viene dado por:

j

j / 2,n k 1

t s

donde

j

es el valor estimado del parmetro a partir de la muestra.

Para el ejemplo:

Intervalo de confianza para

1

con un nivel de confianza del 95%.

Observando la tabla de la distribucin t de Student con n - k - 1 = 2

grados de libertad, el valor crtico correspondiente para /2 = 0,025 es:

t

0,025;2

= 4,3027. El intervalo de confianza ser:

[2,6 - 4,3027 1,18; 2,6 - 4,3027 1,18] = [-2,50; 7,70]

Intervalo de confianza para

2

con un nivel de confianza del 95%.

Ahora el intervalo de confianza ser:

[2,4 - 4,3027 1,35; 2,4 - 4,3027 1,35] = [-3,43; 8,23]

20

Contraste de hiptesis sobre los parmetros del modelo

Muchas veces es interesante hacer tests de hiptesis sobre los coeficientes de

la regresin. Casi siempre nos interesar saber si un coeficiente es igual a

cero, ya que esto querra decir que la variable X

i

correspondiente no figura en

el modelo de regresin y, por tanto, no es una variable explicativa del

comportamiento de la variable Y.

Para hacer este contraste de hiptesis, seguimos el procedimiento que

exponemos a continuacin:

1) Establecemos las hiptesis. Para cada

j

:

Hiptesis nula: H

0

:

j

= 0 (la variable X

j

no es explicativa).

Hiptesis alternativa: H

1

:

j

0.

En caso de que no rechacemos la hiptesis nula, esto querr decir que la

variable

X

j

no es una variable explicativa y que, por tanto, podemos eliminarla del

modelo.

2) Calculamos el estadstico de contraste: si la hiptesis nula es cierta (

j

= 0),

entonces obtenemos el estadstico de contraste:

j

j

t

s

=

que es una observacin de una distribucin t de Student con n - k - 1 grados de

libertad.

3) Finalmente, a partir de un nivel de significacin se establece el criterio de

decisin. Para hacerlo, tenemos dos opciones:

a) A partir del p-valor.

b) A partir de los valores crticos t

/2;n-k-1

Para el ejemplo

Volvemos a nuestro ejemplo para hacer un contraste de hiptesis sobre los

parmetros de la regresin y enterarnos de si las variables son explicativas de

los gastos anuales de mantenimiento de los ordenadores o no. Utilizaremos un

nivel de significacin = 0,05.

Contraste para

1

1. Establecemos las hiptesis nula y alternativa:

Hiptesis nula: H

0

:

1

= 0 (la variable X

1

no es explicativa).

Hiptesis alternativa: H

1

:

1

0.

2. Calculamos el estadstico de contraste:

21

1

1

2.6

t 2.20

s 1.18

= = =

3. Calculamos el p-valor correspondiente a este estadstico de contraste:

p = 2 P(t

n k -1

> |t|) = 2 P(t

2

> 2,20 ) = 2 x 0,094 = 0,1598.

Dado que 0,1598 > 0,05, no rechazamos H0. Por tanto, la variable X

1

no es una

variable explicativa y, por tanto, podemos eliminarla del modelo.

Contraste para

2

1. Establecemos las hiptesis nula y alternativa:

Hiptesis nula: H

0

:

2

= 0 (la variable X

1

no es explicativa).

Hiptesis alternativa: H

1

:

2

0.

2. Calculamos el estadstico de contraste:

2

2

2.3

t 1.77

s 1.35

= = =

3. Calculamos el p-valor correspondiente a este estadstico de contraste:

p = 2P(t

n-k-1

> |t|) = 2P(t

2

> 1,77 ) = 2 x 0,1094 = 0,2188

Dado que 0,2188 > 0,05, no rechazamos H

0

. Por tanto, la variable X

2

tampoco

es una variable explicativa y, por tanto, podemos eliminarla del modelo.

En este modelo de regresin lineal mltiple ninguna de las dos variables nos

explica la variable gasto en mantenimiento.

Llegamos a este punto, nos hacemos la pregunta siguiente: cmo puede ser

que el modelo en conjunto sea bueno para explicar la variable Y y, en cambio,

el contraste por separado para cada una de las variables X

1

y X

2

nos haya

dado que ninguna de las dos era explicativa de la variable Y? A primera vista

parece que sean resultados contradictorios. Esto se debe a la presencia de

multicolinealidad en nuestro problema. Lo trataremos en el apartado siguiente.

El problema de la multicolinealidad

En los problemas de regresin lineal mltiple esperamos encontrar

dependencia entre la variable Y y las variables explicativas X

1

, X

2

, ..., X

k

. Pero

en algunos problemas de regresin podemos tener tambin algn tipo de

dependencia entre algunas de las variables X

j

. En este caso tenemos

informacin redundante en el modelo.

22

El anlisis de los residuos

De la misma manera que en la regresin lineal simple, los residuos del modelo

de regresin lineal mltiple tienen un papel importante a la hora de determinar

la adecuacin del modelo.

En el caso de regresin lineal mltiple es habitual construir dos tipos de

grficos:

a) Grfico de residuos frente a valores estimados: representamos en el eje

de ordenadas los valores de los residuos y en el eje de abscisas, los

valores estimados, de manera que la nube de puntos no debe tener

ningn tipo de estructura y es cercano al eje de abscisas.

b) Grfico de residuos frente a variables explicativas: representamos sobre

el eje de ordenadas los valores de los residuos y sobre el eje de

abscisas, los valores observados de la variable explicativa. Tenemos un

grfico de este tipo para cada una de las variables explicativas.

Siempre que el modelo sea correcto, ningn grfico de residuos debe mostrar

ningn tipo de estructura. Los residuos siempre deben estar distribuidos al azar

alrededor del cero.

Para el ejemplo

En el caso de las computadoras personales y sus gastos en mantenimiento,

tenemos los grficos de representacin de los residuos siguientes:

Los tres grficos representan:

Plot of Y

24 28 32 36 40

predicted

24

28

32

36

40

o

b

s

e

r

v

e

d

Residual Plot

X1

r

e

s

i

d

u

a

l

1 1.5 2 2.5 3 3.5 4

-1

-0.6

-0.2

0.2

0.6

1

23

Residual Plot

X2

r

e

s

i

d

u

a

l

11 11.5 12 12.5 13 13.5 14

-1

-0.6

-0.2

0.2

0.6

1

a) residuos frente a valores estimados por el modelo;

b) residuos frente a valores de la variable X1: horas diarias de trabajo;

c) residuos frente a valores de la variable X2: antigedad en aos.

No observamos ningn tipo de estructura organizada de los residuos que nos

haga pensar en una falta de linealidad del modelo. Tampoco observamos

ningn dato atpico.

El anlisis de los residuos se realiza de igual manera que para un modelo de

regresin lineal simple

Adicionalmente para verificar la existencia de multicolinealidad, es conveniente

calcular la matriz de correlaciones parciales. Para el ejemplo

Correlation matrix for coefficient estimates

-----------------------------------------------------------------------------

CONSTANT X1 X2

CONSTANT 1.0000 0.9114 -0.9963

X1 0.9114 1.0000 -0.9417

X2 -0.9963 -0.9417 1.0000

-----------------------------------------------------------------------------

De hecho como se haba sospechado, existe una alta correlacin negativa

entre X

1

y X

2

, igual -0.9417

Multiple Regression - Y

Multiple Regression Analysis

-----------------------------------------------------------------------------

Dependent variable: Y

-----------------------------------------------------------------------------

Standard T

Parameter Estimate Error Statistic P-Value

-----------------------------------------------------------------------------

CONSTANT -5.0 14.0007 -0.357125 0.7552

X1 2.6 1.18491 2.19427 0.1595

X2 2.4 1.35499 1.77123 0.2185

-----------------------------------------------------------------------------

Analysis of Variance

-----------------------------------------------------------------------------

Source Sum of Squares Df Mean Square F-Ratio P-Value

-----------------------------------------------------------------------------

Model 145.808 2 72.904 67.50 0.0146

Residual 2.16 2 1.08

-----------------------------------------------------------------------------

Total (Corr.) 147.968 4

24

R-squared = 98.5402 percent

R-squared (adjusted for d.f.) = 97.0804 percent

Standard Error of Est. = 1.03923

Mean absolute error = 0.56

Durbin-Watson statistic = 2.61111 (P = 0.3392)

Lag 1 residual autocorrelation = -0.425926

The StatAdvisor

---------------

The output shows the results of fitting a multiple linear

regression model to describe the relationship between Y and 2

independent variables. The equation of the fitted model is

Y = -5.0 + 2.6*X1 + 2.4*X2

Since the P-value in the ANOVA table is less than 0.05, there is a

statistically significant relationship between the variables at the

95% confidence level.

The R-Squared statistic indicates that the model as fitted

explains 98.5402% of the variability in Y. The adjusted R-squared

statistic, which is more suitable for comparing models with different

numbers of independent variables, is 97.0804%. The standard error of

the estimate shows the standard deviation of the residuals to be

1.03923. This value can be used to construct prediction limits for

new observations by selecting the Reports option from the text menu.

The mean absolute error (MAE) of 0.56 is the average value of the

residuals. The Durbin-Watson (DW) statistic tests the residuals to

determine if there is any significant correlation based on the order

in which they occur in your data file. Since the P-value is greater

than 0.05, there is no indication of serial autocorrelation in the

residuals.

In determining whether the model can be simplified, notice that the

highest P-value on the independent variables is 0.2185, belonging to

X2. Since the P-value is greater or equal to 0.10, that term is not

statistically significant at the 90% or higher confidence level.

Consequently, you should consider removing X2 from the model.

Component+Residual Plot for Y

1 1.5 2 2.5 3 3.5 4

X1

-4.1

-2.1

-0.1

1.9

3.9

5.9

c

o

m

p

o

n

e

n

t

e

f

f

e

c

t

95.0% confidence intervals for coefficient estimates

-----------------------------------------------------------------------------

Standard

Parameter Estimate Error Lower Limit Upper Limit

-----------------------------------------------------------------------------

CONSTANT -5.0 14.0007 -65.2402 55.2402

X1 2.6 1.18491 -2.49823 7.69823

X2 2.4 1.35499 -3.43005 8.23005

-----------------------------------------------------------------------------

The StatAdvisor

---------------

This table shows 95.0% confidence intervals for the coefficients in

25

the model. Confidence intervals show how precisely the coefficients

can be estimated given the amount of available data and the noise

which is present.

Plot of Y

24 28 32 36 40

predicted

24

28

32

36

40

o

b

s

e

r

v

e

d

Correlation matrix for coefficient estimates

-----------------------------------------------------------------------------

CONSTANT X1 X2

CONSTANT 1.0000 0.9114 -0.9963

X1 0.9114 1.0000 -0.9417

X2 -0.9963 -0.9417 1.0000

-----------------------------------------------------------------------------

The StatAdvisor

---------------

This table shows estimated correlations between the coefficients in

the fitted model. These correlations can be used to detect the

presence of serious multicollinearity, i.e., correlation amongst the

predictor variables. In this case, there is 1 correlation with

absolute value greater than 0.5 (not including the constant term).

Residual Plot

X1

r

e

s

i

d

u

a

l

1 1.5 2 2.5 3 3.5 4

-1

-0.6

-0.2

0.2

0.6

1

Residual Plot

X2

r

e

s

i

d

u

a

l

11 11.5 12 12.5 13 13.5 14

-1

-0.6

-0.2

0.2

0.6

1

26

Residual Plot

predicted Y

r

e

s

i

d

u

a

l

24 28 32 36 40

-1

-0.6

-0.2

0.2

0.6

1

Residual Plot

0 1 2 3 4 5

row number

-1

-0.6

-0.2

0.2

0.6

1

(X 1.E9)

S

t

u

d

e

n

t

i

z

e

d

r

e

s

i

d

u

a

l

Plot of Y with Predicted Values

1 1.5 2 2.5 3 3.5 4

X1

24

28

32

36

40

Y

You might also like

- Ventilador Magnetico (Introduccion)Document5 pagesVentilador Magnetico (Introduccion)Cesario GillasNo ratings yet

- Resorte de torsión helicoidal optimizado para aplicaciones industrialesDocument5 pagesResorte de torsión helicoidal optimizado para aplicaciones industrialesCesario GillasNo ratings yet

- Coord Sub PDFDocument10 pagesCoord Sub PDFCesario GillasNo ratings yet

- Aproximación Por Lógica Difusa de La Serie de Tiempo - Demanda Diaria de Energía EléctricaDocument10 pagesAproximación Por Lógica Difusa de La Serie de Tiempo - Demanda Diaria de Energía EléctricaCesario GillasNo ratings yet

- Aplicación de la lógica difusa en redes eléctricas inteligentesDocument10 pagesAplicación de la lógica difusa en redes eléctricas inteligentesJc LeonNo ratings yet

- DanielaOlmos TFM Annexo1 PDFDocument6 pagesDanielaOlmos TFM Annexo1 PDFCesario GillasNo ratings yet

- Coord Sub2 PDFDocument216 pagesCoord Sub2 PDFCesario GillasNo ratings yet

- Avances Recientes en La Prediccion de La Demnada Usando Modelos No LinealesDocument8 pagesAvances Recientes en La Prediccion de La Demnada Usando Modelos No LinealesLisheida SanchezNo ratings yet

- H4 Proyecciones FinancierasDocument41 pagesH4 Proyecciones Financierasdkd3nc3No ratings yet

- BP 01Document12 pagesBP 01Cesario GillasNo ratings yet

- BALDOR +La+Industria+MineraDocument8 pagesBALDOR +La+Industria+MineraCristian Castelo TaipeNo ratings yet

- Aproximación Por Lógica Difusa de La Serie de Tiempo - Demanda Diaria de Energía EléctricaDocument10 pagesAproximación Por Lógica Difusa de La Serie de Tiempo - Demanda Diaria de Energía EléctricaCesario GillasNo ratings yet

- Compensacion ReactivaDocument94 pagesCompensacion ReactivayormanalejandroNo ratings yet

- Analisis Energetico Edificio TesisDocument79 pagesAnalisis Energetico Edificio TesisCesario GillasNo ratings yet

- Aproximación Por Lógica Difusa de La Serie de Tiempo - Demanda Diaria de Energía EléctricaDocument10 pagesAproximación Por Lógica Difusa de La Serie de Tiempo - Demanda Diaria de Energía EléctricaCesario GillasNo ratings yet

- Especificaciones Parte 3Document9 pagesEspecificaciones Parte 3Marco Antonio Ospina GarridoNo ratings yet

- Analisis Local y Mundial de Tendencias en Generacion DistribuidaDocument23 pagesAnalisis Local y Mundial de Tendencias en Generacion DistribuidaCesario GillasNo ratings yet

- Inn Ee-D 001 Guía Del Curso WebDocument10 pagesInn Ee-D 001 Guía Del Curso WebCesario GillasNo ratings yet

- 4575 F21 BD 01Document17 pages4575 F21 BD 01josefernel530100% (1)

- 01 Perdidas en DistribucionDocument11 pages01 Perdidas en DistribucionCesario GillasNo ratings yet

- Ecuaciones de MaxwellDocument35 pagesEcuaciones de MaxwellRmro Chefo LuigiNo ratings yet

- Fundamentos de RadiaciónDocument18 pagesFundamentos de RadiaciónEugenio CamarilloNo ratings yet

- 2.memorias LSMT LSBT EpsaDocument108 pages2.memorias LSMT LSBT EpsaCesario Gillas100% (1)

- Especificaciones de Diseño y Partes de Un Tablero de Distribucion PARTE 2Document11 pagesEspecificaciones de Diseño y Partes de Un Tablero de Distribucion PARTE 2Javier Thus Gavilan50% (2)

- Climt ManualDocument65 pagesClimt Manualosito2012No ratings yet

- HPMRDocument1 pageHPMRCesario GillasNo ratings yet

- Guía DE SELECCION DE MOTORES AbbDocument134 pagesGuía DE SELECCION DE MOTORES Abbjoaquinmur100% (2)

- Infocurso Tableros de DistribucionDocument19 pagesInfocurso Tableros de DistribucionYesenia Elizabeth MachayNo ratings yet

- Guía para La Presentación de Propuestas: Anexo 1Document10 pagesGuía para La Presentación de Propuestas: Anexo 1Cesario GillasNo ratings yet

- Video Portero Instalacion 1Document19 pagesVideo Portero Instalacion 1davarherNo ratings yet

- Ejemplos de selección natural en insectos, aves y otros animalesDocument2 pagesEjemplos de selección natural en insectos, aves y otros animalesEduardo José Hernández GuevaraNo ratings yet

- El Aromo 100Document60 pagesEl Aromo 100huertalasfloresNo ratings yet

- Cuestionario Tipo Icfes de Lectura Crítica y FilosofiaDocument4 pagesCuestionario Tipo Icfes de Lectura Crítica y FilosofiaJairo Ramos AguirreNo ratings yet

- Cuestionario de Principios de Terminacion de PozosDocument3 pagesCuestionario de Principios de Terminacion de PozosRaúl Hiram Cocom DelgadoNo ratings yet

- Los Tenis de CarlosDocument32 pagesLos Tenis de CarlosAna Serafin Lecona50% (2)

- F Investigacion El v2Document14 pagesF Investigacion El v2AURA ALICIA MINA ESTUPINANNo ratings yet

- Comunicacion Verbal y No VerbalDocument5 pagesComunicacion Verbal y No VerbalricardojaraNo ratings yet

- Introducción a la citometría de flujoDocument44 pagesIntroducción a la citometría de flujoRamon Vazquez100% (2)

- Danza Misteriosa - Lynn Margulis y Dorion SaganDocument260 pagesDanza Misteriosa - Lynn Margulis y Dorion Saganrodolfo chapa100% (2)

- Factores Del MacroentornoDocument18 pagesFactores Del MacroentornoPercy Cardenas OchoaNo ratings yet

- Puente Grua Manipulación de CargasDocument73 pagesPuente Grua Manipulación de CargasAtilio PesquinNo ratings yet

- Procesar y Codificar Encuentas en Excel Paso A PasoDocument7 pagesProcesar y Codificar Encuentas en Excel Paso A PasoWilson AcostaNo ratings yet

- La historia de superación del niño que domó el vientoDocument4 pagesLa historia de superación del niño que domó el vientoDiana PinedaNo ratings yet

- Primaria 5Document6 pagesPrimaria 5Erick Anthony Atoche AlamaNo ratings yet

- Factores Que Afectan La FotosíntesisDocument15 pagesFactores Que Afectan La FotosíntesissilviaNo ratings yet

- Tarea 5Document10 pagesTarea 5Cinthya DenisseNo ratings yet

- Influencia Del Material Didáctico en El Aprendizaje de Los Alumnos Del Segundo Año DDocument4 pagesInfluencia Del Material Didáctico en El Aprendizaje de Los Alumnos Del Segundo Año DManuel Pedro Vasquez Galan0% (1)

- Introducción A La Optimización DinámicaDocument37 pagesIntroducción A La Optimización DinámicaJuancho PalNo ratings yet

- Rubrica para Valorar Mapa MentalDocument2 pagesRubrica para Valorar Mapa MentalIng Siste CompNo ratings yet

- Ejercicios A Desarrollar Razonamiento VerbalDocument7 pagesEjercicios A Desarrollar Razonamiento VerbalCarolina CassagueNo ratings yet

- Psicomotricidad en la educación infantil: estimulando el desarrollo integral de los niñosDocument3 pagesPsicomotricidad en la educación infantil: estimulando el desarrollo integral de los niñosEmî SiuvaNo ratings yet

- Metanol Hoja de SeguridadDocument2 pagesMetanol Hoja de SeguridadBernarditaSalinasNeiraNo ratings yet

- SUVAGDocument4 pagesSUVAGAgus SchNo ratings yet

- Centrosides y Momento de InerciaDocument1 pageCentrosides y Momento de InerciaJhonnatan YupaNo ratings yet

- Unidad 1 PDFDocument52 pagesUnidad 1 PDFalexNo ratings yet

- 01.-Memoria Descriptiva General ChuyaDocument22 pages01.-Memoria Descriptiva General ChuyaDanny CondeNo ratings yet

- 13Document97 pages13Ady GidezNo ratings yet

- GUIA 10 ESTADISTICA 3°medioDocument10 pagesGUIA 10 ESTADISTICA 3°medioEduardo UtrerasNo ratings yet

- Pendulo Balistico PDFDocument3 pagesPendulo Balistico PDFBrian Aguirre Lennis0% (1)

- Guía de Actividades y Rúbrica de Evaluación - Unidad 1 - Fase 1 - Reconocimiento y ContextualizaciónDocument4 pagesGuía de Actividades y Rúbrica de Evaluación - Unidad 1 - Fase 1 - Reconocimiento y ContextualizaciónKevin David Otero SeñasNo ratings yet