Professional Documents

Culture Documents

Apuntes Psicomate 2A Parte

Uploaded by

pachilonga0 ratings0% found this document useful (0 votes)

11 views18 pagesOriginal Title

Apuntes_psicomate_2A_parte[1]

Copyright

© Attribution Non-Commercial (BY-NC)

Available Formats

DOCX, PDF, TXT or read online from Scribd

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Attribution Non-Commercial (BY-NC)

Available Formats

Download as DOCX, PDF, TXT or read online from Scribd

0 ratings0% found this document useful (0 votes)

11 views18 pagesApuntes Psicomate 2A Parte

Uploaded by

pachilongaCopyright:

Attribution Non-Commercial (BY-NC)

Available Formats

Download as DOCX, PDF, TXT or read online from Scribd

You are on page 1of 18

CONTRASTES PARAMETRICOS PARA MAS DE DOS MUESTRAS INDEPENDIENTES CON

UN FACTOR (TEMA 12)

Se trata de comparar ms de dos muestras, ello nos dar una idea mucho mayor de la relacin que se pueda

establecer entre las variables.

Cuantos ms valores de la variable independiente se muestreen, mejor ser la evaluacin de nuestra influencia

sobre la variable dependiente dada.

Tiene por objeto estudiar la influencia de ms de dos valores de la variable independiente sobre la variable

dependiente.

Tiene la posibilidad de contrastar ms de dos valores de la variable independiente, lo cual nos dar una idea de la

relacin que se establece entre esta y la variable dependiente objeto de estudio.

Una de las caractersticas ms importantes del diseo experimental es la aleatoriedad.

La variabilidad est formada por dos partes o componentes:

Factor estudiado: (Variabilidad debida a las distintas dosis establecidas)

Error experimental: (Variabilidad debida a factores extraos y no controlados)

ANALI SI S DE VARI ANZA: Su cometido es discernir que variabilidad corresponde a cada parte.

Factor: Variable independiente.

Niveles: Categoras en que se dividen los factores o variables independientes.

Diseo de efectos aleatorios o modelo aleatorio: Da igual unas dosis que otras, siempre que se pueda establecer

un sentido ascendente o descendente.

Modelo de efectos fijos o modelo fijo: Son niveles establecidos que interesan al investigador.

Modelo no equilibrado: Las muestras son de distinto nmero de elementos.

Modelo equilibrado: Todas las muestras son iguales.

ANALI SI S DE VARI ANZA: Su finalidad es contrastar la diferencia de medias de varias muestras.

Hiptesis nula: Afirmar que no existe diferencia alguna entre las medias (en la variable dependiente) de los

distintos grupos.

Hiptesis alternativa: Afirmar que existe diferencia al menos en una de las medias (en la variable dependiente)

de los distintos grupos.

Varianza intergrupos: (Varianza entre grupo). Varianza atribuible a los distintos niveles del factor en estudio.

Varianza intragrupo: (Varianza de error). Varianza atribuible al error.

De la comparacin de ambas varianzas obtenemos la aceptacin o el rechazo de la hiptesis nula.

ANALI SI S DE VARI ANZA: Su razonamiento es el siguiente: lgicamente dentro de un mismo nivel, como el

efecto del factor es nico, las puntuaciones deberan ser semejantes, es decir, presentar una variabilidad

prcticamente nula; en tanto en cuanto esta variabilidad dentro de los grupos sea grande (dado que a todos los

sujetos de un mismo grupo se les ha dado un mismo tratamiento), es que estn influyendo factores extraos y no

controlados en el diseo. As pues la varianza dentro de cada grupo o nivel podemos considerarla como

varianza de error.

Si la varianza intergrupos es significativamente mayor que la varianza intragrupos (o de error), se admite

que hay diferencia entre los grupos; de lo contrario se acepta la hiptesis nula.

.- ANALISIS DE VARIANZA DE UN FACTOR

(Efectos fijos)

Restricciones paramtricas del anlisis de varianza:

1. Independencia de las observaciones

2. Normalidad de las distribuciones

3. Homogeneidad de las varianzas (homocedasticidad)

Suma de Cuadrados Total: Variabilidad total.

SCinter: Es la suma de la media de cada nivel menos la media total, mide la variabilidad entre los niveles. Es un

estimador sesgado pues su esperanza es igual a la varianza ms un sumando.

SCintra: Es la suma de cada puntuacin menos la media de su nivel al cuadrado, mide la variabilidad dentro de

cada nivel. Es un estimador insesgado de la varianza poblacional.

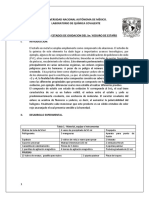

Fuentes de Variacin Suma de Cuadrados g.l. Medias Cuadrticas F

Entre niveles SCinter I-1 MCinter = SCinter / I-1 F = MCinter / MCintra

Dentro de los niveles SCintra N-I MCintra = SCintra / N-I

Total SCtotal N-1

Comparaciones mltiples: Al rechazar la hiptesis nula se est afirmando que algn B

i

es distinto de cero, pero

no se sabe cul. Al menos entre dos medias hay diferencias, para ver entre que par de medias est la diferencia

que ha hecho que se rechace la hiptesis nula.

(Efectos aleatorios)

Si el modelo es de efectos aleatorios los niveles del factor son una muestra aleatoria de todos los niveles posibles.

El modo de probar la hiptesis nula es ahora sobre su varianza.

.- COMPARACIONES MULTIPLES

Las comparaciones mltiples permiten establecer una informacin ms exacta sobre la importancia de cada uno de

los niveles de la variable independiente.

Comparaciones planificadas o a priori: Son aquellas en las que el investigador est interesado antes de llevar a

cabo el experimento.

Comparaciones no planificadas, a posteriori o post hoc: Son aquellas en que el investigador, una vez realizado

el anlisis de varianza y obtenido un resultado significativo, desea tener un conocimiento ms exacto sobe la causa

de las diferencias.

El objeto de las comparaciones mltiples es reducir la cantidad del error Tipo I que cometeramos si

comparsemos, sin ms, dos a dos todas las muestras.

H0 cierta H0 no cierta (falsa)

Aceptar H0

Error Tipo II |

No aceptar H0 (rechazar)

Error Tipo I o

o es la probabilidad de rechazar H

0

siendo cierta.

es la probabilidad de aceptar H

0

siendo falsa.

(Comparaciones planificadas o a priori)

Lo que interesa es realizar unas determinadas comparaciones entre unos grupos, pero no entre todos los que entran

en la investigacin. Para evitar la acumulacin de error de Tipo I, se acude al anlisis de varianza pero no es su

resultado lo que nos interesa, sino esas comparaciones respecto a nuestras hiptesis especficas diseadas de

antemano.

En la prctica las comparaciones planificadas son aquellas que son importantes en trminos de las variables

experimentales, si esas comparaciones son redundantes o no, no tiene demasiada importancia.

La importancia de las comparaciones planificadas radica en su naturaleza de <<a priori>>, no en su

independencia.

Comparaciones planificadas no ortogonales: () Se puede comparar todas las medias o grupos de medias que se

quiera sin preocuparse de que las comparaciones sean independientes. Los coeficientes de comparacin son

aquellos cuya suma en valores absolutos, sea igual a 2.

Comparaciones planificadas ortogonales: () Slo se pueden comparar las medias o grupos de medias cuando

k-1 son independientes.

(Comparaciones no planificadas, a posteriori o post hoc)

Son aquellas que no se deciden sino despus de que el investigador haya obtenido los resultados del anlisis de

varianza.

Prueba de Tukey (HSD): Realiza comparaciones entre pares de medias, comparaciones dos a dos, fijando la tasa

de error tipo I en o. La diferencia mnima que debe existir entre dos medias muestrales para, a partir de ah, decir

que hay una diferencia entre las correspondientes medias poblacionales. Una comparacin entre dos medias es

significativa si su diferencia, en valor absoluto, excede del valor HSD que se obtenga.

Prueba de Scheff: Permite realizar comparaciones complejas. Fija la tasa de error de tipo I en el o al que

estemos trabajando. Es ms conservadora que la anterior.

.- SUPUESTOS DEL ANALISIS DE VARIANZA

Independencia de las observaciones: Las distintas muestras o grupos a comparar hayan sido obtenidas

aleatoriamente. Tanto las muestras como las observaciones deben ser independientes.

Normalidad de las distribuciones: Las muestras o grupos deben proceder de poblaciones que se distribuyan

normalmente, en la variable estudiada.

Homogeneidad de la varianzas: Los grupos a comparar deben proceder de poblaciones que no difieran

significativamente en sus varianzas.

(Independencia de las observaciones)

Los grupos a comparar no deben estar relacionados.

Las observaciones deben ser aleatorias.

Test de Rachas: La H

0

que se establece, al aplicar esta prueba, es la de independencia de todas las observaciones.

La alternativa es que existe dependencia entre las observaciones. Es necesario dicotomizar la variable observada

utilizando la mediana como factor de dicotomizacin.

(Normalidad de las distribuciones)

Las muestras o grupo a comparar deben proceder de poblaciones que se distribuyen normalmente en la variable

estudiada.

Se aplican los test de bondad de ajuste de las observaciones a la curva normal: Chi cuadrado de Pearson, Test

de Kolmogorov - Smirnov.

(Homogeneidad de las varianza)

Los grupos deben proceder de poblaciones que no difieran significativamente en sus varianzas, en la variable

estudiada.

Esta condicin es la que ms va a distorsionar los resultados en caso de no cumplirse.

Test de Cochran (modelos equilibrados): La H

0

que se establece, es que las varianzas de las poblaciones son

iguales. La alternativa es que al menos una es distinta. Se utilizan las varianzas de los grupos o muestras que

queremos comparar, realizndose un cociente entre las varianza mayor y la suma de todas ellas.

Test de Bartlett (modelos no equilibrados): Para aplicarlo parte de las varianzas insesgadas de los grupos o

muestras y obtiene una varianza insesgada ponderada de todas ellas. Es muy sensible a la no-normalidad de los

datos, por lo que s se sospecha que stos no son normales no debe utilizarse.

(Consecuencia del no-cumplimiento de los supuestos)

No produce serias consecuencias, sobre todo cuando las muestras son equilibradas y el modelo es de efectos fijos,

debido a que F es un test robusto.

Cuando las desviaciones son importantes hay que acudir a determinadas transformaciones de las puntuaciones, que

las corrijan.

.- F<1

Aparecen a veces

Segn Snedecor no presentan mayor importancia, por atribuirlos a variaciones del muestreo.

Segn Ostle, implica o bien que no se cumplen los supuestos del anlisis de varianza; o bien que el modelo

utilizado no es el adecuado.

CONTRASTES PARAMETRICOS PARA MAS DE DOS MUESTRAS INDEPENDIENTES CON

DOS FACTORES (TEMA 13)

En el Anlisis de Varianza de un solo factor tenamos una sola variable independiente (factor) y queramos ver su

influencia sobre una variable dependiente.

En el modelo con dos factores vamos a estudiar la influencia que sobre una variable dependiente ejercen dos

variables independientes (factores) Modelo bifactorial.

.- MODELO BIFACTORIAL:

Es aquel en el que existen dos factores, de modo que todos los niveles de uno de los factores se combinan con

todos los niveles del otro factor.

Adems del modelo aleatorio y modelo fijo, existe un tercer modelo:

Modelo mixto: Es cuando un factor es de efecto fijo y el otro de efecto aleatorio.

(Modelo bifactorial sin interaccin. Efectos fijos)

Aditividad: Se cumple cuando los sumatorios de cada factor son igual a cero.

Sobre las hiptesis estadsticas, existen dos hiptesis nulas con sus correspondientes alternativas, una para cada

factor.

Supuestos: Independencia de las observaciones, Normalidad de las distribuciones y Homogeneidad de las

varianzas.

Si MCfilas es muy grande (ms de lo que cabra esperar por efecto del azar en el muestreo) respecto a MCerror se

admite que algn factor es diferente de cero. Pues en teora si los factores son igual a cero, las dos esperanzas

sern iguales y, por tanto el cociente igual a la unidad.

Si MCfilas no es muy grande respecto a MCerror se admite que los factores son igual a cero y ello implica que no

hay diferencia entre los tratamientos o niveles del factor que se est analizando.

Regin crtica: para afirmar si MCfilas es o no grande respecto a MCerror se determina por la distribucin F con

los grados de libertad del numerador y del denominador.

Fuentes de Variacin Suma de Cuadrados g.l. Medias Cuadrticas F

Entre niveles SCfilas T-1 MCfilas = SCfilas / T-1 F = MCfilas / MCerror

Dentro de los niveles SCcolumnas I-1 MCcolumnas = SCcolumnas / I-1 F = MCcolumnas / MCerror

Residual SCerror N-T-I+1 MCerror = SCerror / N-T-I+1

Total SCtotal N-1

(Modelo bifactorial con interaccin. Efectos fijos)

Adems de la influencia que ejercen por separado cada uno de los factores, existe tambin una influencia debida a

la interaccin entre los factores, es decir, que el efecto producido por los niveles de uno de los factores, depende

de los niveles del otro factor.

Con respecto a las hiptesis estadsticas existen tres hiptesis nulas (con sus correspondientes alternativa) una

para cada factor y otra para la interaccin.

La variabilidad total o suma de cuadrados total (SCtotal) se descompone en la suma de cuatro variabilidades:

SCtotal = SCfilas + SCcolumnas + SCinteraccin + SCerror

La MCerror es un estimador insesgado de la varianza poblacional.

La MCfilas y la MCcolumnas son estimadores sesgados pues su esperanza es igual a la varianza poblacional ms un

sumando.

La MCinteraccin es tambin un estimador sesgado con un sesgo aditivo, funcin de la interaccin de los factores A

y B.

Regin crtica: para afirmar si MCfilas es o no grande respecto a MCerror se determina por la distribucin F con

los grados de libertad del numerador y del denominador.

El primer valor de F que debemos probar es el debido a la interaccin, pues, si aceptamos la hiptesis nula de la

interaccin, es decir que esta no existe, el modelo se considera aditivo.

Fuentes de Variacin Suma de

Cuadrados

g.l. Medias Cuadrticas F

Entre filas SCfilas T-1 MCfilas = SCfilas / T-1 F = MCfilas / MCerror

Entre columnas SCcolumnas I-1 MCcolumnas = SCcolumnas / I-1 F = MCcolumnas / MCerror

Interaccin SCinteraccin (T-1)(I-1) MCinteraccin = SCinterac / (T-1)(I-1) F = MCinteracc / MCerror

Residual SCerror TI(n-1) MCerror = SCerror / TI(n-1)

Total SCtotal N-1

Si el modelo no es equilibrado los clculos son los mismos salvo que en el denominador habra que poner la

cantidad de individuos que componen cada muestra.

( Efectos fijos, aleatorios y modelo mixto)

Modelo de efectos fijos: Los niveles en los que trabajamos, en ambos factores, son los que nos interesan y sobre

los que hemos de realizar la inferencia.

Modelo de efectos aleatorios: En los dos factores, los niveles de la variable independiente con los que estamos

trabajando son una muestra posible de todos los posibles niveles.

Las hiptesis no se plantean sobre las medias poblacionales de los efectos de los factores, sino sobre sus varianzas.

La varianza de todas las medias ser cero cuando todas ellas sean iguales.

Modelo mixto: Uno de los factores es de efectos fijos y el otro de efectos aleatorios.

Modelo bifactorial aditivo: La muestras aleatorias de niveles se suponen distribuidas N(0,o

B

) para el factor B y

N(0,o

A

) para el factor A.

Modelo bifactorial aditivo con efectos aleatorios:

Las hiptesis no se plantean sobre las medias poblacionales de los efectos de los factores, sino sobre sus varianzas.

La varianza de todas las medias ser cero cuando todas ellas sean iguales.

.- MODELO CON CLASIFICACION SUBORDINADA O JERARQUICO

Ciertos niveles de un factor estn ligados a ciertos niveles del otro, es decir, que ciertos niveles de un factor slo

pueden darse en ciertos niveles del otro.

No se pueden cruzar los factores.

En el modelo de efectos fijos las hiptesis nulas a probar son: que todas las B

i

= 0 y que todas las A

t(i)

= 0. Si las

dos hiptesis se aceptan, el efecto del tratamiento es .

Respecto a las hiptesis estadsticas se tienen dos hiptesis nulas (con sus correspondientes alternativas) una para

cada factor.

La variabilidad total o suma de cuadrados total (SCtotal) se descompone en la suma de tres variabilidades:

SCtotal = SCprincipal + SCsecundario + SCerror

Regin crtica: para afirmar si MCprincipal es o no grande respecto a MCerror se determina por la distribucin F

con los grados de libertad del numerador y del denominador.

CONTRASTES PARAMETRICOS PARA MAS DE DOS MUESTRAS DEPENDIENTES:

ANALISIS DE VARIANZA CON MEDIDAS REPETIDAS CON UN FACTOR (TEMA 14)

ALEATORIZACIN: Es la asignacin de los sujetos al azar a los distintos niveles del factor para que todos

tengan la misma probabilidad de recibir un nivel concreto. (Se aplica el mismo tratamiento a todos lo sujetos de

la muestra).

+ Con esto se consigue que las variables extraas al experimento estn repartidas aleatoriamente entre grupos.

+ Puede ocurrir que el influjo de alguna variable extraa sea tan importante que llegue a distorsionar los posibles

efectos atribuibles a los tratamientos

DISEO DE BLOQUES HOMOGNEOS: Los bloques estarn constituidos por k sujetos homogneos,

similares en cuanto a la variable extraa se refiere. Los tratamientos se asignan al azar dentro de cada bloque, de

modo que cada tratamiento aparezca una sola vez en cada uno. Por ello el diseo se llama aleatorizado en bloques

completos. (Un bloque / sujeto pasa o se le aplican todos los tratamientos del contraste).

+ Los diseos de medidas repetidas o con ms de dos muestras dependientes, son muy importantes en los trabajos

experimentales porque los elementos que forman la poblacin estadstica suelen ser personas y stas pueden dar

una gran variedad de respuestas ante los mismos tratamientos.

+ Es importante poder separar la fuente de variabilidad intersujetos del efecto de los tratamientos del error

experimental, ya que lo que nos interesa primordialmente es la diferencia entre tratamientos y no entre

personas.

+ Uno de los objetivos principales de los experimentos en que se evala al sujeto bajo cada uno de los tratamientos

es conseguir un control de las diferencias entre sujetos. En estos experimentos se miden los efectos del tratamiento

para el sujeto j, con respecto al promedio de respuestas dadas por ese sujeto a todos los tratamientos. As cada

sujeto acta como su propio control.

+ Estos diseos conllevan el peligro de que la secuencia en que se les pasan los tratamientos influya en los

resultados.

.- MODELOS Y SUPUESTOS

+ Este modelo de medidas repetidas requiere de un supuesto adicional referido al nuevo trmino P

j

. El modelo

supone que Pj es una variable aleatoria distribuida normalmente e independientemente de los B

j

y los c

ij

. Vamos a

llamar aditividad a esta condicin de independencia entre los P

j

, los B

j

y los c

ij

. Este supuesto implica que los

tratamientos no interactan con los sujetos: unos tratamientos difieren o no de otros independientemente de los

sujetos sobre los que se aplican. Como adems los errores se suponen aleatorios, las varianzas de cada sujeto sern

iguales. Y como consecuencia de esto y de la independencia entre los P

j

y los cij, las covarianzas entre las

puntuaciones de cada par de tratamientos sern tambin iguales. Todo ello est reflejado en el modelo pues los

componentes B

j

y los P

j

estn combinados aditivamente (se suman), no existiendo ningn trmino referido a la

interaccin entre ambos.

+ Los supuestos a verificar son:

1. Las n observaciones bajo cada tratamiento son aleatorias e independientes.

2. Las I poblaciones - tratamiento tienen distribucin normal.

3. Las I poblaciones - tratamiento tienen la misma varianza.

4. Las I(I-1)/2 covarianzas entre las I poblaciones - tratamiento son iguales (aditividad o no-interaccin personas

- tratamiento). Este supuesto es una condicin suficiente pero no necesaria. Una condicin necesaria y

suficiente tiene que ver con las varianzas de las diferencias entre cada par de tratamientos (supuesto de

circularidad).

5. Variable medida, al menos, a nivel de intervalo.

+ Variabilidad del sistema:

SCtotal = SCintersujetos + SCintrasujetos

+ La diferencia entre dos observaciones del mismo sujeto (que genera la variabilidad intrasujetos), depende en parte

de la diferencia debida a los efectos de los tratamientos y en parte a la varianza residual o error (los efectos

incontrolados.

.- ESTADISTICO DE CONTRASTE.

+ La hiptesis nula del modelo que queremos contrastar es que las I medias (

i

) del factor B son iguales (B

i

= 0 para

todo i).

.- CALCULOS

+ Las medias cuadrticas se obtienen dividiendo las correspondientes sumas cuadrticas por sus respectivos g.l., y la

razn F=MCtrat. / MCerror contrasta la hiptesis de que las medias de los tratamientos no difieren entre s.

Fuentes de Variacin Suma de

Cuadrados

g.l. Medias Cuadrticas F

Intersujetos SCintersuj n-1 MCintersuj = SCintersuj / n-1

Intrasujetos SCintrasuj n(I-1) MCintrasuj = SCintrasuj / n(I-1)

Tratamientos SCtrat I-1 Mctrat = SCtrat / I-1 F = MCtrat / MCerror

Error SCerror (n-1)(I-1) MCerror = SCerror / (n-1)(I-1)

Total SCtotal In-1

.- SUPUESTO DE ADITIVIDAD, SIMETRIA COMPUESTA Y CIRCULARIDAD

ADITIVIDAD: Cuando la interaccin entre los tratamientos y los sujetos es nula.

SIMETRA COMPUESTA: Las I varianzas de los I tratamientos tiene que ser iguales (homocedasticidad) y

asimismo tiene que ser iguales las I(I-1)/2 covarianzas entre los I tratamientos (lo que significa que la correlacin

entre cada par de tratamientos debe ser la misma).

CIRCULARIDAD O ESFERICIDAD: En el modelo de medidas repetidas o bloques es que las varianzas de las

diferencias entre cada dos tratamientos son iguales en la poblacin.

+ Este supuesto de circularidad es condicin necesaria y suficiente para que el estadstico F tenga distribucin

muestral exacta.

+ La condicin necesaria y suficiente tiene que ver ms bien con las varianzas de las diferencias entre cada par de

tratamientos. Puesto que todos los sujetos reciben los I tratamientos, es posible reorganizar los datos en trminos

de todos los posibles pares de combinaciones entre tratamientos.

+ Cumple las dos condiciones anteriores y es menos objetable.

+ Si el supuesto de circularidad no se cumple, se corre el riesgo de que la utilizacin del estadstico de contraste F

nos lleve a conclusiones errneas ya que aumenta el error Tipo I.

AJUSTE DE BOX: Se pueden ajustar los grados de libertad del estadstico F para compensar el posible no-

cumplimiento de este supuesto.

.- COMPARACIONES MULTIPLES

+ Depende de s se puede asumir el supuesto de circularidad o no.

(Asumiendo el supuesto de circularidad)

+ Sustituyendo la MCerror de sus respectivos estadsticos por las MCerror (intrasujetos).

+ Test de Tukey: Las diferencias entre las medias de dos tratamientos i y g sern significativas si su diferencia en

valor absoluto es mayor (>) o igual (=) el valor del criterio denominado HSD (Honestly Significant Difference).

+ Test de Scheff:

(Sin asumir el supuesto de circularidad)

+ Cuando no podemos asumir el supuesto de circularidad, las comparaciones mltiples tambin se pueden llevar a

cabo mediante Tukey o Scheff, sustituyendo la MCerror de sus respectivos estadsticos por una MCerror especfica

de cada comparacin a realizar y utilizando slo (n-1) g.l. asociados al error en lugar de (n-1)(I-1) como en el caso

anterior.

+ Test de Tukey:

+ Test de Scheff: El valor del estadstico de contraste F se compara con el valor del criterio de Scheff al cuadrado,

pero utilizando (n-1) g.l. asociados al error (este procedimiento es equivalente al habitual)

CONTRASTES PARAMETRICOS PARA MAS DE DOS MUESTRAS DEPENDIENTES:

ANALISIS DE VARIANZA CON MEDIDAS REPETIDAS CON DOS FACTORES (TEMA 15)

En un factor todos los sujetos pasaban por todas las condiciones experimentales.

Con dos factores tendremos que utilizar los mismos sujetos, en todas o parte de las TI combinaciones entre los

niveles de los tratamientos.

El modelo es aditivo en lo relativo al efecto de los sujetos.

La variable dependiente est medida al menos a nivel de intervalo.

(Variabilidad del sistema)

SCtotal = SCintertrat + SCsujetos + SCerror

(Estadstico de contraste)

Las tres hiptesis principales del modelo que se quiere contrastar son:

1. Las T medias

t

del factor A son iguales (A

t

= 0 para todo t).

2. Las I medias

i

del factor B son iguales (B

i

= 0 para todo i).

3. El efecto de la interaccin es nulo (Ab

ti

= 0 para toda combinacin ti).

De los valores esperados de cada una de las medias cuadrticas del modelo se deduce que el efecto de cualquiera

de las fuentes de variacin puede comprobarse por medio del cociente entre su media cuadrtica y la media

cuadrtica error.

(Comparaciones mltiples)

Si asumimos el supuesto de circularidad, valdran todos los procedimientos de comparaciones mltiples del

modelo de dos factores completamente aleatorizados de clasificacin cruzada (aquellos donde cada nivel de un

factor se combina con todos los niveles del otro factor, a diferencia del modelo jerrquico).

nicamente hay que tener en cuenta que los grados de libertad de las medias cuadrticas error son ahora

diferentes, es decir, en lugar de ser (n-1)(TI) como ocurra en el caso de dos factores con muestras independientes,

en este caso sern (n-1)(TI-1).

.- ANALISIS DE VARIANZA DE DOS FACTORES CON MEDIDAS REPETIDAS EN UNO DE

ELLOS.

En este diseo todos los n sujetos pasan por todos los niveles de uno de los factores (en este caso por los niveles

del factor B), pero por un solo nivel del otro (los n

1

sujetos slo pasarn por A

1

).

Uno de los factores aqu el B, es intrasujetos mientras que el otro el A, es intersujetos, de ah que a este diseo se

le suele llamar mixto o tambin split-plot.

(Variabilidad del sistema)

SCtotal = SCintersujetos + SCintrasujetos

(Estadstico de contraste)

Las tres hiptesis principales del modelo que se quiere contrastar son:

1. Las T medias

t

del factor A son iguales (A

t

= 0 para todo t).

2. Las I medias

i

del factor B son iguales (B

i

= 0 para todo i).

3. El efecto de la interaccin es nulo (Ab

ti

= 0 para toda combinacin ti).

CONTRASTES NO PARAMETRICOS PARA MAS DE DOS MUESTRAS (TEMA 16)

La prueba F es un test robusto o fuerte (es decir, pueden apreciarse desviaciones en los supuestos sin que los

resultados se vean seriamente afectados).

En ocasiones las desviaciones son tan grandes que resulta imposible acudir a la distribucin F y tenemos que

acudir a pruebas no paramtricas que aunque tienen la ventaja de tener menos restricciones, tambin suelen tener,

como contrapartida, una potencia menor.

.- CONTRASTES NO PARAMETRICOS PARA MAS DE DOS MUESTRAS INDEPENDIENTES.

(Test de Kruskal Wallis)

Se trata de una generalizacin del test de Wilcoxon, para tres o ms muestras independientes.

Se utiliza cuando el nivel de medida de los datos no est en una escala de intervalo.

Se utiliza en diseos de un solo factor.

Cuando la distribucin de la variable es continua.

Las k muestras que se quieren comparar son aleatorias e independientes.

Se necesita al menos una medida ordinal de la variable.

Este test pone a prueba si la diferencia entre la suma de los rangos de cada columna es significativa, dado que si el

factor cuya influencia estamos estudiando no produce efectos distintos en la variable, las diferencias que se

aprecien entre las puntuaciones, se distribuirn al azar y, por lo tanto, tambin lo harn los rangos.

Mientras que si el factor influye, las diferencias no estarn al azar sino que una (o unas) determinada/s columna/s

tendr/n valores superiores a las otras y, por lo tanto puntuaciones de rango tambin mayores, y la suma de esa

columna ser significativamente mayor que las otras.

(Test de Jonckheere)

Tambin es una generalizacin del test de Wilcoxon para ms de dos muestras independientes, como el test de

Kruskal Wallis.

La diferencia entre ambas pruebas est en que el test de Jonckheere asume no slo que la variable est medida a un

nivel ordinal sino que se establece un orden de prediccin (prelacin, ordenacin natural) entre los factores

cuyo efecto se quiere probar.

Este orden predictivo debe hacerse independientemente de los datos.

Se utiliza en diseos de un solo factor cuando la distribucin de la variable es continua.

Las k muestras que se quieren comparar son aleatorias e independientes, establecindose un orden de prediccin

entre ellas.

Se necesita al menos una medida ordinal de la variable.

Si el nmero de muestras es mayor de tres y/o el nmero de observaciones en alguna de ellas es mayor de cinco, el

estadstico de contraste (S) se aproxima a la distribucin normal.

.- CONTRASTES NO PARAMETRICOS PARA MAS DE DOS MUESTRAS RELACIONADAS.

(Test de Friedman)

Es la contrapartida de la de Kruskal Wallis cuando las muestras estn relacionadas.

Es equivalente al test de Signos cuando comparbamos slo dos muestras.

Ms de dos muestras equilibradas y relacionadas.

Asume que los resultados de los sujetos (las observaciones) son independientes y que son un conjunto de datos

ordinales.

(Test de Crochan)

Es una generalizacin de McNemar, para ms de dos muestras relacionadas.

Sirve para probar si tres o ms conjuntos de frecuencias o proporciones difieren significativamente entre s.

Tres o ms muestras aleatorias, relacionadas y equilibradas.

Los datos sean dicotmicos o se puedan dicotomizar (en los referente a la escala de medida).

REGRESION LINEAL Y CORRELACION SIMPLE (TEMA 17)

- El anlisis de regresin lineal simple estudia la naturaleza de las relaciones entre dos variables, X e Y, con el

objetivo fundamental de hacer predicciones.

- Se considera que se trata de variables cuantitativas (medidas en una escala de intervalo o de razn) que mantienen

entre s una relacin lineal.

- Y

i

= o + |X

i

donde o y | son constantes y reciben el nombre de ordenada en el origen y pendiente.

- El problema consiste en determinar los parmetros de esta recta de regresin haciendo mnimos los errores en

nuestras predicciones de Y, ya que sabemos que dichas predicciones no sern nunca exactas a causa de la

variabilidad o dispersin de las puntuaciones que se apartan de la recta de regresin (mtodo de mnimos

cuadrados).

- El objetivo del anlisis de correlacin lineal simple es estudiar la fuerza o intensidad de la relacin entre

estas dos variables cuantitativas. Para este propsito se utilizar el coeficiente de correlacin de Pearson, r

xy

.

.-REGRESION LINEAL SIMPLE.

(Introduccin a la regresin)

- La regresin mltiple permite analizar la relacin entre una variable dependiente cuantitativa (variable criterio) y

una o ms variables independientes o predictoras que pueden ser cuantitativas y binarias.

- El anlisis de regresin tiene dos vertientes, una descriptiva y otra inferencial.

- La ecuacin de la recta viene dada por: Y = o + |X donde o indica el valor de Y para X=0 (punto de corte de la

recta con el eje de ordenadas) y | representa su pendiente, es decir, el incremento de Y por cada unidad que se

incrementa X.

- Los coeficientes A y B obtenidos con el criterio de mnimos cuadrados son los estimadores de los parmetros o y

| de la recta de regresin definida en la poblacin.

- El estimador de la varianza residual, puede interpretarse como una medida de la bondad de ajuste de la regresin a

los puntos en los casos en que se puede asumir la normalidad de los errores. Cuando no se verifica este supuesto

no podemos hacer inferencias con respecto al parmetro, de ah la necesidad de definir un nuevo estadstico

denominado coeficiente de determinacin, que nos ayude a interpretar el significado de la varianza residual en

los casos que no se asume el supuesto de normalidad.

- El coeficiente de determinacin: Es posible descomponer la variacin total de la variable Y en la parte explicada

por la recta de regresin ajustada y en la no explicada o residual.

- Si la recta de regresin ha sido ajustada con el criterio de mnimos cuadrados se demuestra que la suma de

cuadrados de las desviaciones totales, denominada varianza total, se descompone de igual manera que en el

anlisis de varianza (propiedad aditiva de la suma de cuadrados).

- En primer trmino: La suma de cuadrados total (SCtotal) es el error total o desviacin total. Se puede considerar

como el error cometido al pronosticar a un individuo la puntuacin media total, cuando no se usa la ecuacin de

regresin para esta finalidad.

- En segundo trmino: La suma de cuadrados debida a la regresin de Y sobre X (SCreg) y es la cantidad de error

eliminado o explicado cuando la recta de regresin se ajusta a los puntos de la muestra.

- En tercer trmino: La suma de cuadrados residual o error (SCresidual) es la desviacin con respecto a la recta de

regresin o error no explicado; es el error que todava queda despus de aplicar la recta de regresin.

- La varianza error o varianza de las desviaciones de la regresin, no es ms que la media cuadrtica de los errores

no explicados por la recta de regresin (MCresidual). Cuando estos errores son cero, Y

i

coincidir con la recta y

tendremos un ajuste perfecto de los puntos a la recta.

- El ajuste perfecto se presenta cuando la recta de regresin explica completamente la variacin total, es decir,

cuando la variacin explicada por la recta de regresin es igual a la varianza total. En este caso la varianza residual

ser nula y todos los puntos estarn sobre la recta de regresin.

- El ajuste nulo se presenta cuando la regresin no explica nada de la variacin total, es decir, cuando la variacin

explicada por la regresin es cero. En este caso la variacin residual coincide con la variacin total y la recta de

regresin es horizontal.

- Para mejorar el porcentaje de varianza explicada y el ajuste:

1. Efectuar transformaciones de las variables para mejorar la linealidad de la nube de puntos.

2. Disminuir los errores de medicin de las variables dependientes y el error aleatorio asociado al entorno

experimental y a las tcnicas utilizadas.

3. Incorporar nuevas variables predictivas y realizar un ajuste mediante tcnicas de regresin mltiple.

(El modelo de la regresin lineal simple)

- Supuestos:

1. La variable X, que podemos llamar independiente o predictora presenta unos valores prefijados de antemano,

no es una variable aleatoria sino fija

2. La variable Y es aleatoria y para cada uno de los valores fijos de X existe una distribucin de valores de Y o

una subpoblacin total de valores de Y. Se requiere que tanto la variable dependiente como la

independiente estn medidas al menos a nivel de intervalo.

3. Si suponemos que los valores medios

y/x

estn situados sobre una recta, esta recta ser la llamada lnea de

regresin verdadera y su ecuacin: E(Y/X

i

) =

y/x

= o + |

xj

es la regresin lineal poblacional de Y sobre X,

que nos da los valores esperados o medias de Y, E(Y), dado el valor fijo de X.

4. Llamaremos Y

ij

a la puntuacin obtenida por una persona i de la subpoblacin de Y, dado X=x

j

.

5. Yi y cij son variables aleatorias, ya que no podemos conocer con certeza cual ser un valor dado de E(Yj).

6. Homocedasticidad: La varianza Var(Y/X) es la varianza de la regresin. Se supone que es constante para las

distintas subpoblaciones de Y. Esta varianza es lo mismo que la varianza de los errores.

7. c

ij

es estadsticamente independiente de x

j

. Los distintos c

ij

son independientes.

8. Los valores Y

i

, Y

k

pertenecientes a subpoblaciones diferentes son estadsticamente independientes.

9. Para poder hacer contrastes de hiptesis a partir de las estimaciones muestrales, es necesario incluir el

supuesto de distribucin normal de los errores, y en consecuencia de la variable Y, que es funcin lineal

de stos.

- Propiedades de los estimadores A y B: Los estimadores de o y | que nos proporciona el mtodo de mnimos

cuadrados, presentan una serie de caractersticas deseables en un buen estimador:

1. Linealidad en las Y.

2. Carencia de sesgo: A y B son estimadores insesgados de o y |.

3. Varianza mnima: A y B son estimadores de varianza mnima.

.- CONTRASTE DE HIPOTESIS PARA LOS PARAMETROS DE LA REGRESION LINEAL

SIMPLE.

- Para cada parmetro se establecer nicamente una hiptesis alternativa y se realizar slo el contraste bilateral.

- Se asumen los supuestos del modelo de regresin lineal, supuesto de normalidad y que las dos variables estn

medidas al menos a nivel de intervalo.

(Determinacin de intervalos de confianza para valores concretos Y

ij

)

- La diferencia entre el valor real y el pronosticado, lo llamaremos error de pronstico. Estos errores

constituirn una variable normalmente distribuida por ser combinacin lineal de variables normales y su

distribucin vendr definida por su media y su varianza.

.- CONTRASTE DE HIPOTESIS PARA LA ECUACION DE LA REGRESION.

- SCresid = SCtotal - SCreg

.- MODELO DE LA CORRELACION LINEAL SIMPLE.

- En el modelo de la regresin lineal simple se consideraba a la variable X como predictora o independiente y a la

variable Y como criterio o dependiente, siendo objetivo del estudio conjunto de X e Y, la prediccin de valores de

Y a partir del conocimiento de los valores de X.

- El objetivo principal del anlisis de la correlacin se centra en averiguar la fuerza de la relacin entre las

variables, es decir, el objetivo es estudiar la variacin conjunta o covariacin de dos variables aleatorias X

e Y.

- Se le denomina modelo de correlacin lineal simple porque slo involucra dos variables y supone que estn

relacionadas de modo lineal. Y

i

= o + |X + c

i

.

- o

xy

es la covarianza, una medida de covariabilidad o varianza comn entre X e Y.

- Supuestos: Como no tenemos informacin acerca de la correlacin en la poblacin, debemos tenerla a partir de

una muestra y para que las inferencias sean vlidas, se debern cumplir los siguientes supuestos.

1. Las dos variables X e Y son variables aleatorias y se requiere que estn medidas al menos a nivel de

intervalo.

2. Su funcin de densidad de probabilidad conjunta debe ser la bivariada normal.

- Una poblacin bivariante normal es aquella que, entre otras cosas, representa la distribucin conjunta de dos

variables X e Y, ambas normalmente distribuidas. El coeficiente de correlacin poblacional como medida de la

covariacin de X e Y supone una distribucin bivariada.

3. Para cada valor de X hay una subpoblacin de valores Y distribuida normalmente.

4. Las n subpoblaciones tienen sus medias en la misma lnea recta.

.- CONTRASTE DE HIPOTESIS PARA EL COEFICIENTE DE CORRELACION DE PEARSON.

- Se necesita conocer su distribucin muestral. Para que esto sea posible, se necesita que la poblacin tenga una

distribucin bivariante normal.

.- CONTRASTE DE HIPOTESIS PARA OTROS COEFICIENTES DE CORRELACION.

( Coeficiente de correlacin biserial puntual,

bp

)

- Se utiliza cuando se relaciona una variable cuantitativa X, con otra variable Y, que slo admite dos valores

(dicotmica o dicotomizada).

- La hiptesis nula para el coeficiente de correlacin biserial puntual es equivalente a contrastar la hiptesis de que

las medias de las puntuaciones de los dos grupos establecidos mediante al variable dicotmica son iguales.

( Coeficiente de correlacin de Spearman,

s

)

- Se utiliza cuando nos encontramos dos variables medidas en una escala ordinal (no es ms que el coeficiente

de correlacin de Pearson aplicado a n pares de observaciones de las que nicamente consideramos sus

propiedades ordinales).

( Coeficiente de correlacin Phi, |)

- Se utiliza con dos variables dicotmicas o con dos variables de naturaleza continua que se han

dicotomizado.

REGRESION Y CORRELACION LINEAL MULTIPLE (TEMA 18)

El modelo de correlacin lineal simple se generaliza a un modelo de regresin lineal mltiple cuando se

incorporan ms variables predictoras.

Una forma de acercarnos ms a la realidad de un problema psicolgico es identificarlo al mayor nmero posible de

fuentes de variacin que influyan en la variabilidad del mismo.

Cuando queremos estimar la contribucin de dos a ms variables independientes actuando sobre una variable

dependiente es cuando podemos utilizar el anlisis de regresin lineal mltiple, siempre que se cumplan los

supuestos para su aplicacin.

El objetivo es determinar a partir de los datos obtenidos en la muestra de n sujetos, el hiperplano de mnimos

cuadrados.

.- MODELO Y SUPUESTOS.

Slo nos vamos a referir al modelo de regresin lineal mltiple para valores fijos de las variables X

j

.

Es un conjunto particular de valores de X fijados para el cual existe una subpoblacin de valores de Y,

normalmente distribuidos, cuya media se encuentra sobre el hiperplano de regresin, siendo iguales las varianzas

de las distintas subpoblaciones de Y.

El hiperplano sobre el que se encuentra las medias de Y es el hiperplano de regresin de la poblacin.

Los errores c

j

al igual que ocurra en la regresin lineal simple, presentan la propiedad de estar normalmente

distribuidos con media 0 y varianza.

La variable dependiente como las independientes estn medidas al menos a nivel de intervalo.

.- INTERPRETACION DE LA ECUACION DE REGRESION.

(Coeficientes de regresin parcial)

Los trminos B

j

de la ecuacin de regresin se denominan coeficientes de regresin parcial, y representan el

cambio promedio en la variable Y correspondiente a un incremento de una unidad en la variable X

j

cuando las

restantes variables independientes de la ecuacin se mantienen constantes.

(Coeficientes de regresin tipificados o coeficientes Beta)

Estos se crearon con el propsito de dar una interpretacin ms clara del peso (o la importancia relativa) de la

diferentes variables independientes X

j

, para el pronstico de la variable dependiente.

(Coeficientes de determinacin mltiple y correlacin mltiple)

Se desea conocer la bondad de ajuste del plano de regresin construido a los datos muestrales.

La desviacin de cada una de las puntuaciones individuales con respecto a este plano, puede presentarse como

(Y

j

- Y) y se denominar desviacin o error total.

El coeficiente de determinacin mltiple expresar la relacin de la varianza explicada por medio de la regresin

(SCreg) con respecto a la varianza total (SCtotal) de la variable.

El coeficiente de correlacin mltiple es la raz cuadrada del coeficiente de determinacin.

.- CONTRASTE DE HIPOTESIS EN REGRESIN MULTIPLE.

(Contraste de hiptesis para los parmetros de la regresin lineal mltiple)

Los estimadores de los coeficientes de regresin poblacionales |

j

son los coeficientes de regresin muestrales B

j

.

El parmetro o, que es la altura del plano de regresin poblacional por medio de A.

.- COEFICIENTES DE CORRELACION PARCIAL Y CORRELACION MULTIPLE.

Correlacin parcial: Medida del grado de covariacin entre variables residuales de las que se ha eliminado el

influjo de una o ms variables.

Correlacin esprea: Es aquella en la que la relacin entre dos variables est correlacionada con una tercera

variable que tambin puede utilizarse como predictor.

ANALISIS DE VARIANZA Y ANALISIS DE REGRESION (TEMA 19)

En el ANOVA se consideraba una variable independiente categrica de efectos fijos, no aleatorios. En el anlisis

de regresin tambin disponemos de una variable independiente de valores fijados.

En el ANOVA hacamos el supuesto de que los errores eran independientes, con distribucin normal, media cero y

varianza; y el mismo supuesto se haca en el anlisis de regresin.

En el ANOVA se contrastaba la hiptesis de la igualdad de medias de los tratamientos y en el anlisis de regresin

se contrastaba la igualdad de pendientes a cero.

En ambas tcnicas se descompona la varianza de la variable dependiente.

Ambas tcnicas son ejemplos del mismo modelo lineal general.

.- EL MODELO LINEAL GENERAL.

Y = f(u, X) + c representa el modelo lineal general, donde Y, los datos empricos constituyen un conjunto de

medidas u observaciones tomadas sobre una o ms variables dependientes en funcin de una o ms variables

independientes; f(u, X).

Se denomina lineal porque en su formulacin se establece una funcin lineal entre la variable dependiente y

los parmetros.

Es general porque no especifica la naturaleza precisa de las variables, tanto independientes como

dependientes, ni del trmino error.

La linealidad o no-linealidad de este modelo se determina por la forma en que los parmetros entran en el

modelo y no por la forma en que lo hacen las variables independientes.

Modelos probit y logit representan casos particulares del modelo de regresin lineal cuando la variable

dependiente es cualitativa.

(El modelo de regresin lineal)

Con una variable independiente o explicativa, X, y una variable dependiente o explicada, Y, ambas

cuantitativas.

Los supuestos bsicos sobre los errores, que debe satisfacer el modelo de regresin lineal con una variable

independiente y una variable dependiente, son:

1. Los errores tienen esperanza nula

2. La varianza del error es constante y no depende de los valores que toma X.

3. Los errores son independientes entre si.

4. Los errores se distribuyen normalmente.

El incumplimientos de los supuestos (2) y (3) se llama heterocedasticidad y correlacin serial (o

autocorrelacin), respectivamente.

La cuatro condiciones anteriores pueden expresarse igualmente respecto a la variable dependiente:

1. La esperanza de la variable dependientes Y

i

, donde Y

i

es una variable aleatoria, es funcin lineal de los

parmetros |

0

y |

1

, y de la variable independiente X

i

, donde X

i

, es una variable fija no aleatoria.

2. La varianza de la distribucin de Y

i

para cada valor de X

i

es constante.

3. Las observaciones Y

i

son independientes entre s.

4. La distribucin de Yi para cada valor de X

i

es normal.

La variable dependiente debe ser cuantitativa y medida al menos, en una escala de intervalo.

(Los modelos de diseo experimental: el modelo de anlisis de varianza)

Lo que en modelo de regresin mltiple son las variables independientes, en estos modelos de diseo son

especficamente los tratamientos o niveles del factor o condiciones manipuladas por el experimentador.

Los supuestos son:

1. Independencia.

2. Normalidad.

3. Homocedasticidad.

4. Linealidad.

El modelo de anlisis de varianza ms simple es el modelo de anlisis de varianza unifactorial, en el que

tratamos de comparar un nmero I de niveles de un factor o variable independiente, y se mide una caracterstica Y

en cada sujeto.

La MCintra y la MCtotal son estimadores insesgados de la varianza poblacional. La MCinter es un estimador

insesgado de la varianza poblacional slo si la hiptesis nula es verdadera, es decir, si las medias de cada

tratamiento son iguales.

.- ANALISIS DE REGRESION CON VARIABLES INDEPENDIENTES CATEGORICAS.

Variable categrica o nominal o atributo: Es aquella en la que las observaciones difieren en tipo, pero no en

cantidad.

El objetivo ser determinar si la razn de correlacin o determinacin uso de la informacin que proporciona la

pertenencia a un grupo o clase reduce los errores de pronstico de la variable dependiente.

(La razn de correlacin o de determinacin)

El coeficiente de determinacin mide el grado de linealidad o de aproximacin de los puntos a la recta de

regresin y sobre X, mientras que la razn de correlacin o determinacin indica el grado de relacin que puede

ser de cualquier tipo, no necesariamente lineal. Se suele utilizar como medida de la relacin curvilnea entre dos

variables.

X puede ser cuantitativa o categrica, pero nunca se tendr en cuenta sus valores numricos para el clculo de la

razn de correlacin o determinacin.

(Uso de variables mudas en la ecuacin de regresin)

Se puede indicar la pertenencia a un grupo o categora mediante el uso de una variable muda.

Variable muda: Es un vector mediante el cual a los miembros de una categora dada se les asigna un nmero

arbitrario, mientras que en todos los sujetos que no pertenecen a dicha categora se les asigna otro nmero tambin

arbitrario.

Este tipo de variables son muy importantes en el anlisis de regresin cuando alguna de las variables

independientes es categrica.

El introducir una variable auxiliar muda es slo uno de los posibles sistemas de codificacin.

.- COMENTARIOS SOBRE LOS USOS DEL ANALISIS DE VARIANZA Y EL ANALISIS DE

REGRESION.

La intercambiabilidad entre ambos mtodos se puede extender ms all del modelo equilibrado de efectos fijos y

un solo factor. Se pueden utilizar procedimientos de regresin mltiple para todos los diseos de efectos fijos sean

equilibrados o no.

A pesar de que los dos mtodos son intercambiables, el mtodo de la regresin lineal mltiple ser preferible al

ANOVA en los siguientes casos.

1. Cuando la variable independiente es cuantitativa, ya que en estos casos puede haber usualmente

desviaciones de la linealidad y el anlisis de regresin es ms sensible.

2. Cuando mezclamos en un mismo anlisis variables cuantitativas y categricas.

3. Cuando las frecuencias de las distintas casillas en un diseo factorial son distintas y no proporcionadas.

4. Cuando estudiamos tendencias en los datos.

Frecuentemente la regresin mltiple es el mejor mtodo de anlisis de los datos no experimentales.

ANALISIS DE COVARIANZA (UN FACTOR) (TEMA 20)

E Existen dos mtodos generales para el control de la variabilidad debida al error experimental: el control

experimental directo y el control estadstico o indirecto.

E Un ejemplo de control indirecto sera el anlisis de covarianza o ANCOVA.

E El ANCOVA proporciona el control estadstico de una o ms variables que puedan afectar a los resultados de un

experimento, tratando de analizar cmo habran sido los resultados del anlisis de varianza si se hubieran

controlado o mantenido constantes estas variables.

E En el ANCOVA ms sencillo, existe un factor B dividido en I niveles o tratamientos y tambin existe una variable

dependiente cuantitativa Y al igual que en el caso del anlisis de varianza. Sin embargo, adems existe otra

variable cuantitativa X que representa una fuente de variacin sobre Y que se aade a la debida al factor B. Los

diversos niveles del factor B pueden tambin diferir en funcin de los valores medios de X. Cuando esto ocurre

as, las diferencias encontradas entre las medias de Y en los niveles de B pueden no deberse nicamente al efecto

de B sino a la regresin de Y sobre X. El problema de la variable extraa X se podra evitar haciendo grupos

experimentales para los distintos niveles de B que tengan los mismos valores medios en X.

E En todos estos casos podemos recurrir al ANCOVA como un mtodo para ajustar los niveles del factor B una vez

que se ha realizado el experimento.

E Si realmente la variable extraa X se hubiera mantenido constante; esta ltima variable la denominaremos

concomitante o covariante, mientras que la variable Y ser simplemente la variable dependiente.

E Las tcnicas utilizadas para realizar este ajuste estn basadas en los modelos de regresin, lineal simple o mltiple,

y no lineal; esto hace que el anlisis de covarianza pueda considerarse una sntesis del anlisis de varianza y el de

regresin.

E El anlisis de covarianza es un anlisis de varianza verificado sobre unas puntuaciones ajustadas mediante una

recta de regresin y que mientras en el ANOVA la variabilidad (o suma de cuadrados) total quedaba descompuesta

en dos componentes aditivos (suma de cuadrados intergrupo o intragrupo), ahora la covariabilidad (o suma de

productos) total va a quedar descompuesta en dos componentes aditivos (suma de productos intergrupo e

intragrupo).

.- MODELO Y SUPUESTOS.

E Se consideran dos modelos diferentes en el anlisis de covarianza:

1. El primero supone la homogeneidad intragrupo de los coeficientes de regresin (anlisis de covarianza).

2. El segundo considera coeficientes de regresin heterogneos.

E Es un modelo aditivo y los supuestos a verificar son los referentes al anlisis de varianza de un factor y una serie

de supuestos adicionales relacionados con el anlisis de regresin lineal simple, incluyendo el supuesto de

homogeneidad de las pendientes de regresin intragrupo.

E Se requiere que la variable dependiente est medida al menos a nivel de intervalo.

.- FUENTES DE COVARIABILIDAD.

E Se descompone la variabilidad total (en este caso covariabilidad o suma de productos) en dos componentes

aditivos:

1. La covariabilidad debida a las diferencias producidas entre los diferentes tratamientos (covariabilidad

intergrupo)

2. La covariabilidad debida a las diferencias producidas dentro del mismo grupo (covariabilidad intragrupo o

error).

.- SUMAS DE CUADRADOS CORREGIDAS.

E Para obtener las sumas de cuadrados ajustadas debemos restar a cada puntuacin Y

ij

la parte que es debida a la

regresin de Y sobre X.

.- ESTADISTICO DE CONTRASTE.

E Para comprobar la hiptesis nula, es decir, que las medias en la variable Y son iguales dentro de cada una de la I

poblaciones sometidas a I tratamientos distintos, tendremos que valernos de las puntuaciones ajustadas mediante la

regresin lineal de Y sobre X, de manera que si entre dichas medias se encontraran diferencias significativas, stas

se podran atribuir al efecto de los tratamientos y no al de la covariante X.

.- COMPARACIONES MULTIPLES.

E Al igual que en el anlisis de varianza, cuando la f obtenida en el ANCOVA es significativa, esto nos indica que

existen diferencias entre los tratamientos pero no nos dice entre cuales.

E Test de Tukey y Test de Schef.

.- COMPROBACION DE SUPUESTOS.

1. Los efectos debidos al tratamiento y debidos a la regresin deben ser aditivos.

2. Los errores asociados con cada uno de los valores de la variable dependiente (

ij

) son independientes entre s,

estn normalmente distribuidos, tienen media 0 y varianzas iguales para los distintos tratamientos.

3. La covariante no debe estar afectada por los efectos de los tratamientos. Este supuesto se cumple siempre que

las medidas en la covariante se tomen antes de la aplicacin de los tratamientos experimentales.

4. Homogeneidad de las pendientes de regresin intragrupo.

5. Linealidad de la regresin de Y sobre X.

.- OBTENCION DE LOS ESTIMADORES DE LOS COEFICIENTES DE LA REGRESION Y

CORRELACIONES ENTRE X E Y.

E El ANCOVA es un ANOVA efectuado sobre una variable (Y) ajustada mediante otra variable (X) y este ajuste

depende del grado de relacin, y por tanto de regresin, de Y sobre X. Esta regresin se puede entender de tres

maneras:

1. Regresin intragrupo o regresin de Y sobre X dentro de cada tratamiento. La magnitud de esta regresin

viene dada por los coeficientes de regresin intragrupo, B

xyi

(habr uno por cada tratamiento).

Es importante que los coeficientes de regresin intragrupo sean iguales, ya que este es uno de los supuestos del

ANCOVA.

2. Regresin intergrupo o regresin de Y sobre X a partir de los I pares de medias. Esta regresin viene

cuantificada por el coeficiente de regresin intragrupo, Binter.

3. Regresin total o regresin de Y sobre X considerando todos los N pares (Y, X) del diseo. Esta regresin viene

dada por el coeficiente de regresin total, Btotal.

ANALISIS DE COVARIANZA (DOS FACTORES) (TEMA 21)

Se trata de analizar el efecto que dos variables independientes (A y B) producen sobre una variable dependiente

(Y) despus de haber controlado el efecto de una variable extraa recogida en la covariante o covariable (X).

.-ESTADISTICOS DE CONTRASTE.

Las T medias

t

del factor A son iguales (A

t

= 0 para todo t).

Las I medias

i

del factor B son iguales (B

i

= 0 para todo i)

El efecto de la interaccin es nulo (Ab

ti

= 0 para toda combinacin ti).

.-COMPARACIONES MULTIPLES.

Al igual que en modelo de ANCOVA con un factor, las comparaciones entre medias se efectan en este modelo a

partir de las medias ajustadas.

Despus de calcular las diferencias entre cada par de medias ajustadas y, para contrastar si dos tratamientos

cualesquiera difieren entre s, podemos aplicar cualquiera de los test de comparaciones mltiples como el test de

Tukey o el de Scheff.

.-COMPROBACIONES DE SUPUESTOS.

Para la correcta aplicacin del ANCOVA se tienen que cumplir todos los supuestos del ANOVA (normalidad,

independencia y homocedasticidad) y adems, unos supuestos propios:

1. La covariante no debe estar afectada por los tratamientos o por la combinacin de tratamientos, la forma de

garantizar su cumplimiento consiste en tomar las medidas de la covariante antes de aplicar los tratamientos

experimentales.

2. Los coeficientes de regresin de Y sobre X (|

ti

) son iguales para todas las TI casillas (Los TI coeficientes de

regresin (|

ti

) intracelda (uno por casilla o combinacin de tratamiento) son iguales.

3. La regresin de Y sobre X es lineal, si el coeficiente de regresin utilizado por el modelo (|) es

significativamente distinto de cero.

You might also like

- INDICE - Manual de Ensayo de Materiales (EM-2000)Document10 pagesINDICE - Manual de Ensayo de Materiales (EM-2000)Hector Yonatan Huallpa CentenoNo ratings yet

- TrabajoDocument2 pagesTrabajoMiranda Carmen Rosa100% (1)

- Corriente en CascadaDocument8 pagesCorriente en CascadaMarko Montalban MonteroNo ratings yet

- Integración TrigonométricaDocument11 pagesIntegración TrigonométricaAgamenon Paris Nuñez CalderonNo ratings yet

- Practica No 2 Levantamiento Con Wincha 2018-0Document3 pagesPractica No 2 Levantamiento Con Wincha 2018-0sergioNo ratings yet

- Control1 2015 - 16 DinámicaDocument4 pagesControl1 2015 - 16 DinámicaJuan GarciaNo ratings yet

- Universidad Pedagógica Y Tecnológica de Colombia Facultad de Ciencias Escuela de Física Práctica No. - Conservación de La Energía Mecánica ObjetivosDocument3 pagesUniversidad Pedagógica Y Tecnológica de Colombia Facultad de Ciencias Escuela de Física Práctica No. - Conservación de La Energía Mecánica ObjetivosLorena VargasNo ratings yet

- Zinc-Tech Galvanic PDFDocument2 pagesZinc-Tech Galvanic PDFFrancisco Javier Gadea LopezNo ratings yet

- Encofrados DeslizantesDocument33 pagesEncofrados DeslizantesDILMER_HTS_92100% (3)

- Programa de Fisica Aplicada - Fis - 100 - Eispdm - PDFDocument4 pagesPrograma de Fisica Aplicada - Fis - 100 - Eispdm - PDFAlfredo LauraNo ratings yet

- Definición de Números ComplejosDocument2 pagesDefinición de Números ComplejosCristianNo ratings yet

- TecsupDocument9 pagesTecsupAnthonyNo ratings yet

- Destilación AzeotrópicaDocument6 pagesDestilación AzeotrópicaElias ArenasNo ratings yet

- ESTD1 N Tarea Preparatoria3Document1 pageESTD1 N Tarea Preparatoria3carlosNo ratings yet

- Factores para La Selección Del Tipo de Bomba ResumenDocument21 pagesFactores para La Selección Del Tipo de Bomba ResumenLuis Angel SaVzNo ratings yet

- Contenido Orden y Script Cosmovision GuaneDocument36 pagesContenido Orden y Script Cosmovision GuaneAndrés LizcanoNo ratings yet

- Taludes Con Plano de Falla CircularDocument10 pagesTaludes Con Plano de Falla CircularCHR1SST1ANNo ratings yet

- Practica 4 QCovDocument9 pagesPractica 4 QCovjrsandraNo ratings yet

- Tipos Ventajas y Desventajas de Antenas en La Comunicación Sin HilosDocument6 pagesTipos Ventajas y Desventajas de Antenas en La Comunicación Sin HilosMiguel Hernandez100% (1)

- Funcion CuadraticaDocument12 pagesFuncion Cuadraticaamparo1998No ratings yet

- Barrenas o Trépano1Document11 pagesBarrenas o Trépano1Joaquin Pablo100% (1)

- SensibilidadDocument5 pagesSensibilidadMiguel Hernandez Carvajal100% (1)

- El AntiEdipo - Gilles DeleuzeDocument653 pagesEl AntiEdipo - Gilles DeleuzeFelipePérezGreene97% (29)

- Ojos de TrilobitesDocument8 pagesOjos de TrilobitesSteve Cerron FerrerNo ratings yet

- Laboratorio n4 Equilibrio en Las SolucionesDocument25 pagesLaboratorio n4 Equilibrio en Las SolucionesAndrea JazminNo ratings yet

- Practica de Tincion de GramDocument9 pagesPractica de Tincion de GramValeriaNo ratings yet

- Proceso de Fabricacion de Los ElectrodosDocument20 pagesProceso de Fabricacion de Los ElectrodosMathew21No ratings yet

- Principio de Funcionamiento de Partes Basicas de Un Sistema HidraulicoDocument20 pagesPrincipio de Funcionamiento de Partes Basicas de Un Sistema HidraulicoClaudio Saavedra0% (1)

- Guia para Armar Cubo Rubik Por El Metodo FridichDocument9 pagesGuia para Armar Cubo Rubik Por El Metodo FridichEsteban Marin100% (1)