Professional Documents

Culture Documents

Un'Introduzione Alla Teoria Quantistica Dei Campi

Uploaded by

vanesppOriginal Title

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Un'Introduzione Alla Teoria Quantistica Dei Campi

Uploaded by

vanesppCopyright:

Available Formats

UnIntroduzione alla Teoria Quantistica dei

Campi

Paolo Guiotto

Contents

1 Introduzione 2

2 Il formalismo della Meccanica Hamiltoniana 2

2.1 Il principio di minima azione . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

2.2 Il usso nello spazio delle fasi . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.3 Formulazione algebrica: parentesi di Poisson . . . . . . . . . . . . . . . . . . . 5

2.4 Teorema di Liouville ed unitariet`a . . . . . . . . . . . . . . . . . . . . . . . . 6

3 La Meccanica Quantistica e la teoria degli operatori 8

3.1 Alcuni fatti sperimentali . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

3.2 Il concetto di stato quantistico . . . . . . . . . . . . . . . . . . . . . . . . . . 10

3.3 Osservabili . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

3.4 Parentesi di Poisson . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

3.5 Il principio dindeterminazione . . . . . . . . . . . . . . . . . . . . . . . . . . 15

3.6 Quantizzazione delle osservabili fondamentali . . . . . . . . . . . . . . . . . . 16

3.6.1 Quantizzazione di Q . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

3.6.2 Quantizzazione di P . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

3.6.3 Quantizzazione di H . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

3.7 Equazione di Schrodinger . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

3.8 LOscillatore Armonico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

3.8.1 Analisi spettrale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

3.8.2 La formula di Mehler . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

3.9 Latomo di idrogeno . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

4 La Formula di Feynman 35

4.1 LIntegrale Funzionale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

4.1.1 Il problema del rigore della formula di Feynman . . . . . . . . . . . . 39

4.2 La Formula di FeynmanKac . . . . . . . . . . . . . . . . . . . . . . . . . . . 40

4.3 La misura di Wiener . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

4.4 Applicazioni della formula di FeynmanKac alla MQ . . . . . . . . . . . . . . 44

4.4.1 La legge di Planck . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

5 Il problema della QFT 45

5.1 Equazione di KleinGordon . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46

5.2 Parentesi di Poisson . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 48

5.3 Rappresentazione di Schrodinger . . . . . . . . . . . . . . . . . . . . . . . . . 50

5.3.1 Spazio degli stati: misure gaussiane in dimensione innita . . . . . . . 50

5.3.2 Regole di commutazione . . . . . . . . . . . . . . . . . . . . . . . . . . 52

5.3.3 Operatori di moltiplicazione e derivazione . . . . . . . . . . . . . . . . 53

1

2

5.3.4 Quantizzazione di H: rinormalizzazione . . . . . . . . . . . . . . . . . 55

1 Introduzione

La teoria quantistica dei campi (nel seguito QFT, dallinglese Quantum Field Theory) si propone

di descrivere la sica dei fenomeni che si svolgono su scala atomica, tenendo conto della teo-

ria geometrica dello spaziotempo introdotta dalla relativit`a generale. In parole povere si tratta

dellunicazione della meccanica quantistica (in seguito QM, Quantum Mechanics) con la meccanica

relativistica. A rigore quindi, per poter comprendere gli scopi e le tecniche della QFT bisognerebbe

conoscere a fondo scopi e tecniche delle due teorie dalla cui unicazione essa nasce. Essendo questa

unintroduzione alla QFT rivolta a studenti del secondo anno, i quali non hanno in genere una

conoscenza preliminare della QM e della relativit`a (ne generale, ne speciale), si dovr`a ricorrere a

diversi compromessi. Di fatto la teoria della relativit`a non verr`a nemmeno toccata.

Lobiettivo principale che ci proponiamo `e quello di presentare un linguaggio matematico che

mostri il pi` u possibile lunitariet`a formale della Meccanica Classica, Meccanica Quantistica e Teoria

Quantistica dei Campi, da un lato, dallaltro ci introduca ad alcuni strumenti matematici creati

appositamente per la descrizione e studio dei problemi connessi. Tali strumenti sono in genere

molto complessi ed uno studio sistematico occupa diversi capitoli dellAnalisi Funzionale, per cui

`e impossibile sia mantenere un livello di generalit`a che di precisione formale. Non essendo questo

per`o lo scopo questa perdit`a sar`a, speriamo, secondaria.

Essendo unambito importantissimo della sica teorica, la bibliograa relativa alla QFT `e molto

consistente ma anche molto tecnica. Infatti, lapparato matematico richiesto `e quello pi` u avanzato

creato dallanalisi funzionale nel corso del ventesimo secolo. Non `e semplice, ne del resto `e questo

lo scopo, tracciare una bibliograa essenziale sullargomento. Alcuni riferimenti, tuttavia, sia per

lessere divenuti pietre miliari che per essere abbordabili agli studenti del secondo anno, possono

essere facilmente dati:

Landau, Meccanica, Editori Riuniti

Arnold, Metodi Matematici della Meccanica Classica, Editori Riuniti

Dirac, I Principi della Meccanica Quantistica, Boringhieri

Von Neumann, Mathematical Foundations of Quantum Mechanics

Feynman, Quantum Mechanics and Path Integral, McGraw Hill

Un libro che ha un taglio da sica teorica sulla QFT `e quello di Itzykson & Zuber, Quantum Field

Theory, Mc GrawHill. Un taglio pi` u matematico lo si trova nel libro di Glimm & Jae, Quantum

Physics, Springer. Un bellissimo libro (o meglio sarebbe collana) `e quello di Reed & Simon, Modern

Methods of Mathematical Physics, Academic Press, specie il vol. 1 Functional Analysis e,

sopratutto, il vol. 2 Fourier Analysis, Self Adjointness, nel quale la teoria del campo libero

(ved. sez. 5) `e presentata rigorosamente. Questi riferimenti, ad ogni modo, sono molto dicili

tecnicamente e non sono certo consigliabili come prima lettura.

Inne, va consigliato il meraviglioso libro di Feynman QED, Adelphi (in italiano) che, con un

linguaggio molto semplice, descrive tutta una serie di fenomeni caratteristici della sica atomica

che hanno spinto a costruire la QM e la QFT.

2 Il formalismo della Meccanica Hamiltoniana

Partiamo dal punto dinizio della sica classica, cio`e dalle equazioni di Newton. Nel seguito con-

sidereremo sempre il caso in cui una sola particella `e presente e questa si muove in uno spazio

sico unidimensionale, di modo da alleggerire le notazioni evitando i vettori (del resto la dierenza

`e di secondaria importanza qui). Lo scopo di questa prima parte `e di introdurre un formalismo

descrittivo della meccanica classica che verr`a ripreso e adattato nella QM e nella QFT.

Come noto, la posizione q(t) al tempo t `e descritta attraverso lequazione di Newton

m q(t) = qV (q(t)),

3

ove V (q) `e lenergia potenziale. Introduciamo ora le equazioni di Hamilton. Posto p = m q, quantit`a

di moto (od in breve momento) lequazione di Newton `e ricondotta ad un sistema di equazioni del

primo ordine:

_

_

_

q =

1

m

p,

p = qV,

(2.1)

ovvero, introducendo lenergia totale

H(q, p) =

1

2m

p

2

+V (q) = en. cinetica + en. potenziale

al sistema

_

q = pH,

p = qH.

(2.2)

I sistemi della forma generale (2.2) prendono il nome di sistemi hamiltoniani e lo studio delle loro

propriet`a analitiche e geometriche ha dato importanti risultati alla meccanica classica.

2.1 Il principio di minima azione

`

E possibile caratterizzare le traiettorie di moto come quelle che minimizzano certi funzionali delle

traiettorie, funzionali che hanno una propria interpretazione sica. Introduciamo la quantit`a

/(q) =

_

t

1

t

0

1

2

q(t)

2

V (q(t))dt,

detta azione. Fissiamo la posizione iniziale q(t0) = q0 e quella nale q(t1) = q1. Il bel teorema che

segue descrive la meccanica classica:

Teorema 2.1 (Principio di minima azione) La traiettoria seguita dal sistema soluzione delle

equazioni (2.1) `e quella che rende stazionaria lazione /.

Dim. Vediamo qual`e la propriet`a caratteristica di una traiettoria q che sia punto stazionario per

lazione. Se q `e una generica traiettoria con la stessa posizione iniziale e nale di q, cio`e q(t0) = q(t0),

q(t1) = q(t1), ed indichiamo con q = q q allora avremo che

/( q +q) /( q) = q/( q)q +o(q).

Un punto stazionario deve essere tale che la variazione di / per una piccola perturbazione della

traiettoria q sia trascurabile rispetto a . Ci`o signica che si deve avere

q/( q) = 0.

Calcoliamo allora la variazione dellazione e verichiamo che questo fatto:

/( q +q) =

_

t

1

t

0

1

2

(

q(t) +

q(t))

2

V ( q(t) +q(t))dt

=

_

t

1

t

0

1

2

(

q(t)

2

+

q(t)

2

+ 2

q(t)

q(t)) V ( q(t)) qV ( q(t))q(t)dt +o(q)

= /( q) +

_

t

1

t

0

q(t)

q(t) qV ( q(t))q(t)dt +o(q)

int. per parti = /( q)

_

t

1

t

0

_

q(t) +qV ( q(t))

_

q(t)dt +o(q).

4

Dunque / = o(q) se e solo se

_

t

1

t

0

q(t) +qV ( q(t))q(t)dt = 0,

per ogni incremento q(t) tale che q(t0) = q(t1) = 0. Da questa arbitrariet`a segue che

q(t) +qV ( q(t)) = 0, t [t0, t1].

Possiamo pertanto porre

q/(q) = q() +qV (q()),

notando che ad ogni q la derivata dellazione associa tutta una funzione. La versione hamiltoniana

del teorema `e altrettanto semplice da provare. A tal ne introduciamo lazione hamiltoniana

S(q, p) :=

_

t

1

t

0

( q(t)p(t) H(q(t), p(t)))dt.

Teorema 2.2 La traiettoria nello spazio delle fasi seguita dal sistema soluzione delle equazioni

(2.2) `e quella che rende stazionaria lazione hamiltoniana S.

Non ci occuperemo oltre dei principi variazionali. Ci ritorneremo solo verso la ne quando la formula

di Feynman e le sue generalizzazioni avranno reintrodotto fondamentalmente lazione.

2.2 Il usso nello spazio delle fasi

Se al sistema (2.2) aggiungiamo le condizioni iniziali q0 e p0, attraverso la soluzione `e denito un

usso nello spazio delle fasi (cio`e lo spazio delle q e delle p)

Tt(q0, p0) = (q(t, q0, p0), p(t, qo, po)).

Qui assumeremo che valgano buone ipotesi per garantire esistenza ed unicit`a globale alle soluzioni

del sistema (2.2) qualunque sia (q0, p0) R

2

. La teoria delle equazioni dierenziali garantisce che

Tt : R

2

R

2

`e un dieomorsmo e che vale la legge di gruppo, cio`e:

Tt+s = Tt Ts = Ts Tt.

Inoltre ovviamente T0 = Id. Queste propriet`a caratterizzano i gruppi ad un parametro di dieomor-

smi. Inoltre, la scrittura (2.2) permette di derivare immediatamente il principio di conservazione

dellenergia:

d

dt

H(q(t), p(t)) = qH q +pH p

per (2.2)

= 0.

Un teorema pi` u profondo `e il

Teorema 2.3 (Liouville)

1

[Tt[ = [[.

Dim. Dal cambiamento di variabili segue che

[Tt[ =

_

Tt

dqdp =

_

[det J(Tt)(q, p)[dqdp = [[,

purche [det J(Tt)(q, p)[ = 1. Questo `e vero per t = 0 (T0 = Id). Basta poi provare che

d

dt

det J(Tt)(q, p) = 0,

1

Se R

2

`e un aperto, [[ sta per la misura di .

5

e questo segue dal calcolo esplicito e dalla forma del sistema (2.2). Infatti: posto che Tt(q, p) =

(q(t, q, p), p(t, q, p)) (q, p) abbiamo che

J(Tt) =

_

qq pq

qp pp

_

, = det(J(Tt)) = qqpp pqqp.

Allora

d

dt

detJ(Tt) = (qqpp pqqp)

= q qpp +qqp p p qqp pqq p.

Derivando le equazioni di Hamilton si ottiene

q q = qpHqq +ppHqp,

p q = qpHpq +ppHpp,

q p = (qqHqq +qpHqp) ,

p p = (qqHpq +qpHpp) ,

e mettendo tutto assieme con un po di pazienza si vede subito che

d

dt

detJ(Tt) = 0.

Da questo segue che detJ(Tt) = detJ(T0) = 1, da cui la conclusione.

2.3 Formulazione algebrica: parentesi di Poisson

Introduciamo ora limportante concetto di osservabile. Matematicamente si tratta di una qualsiasi

(pi` u o meno) funzione sullo spazio delle fasi, cio`e di una f : R

2

R. Se lo stato `e caratterizzato

dalle coordinate (q, p), losservabile f vale f(q, p). Particolari osservabili sono le coordinate stesse,

Q(q, p) = q, P(q, p) = p.

Se f `e un osservabile e consideriamo levoluzione del sistema il valore dellosservabile cambier`a nel

tempo secondo la formula f(q(t), p(t)). Precisamente, se (q0, p0) `e lo stato iniziale, f `e losservabile,

al tempo t il valore dellosservabile sullo stato del sistema `e:

f(q(t, q0, p0), p(t, q0, p0)) =: Ttf(q0, p0).

La scrittura di destra `e la denizione che corrisponde al cosidetto punto di vista di Heisenberg

della meccanica. Signica che invece di pensare la dinamica sulle particelle (equazioni di Hamilton

(2.2)) si pu`o immaginare che il sistema resti fermo e che invece siano le osservabili a muoversi.

Questa dinamica delle osservabili presenta una dierenza fondamentale con quella introdotta dalle

equazioni (2.2): mentre quella `e in genere non lineare questa `e lineare (in parole povere, pi` u semplice);

ovviamente il prezzo da pagare `e che la dinamica delle osservabili `e nello spazio delle osservabili che,

come spazio di funzioni `e uno spazio innito dimensionale. Vediamo allora le equazioni di evoluzione

per le osservabili:

(Ttf)

=

d

dt

f(q(t), p(t)) = (qf) q + (pf) p = (qf)(pH) (pf)(qH) =: |f, Ht = Tt|f, H

(2.3)

dove

|f, g = (qf)(pg) (pf)(qg), (2.4)

si dicono parentesi di Poisson di f e g. Lordine `e eettivamente importante poich`e si vede imme-

diatamente che

|f, g = |g, f. (2.5)

6

Interessante `e il calcolo delle parentesi di Poisson di Q e P:

|Q, P = (qQ)(pP) (pQ)(qP) = 1.

Le parentesi di Poisson (2.4) hanno altre notevoli propriet`a. Anzitutto sono lineari in ciascun

argomento, nel senso che:

|c1f1 +c2f2, g = c1|f1, g +c2|f2, g, |f, c1g1 +c2g2 = c1|f, g1 +c2|f, g2. (2.6)

Poi si comportano come una derivazione

2

, nel senso che vale la regola del prodotto:

|fg, h = |f, hg +f|g, h. (2.7)

Meno evidente `e la cosidetta identit`a di Lie:

|f, |g, h +||f, g, h +||f, h, g = 0. (2.8)

Lequazione (2.3) non si presenta in forma chiusa per la funzione f(t, q, p) := Ttf(q, p) a causa del

secondo membro. Tuttavia `e semplice mostrare che eettivamente pu`o essere scritta come

(Ttf)

= |Ttf, H (2.9)

Infatti:

(Ttf)

= lim

h0

T

t+h

f Ttf

h

= lim

h0

T

h

(Ttf) Ttf

h

= T0 |Ttf, H = |Ttf, H.

Il formalismo appena introdotto permette di descrivere appieno la meccanica classica:

Teorema 2.4 (Rappresentazione di Heisenberg) Sia H una funzione hamiltoniana, |, le

parentesi di Poisson, Q e P le osservabilicoordinate. La meccanica classica `e descritta dalle seguenti

due propriet`a:

i) ogni osservabile ft f(t, q, p) soddisfa lequazione di Heisemberg

ft = |ft, H,

ii) |Q, P = 1.

Lo spazio delle osservabili con le parentesi di Poisson di chiama algebra di Lie.

La precedente formulazione `e naturale ed importante. Infatti la meccanica quantistica verr`a in-

trodotta sullo stesso schema formale (ci`o che cambier`a radicalmente sar`a lalgebra di Lie delle

osservabili, cambiamento obbligato dai risultati sperimentali).

2.4 Teorema di Liouville ed unitariet`a

Per apprezzare bene il formalismo di Heisenberg vediamo come da esso sia possibile ritrovare il

teorema di Liouville 2.3, in termini di propriet`a algebricogeometriche che derivano dal teorema

2.4. A tal proposito andiamo a studiare meglio loperatore /Hf := |f, H. /H `e unoperatore

lineare e lequazione di Heisenberg diventa

ft = /Hft,

dove

rappresenta la derivata rispetto a t. Ora, per analogia con le equazioni dierenziali ordinarie,

potremmo scrivere

ft = e

t1

H

f0.

La notazione e

t1

H

`e per ora puramente ttizia ma suggestiva, e sta semplicemente per loperatore

Tt introdotto nella sezione precedente. Siccome parliamo di operatori `e bene dire qualcosa su cosa

operano, cio`e sulle famose osservabili.

`

E conveniente pensare lo spazio innito dimensionale delle

2

Niente di strano del resto: f, g `e denita nella (2.4) attraverso derivate!

7

osservabili come una struttura di spazio vettoriale munito di unapposita topologia. Uno degli spazi

migliori (perche ricco di struttura) `e lo spazio

H := L

2

(R

2

) =

_

f : R

2

C :

_

R

2

[f(q, p)[

2

dqdp < +

_

.

La ricchezza di tale spazio `e non solo nella struttura vettoriale, ma anche nel fatto che H `e munito

di un prodotto scalare hermitiano:

(f, g)

H

:=

_

R

2

f(q, p)g(q, p) dqdp

_

R

2

fg dqdp.

In questo caso

_

R

2

[f[

2

dqdp = (f, f)

2

H

`e una norma come si verica facilmente e lo spazio H `e

topologicamente completo (e prende il nome di spazio di Hilbert). Osserviamo che tale scelta di H ci

fa subito escludere le nostre osservabili importanti Q, P, H, ma questo `e un problema cui bisogner`a

abituarsi e che emerger`a in tutta la sua complessit`a con la meccanica quantistica.

Chiaramente e

t1

H

f = Ttf `e denita per ogni tipo di osservabile, quindi anche per una f H.

Meno evidente `e che stia ancora in H. Assai meno evidente `e che la dinamica non ne muti la

lunghezza in H. Questo `e di fatto il teorema di Liouville:

Teorema 2.5

Teorema di Liouville e

t1

H

`e unitario su H, t R.

Unitario signica che

_

_

e

t1

H

f

_

_

H

= |f|

H

, f H, t R.

Dim. Infatti basta osservare che

[[ =

_

1 dqdp =

_

R

2

[[

2

dqdp = ||

2

H

,

e

[Tt[ =

_

Tt

1 dqdp =

_

R

2

[Tt[

2

dqdp

=

_

R

2

[ Tt[

2

dqdp =

_

R

2

e

t1

H

2

dqdp

=

_

_

e

t1

H

_

_

2

H

.

Dunque se e

t1

H

`e unitario su H per ogni t R chiaramente vale Liouville. Viceversa, se vale

Liouville abbiamo che e

t1

H

`e unitario sulle funzioni caratteristiche. Basta allora procedere per

approssimazione attraverso funzioni semplici

c

k

k

,

k

disgiunti e si prova rapidamente il caso

generale.

`

E importante slegare lunitariet`a dalla dinamica per poter estendere il teorema di Liouville ad altri

ambiti. Proviamo a vedere se c`e una propriet`a caratteristica intrinseca che si lega allunitariet`a.

Se e

t1

H

fosse un numero complesso, lunitariet`a signicherebbe che e

t1

H

= e

i

dove R,

ovvero che /H `e, in qualche senso, un immaginario puro. Se /H fosse un vero e proprio numero

complesso, il fatto che sia immaginario puro sarebbe espresso dallidentit`a:

/H = /H.

Ma cos`e il coniugato di /H? Attraverso il prodotto hermitiano `e possibile darne una caratteriz-

zazione:

(/Hf, g)

H

= (f, /Hg)

H

= (f, /Hg)

H

.

8

Prima di proseguire diciamo qualche parola su /H. Perche se e

t1

H

, conoscendo la dinamica, non ha

grossi problemi di denizione, /H ne ha.

`

E infatti unoperatore dierenziale quindi `e richiesta una

restrizione sulle osservabili per poter parlare di /Hf. Verrebbe naturale considerare, per esempio,

come dominio di /H le osservabili f C

1

(R

2

)H. Ci`o `e insuciente per`o perche in genere /Hf non

apparterr`a ad H. Per stare tranquilli facciamo una restrizione pesante e prendiamo in considerazione

solo osservabili che siano C

(R

2

) a supporto compatto: scriveremo C

c

per indicare tale spazio.

`

E

adesso possibile mostrare il

Lemma 2.6 /H `e antisimmetrico, ovvero

(/Hf, g)

H

= (f, /Hg)

H

, f, g C

c

.

Dim. Si tratta della formula dintegrazione per parti:

(/Hf, g)

H

=

_

R

(/Hf) g dqdp

=

_

R

(qf)(pH) g dqdp

_

R

(pf)(qH) g dqdp

=

_

R

fq (pH g) dqdp +

_

R

fp (qH g) dqdp

=

_

R

f (qpH g +pHq g) dqdp +

_

R

f (pqH g +qHp g) dqdp

=

_

R

f(pHqg qHpg)dqdp.

= (f, /Hg)

H

.

Lunitariet`a segue direttamente dallantisimmetria in modo formale (indipendente cio`e dalla speci-

ca forma di /H):

Corollario 2.7 Se /H `e antisimmetrico allora e

t1

H

`e unitario su H.

Dim. Poniamo ut := e

t1

H

f, formiamo la quantit`a |ut|

2

H

e deriviamo rispetto a t tenendo conto

che

ut = /Hut.

Dunque

d

dt

|ut|

2

H

=

d

dt

(ut, ut)

H

= (ut, ut)

H

+ ( ut, ut)

H

= (ut, /Hut)

H

+ (/Hut, ut)

H

= 0.

3 La Meccanica Quantistica e la teoria degli operatori

La meccanica quantistica `e nata dalla necessit`a di una nuova teoria per lo studio dei misterio-

si fenomeni

3

che si vericano su scala atomica. Di fatto lapparato matematico coinvolto nella

3

Rispetto alle concezioni classiche.

9

costruzione della teoria comprende fondamentali capitoli della matematica del ventesimo secolo,

capitoli nati proprio per fornire una solida base alle paradossali regole della teoria sica. Queste

teorie sono la teoria spettrale di operatori, la teoria delle algebre di Banach, la teoria della misura

su spazi di dimensione innita. Il successo spettacolare qualitativo e quantitativo di queste tecniche

nella spiegazione dei nuovi fenomeni ha dichiarato indiscussamente la correttezza della QM. Per

cominciare allora andiamo brevemente a riprodurre lesperimento virtuale cos` come Feynman lo

riporta nel suo libro Quantum Mechanics and Path Integral (`e consigliabile anche il libretto

QED di Feynman).

3.1 Alcuni fatti sperimentali

Lesperimento virtuale

4

che ora descriveremo metter`a in luce le caratteristiche misteriose della

sica atomica. Una sorgente di elettroni emette elettroni indistintamente in tutte le direzioni del

piano (immaginiamo per semplicit`a una dinamica unidimensionale, cio`e in una sola dimensione

spaziale). Ad una certa distanza c`e una paratia con due fori attraverso i quali gli elettroni possono

passare per andare poi a sbattere contro uno schermo. Lo schermo `e munito di rilevatori sensibili a

sucienza da segnalare larrivo del signolo elettrone sullo schermo.

Supponiamo di far emettere alla sorgente un gran numero di elettroni in ciascuno dei tre seguenti

casi: a) il solo foro A `e aperto; b) il solo foro B `e aperto; c) tutti e due i fori sono aperti. La prima

sorpresa si coglie gi`a con gli esperimenti a) e b) poich`e quello che vediamo `e che, a fronte di un

gran numero di prove gli elettroni sembrano distribuirsi casualmente sullo schermo, con un picco

pi` u o meno smorzato, allaltezza del foro corrispondente.

Quando i due fori sono aperti contemporaneamente succede qualcosa di nuovo. Non si ha una

semplice sovrapposizione dei due casi in cui uno solo dei fori `e aperto: la frequenza di arrivare sullo

schermo passando per uno dei due fori non `e la somma delle frequenze di passaggio attraverso uno

dei due fori. In parole povere la frequenza non soddisfa le leggi ordinarie del calcolo delle probabilit`a.

Diverse e complicate spiegazioni sono state date di questo fenomeno. Latteggiamento pragmatico

di prendere atto della situazione e cercare di trovare le nuove regole di calcolo `e quello che ha

prodotto i migliori frutti, giacch`e `e chiaro che le regole della meccanica newtoniana non saranno

pi` u sucienti.

Prima di cedere al pragmatismo possiamo eettuare la seguente variante dellesperimento virtuale.

Subito dietro la paratia, in prossimit`a di uno dei due fori, quello A ad esempio, mettiamo un

rilevatore di particelle di modo tale che esso scatti quando una particella attraversa il foro A. Lo

scopo `e quello di contare esattamente quante particelle passano per A (e di conseguenza quante

passano per B). Se questo apparecchio di rilevazione non inuenzasse il sistema ci aspetteremmo,

dopo lemissione di un gran numero di elettroni, la situazione misteriosa di cui abbiamo appena

detto. Ed invece, non senza stupore, ecco che ci`o che si verica sullo schermo nale `e proprio lesito

che ci aspetteremmo secondo le leggi classiche del calcolo delle probabilit`a!

Spiegare questo ulteriore mistero `e stato un gran rompicapo per diverso tempo, ntanto che

Heisenberg formul`o lipotesi che lapparecchio dovesse inuenzare lesito dellesperimento. Infatti,

egli disse, per constatare il passaggio di unelettrone dobbiamo in qualche modo toccarlo, e ci`o `e

possibile solo attraverso un urto con unaltra particella di massa pi` u o meno simile (o pi` u grande),

che nellurto nir`a con linuenzare il moto dellelettrone.

`

E un po come se lelettrone `e un passante

che vuole attraversare la strada e lunico modo di sapere se sta attraversando `e quello di andargli

addosso con unautotreno!

Linuenza dellosservazione sullo stato del sistema ha unulteriore conseguenza logica (sperimen-

talmente vericata): in genere, se si compiono due osservazioni successive, lordine nel quale queste

avvengono avr`a molta importanza e non `e aatto detto che eettuare una prima misurazione di

una certa quantit`a e poi, successivamente, osservarne una seconda produca lo stesso eetto che

invertendo lordine delle osservazioni.

4

Virtuale perch`e non concretamente realizzabile negli stessi termini che qui verranno esposti, ma

sostanzialmente realizzabile.

10

3.2 Il concetto di stato quantistico

Assumiamo allora latteggiamento pragmatico.

`

E anzitutto chiaro che il concetto di stato dovr`a

subire un radicale cambiamento. In eetti laspetto aleatorio legato allimprevedibilit`a di dove si

possa trovare una particella costituisce una novit`a fondamentale in contrasto col determinismo delle

equazioni dierenziali di Newton. Precisamente non sar`a pi` u possibile individuare una posizione

precisa ma solamente la probabilit`a che la particella si trovi in una certa posizione. Una prima idea

potrebbe essere quella di identicare lo stato con una distribuzione di probabilit`a, cio`e con una

funzione : R [0, +[, tale che

_

+

(x) dx = 1. (3.1)

Dunque non avr`a senso, in genere, calcolare la probabilit`a che la particella si trovi in un determinato

punto x quanto, invece,

P(particella [a, b]) =

_

b

a

(x) dx.

Tuttavia tale posizione non `e suciente. Infatti il problema `e adesso: negli esperimenti descritti

nella sezione precedente, nei tre casi a), b), c) dovremmo avere tre distribuzioni di probabilit`a 1,

2 e 3 che descrivono la probabilit`a nale di trovare una particella sullo schermo; come si legano

tra loro le tre distribuzioni? Se valessero le regole del calcolo delle probabilit`a ordinario, allora, per

la decomposizione delle probabilit`a totali,

P(particella [a, b]) = P(particella [a, b] [ passa per porta 1) P(passa per porta 1)

+ P(particella [a, b] [ passa per porta 2) P(passa per porta 2)

Ora: se le due porte sono identiche e sono simmetriche rispetto alla posizione in linea della sorgente

di elettroni, possiamo ammettere che P(passa per porta 1) = P(passa per porta 2) =

1

2

. Invece

P(particella [a, b] [ passa per porta 1) la possiamo calcolare tenendo conto che quando mettiamo

un rilevatore dopo una porta le di stribuzioni di probabilit`a nali coincidono con quelle di un solo

foro aperto. In altre parole

P(particella [a, b] [ passa per porta 1) =

_

b

a

1(x) dx,

P(particella [a, b] [ passa per porta 2) =

_

b

a

2(x) dx,

da cui, tenendo tutti e due i fori aperti, ammettendo la regola delle probabilit`a totali e le considerate

le osservazioni sperimentali, abbiamo che

P(particella [a, b]) =

1

2

_

b

a

1(x) dx +

1

2

_

b

a

2(x) dx =

_

b

a

1

2

(1(x) +2(x)) dx.

Conclusione: 3 =

1

2

(1 +2). Ebbene questa `e falsa in virt` u dellaspetto della terza distribuzione!

Ma allora, qual`e la misteriosa alchimia che permette di calcolare 3 in funzione 1 e 2?

Fortunatamente la situazione non era del tutto sconosciuta nella sica. Infatti ricordava la cosidetta

interferenza fra onde, che si ottiene quando si immagina che una perturbazione donda abbia origine

nel punto di emissione degli elettroni. Prendendo spunto da questa analogia dotiamo 1 e 2 anche

di una fase, ovvero pensiamo 1, 2 come funzioni complesse di variabile reale. Questo semplica

la struttura della prima regola, che ci permette di esprimere lo stato 3 come semplice combinazione

degli stati 1 e 2:

Assioma 3.1 (Principio di sovrapposizione)

3 = 1 +2.

11

Attraverso il principio di sovrapposizione possiamo guardare allo spazio degli stati come ad una

struttura di uno spazio vettoriale di funzioni da R in C. Naturalmente sar`a opportuno fare una

specica pi` u precisa su tale spazio e scegliere da un lato uno spazio con una struttura conveniente

da un punto di vista algebricotopologico; dallaltro bisogna anche trovare il modo di estrarre il

senso probabilistico dalla conoscenza dello stato . Tali vincoli trovano unecace risposta nella

seguente scelta:

Assioma 3.2 (Spazio degli stati) Lo spazio degli stati `e

X :=

_

: R C :

_

+

[(x)[

2

dx <

_

=: L

2

(R).

Tale spazio si assume munito della struttura di prodotto scalare hermitiano (, )

X

:=

_

R

f g dx.

Con tale posizione ||

2

X

= (, )

X

.

Chiaramente adesso X, in genere, non rappresenta pi` u una distribuzione di probabilit`a. La

strada per recuperare tale signicato probabilistico `e quella di denire, per un dato stato X

P(particella [a, b]) =

_

b

a

[(x)[

2

dx.

Ovviamente tale posizione ha un senso probabilistico solo quando

_

R

[(x)[

2

dx = 1, ovvero ||

X

=

1.

Denizione 3.3 Uno stato X tale che ||

X

= 1 si dice unitario.

Osserviamo che per ogni stato ,= 0 si ha che := ||

1

X

`e unitario. Per cui, se poniamo, in un

dato stato X

P(particella [a, b]) =

_

b

a

[(x)[

2

dx =

1

||

2

X

_

b

a

[(x)[

2

dx,

abbiamo una denizione valida per ogni stato ,= 0. Non solo: da questa denizione vediamo che,

ai ni di calcolo statistico, le probabilit`a sono invarianti sulle rette | : C.

3.3 Osservabili

Una volta introdotto il concetto di stato ed il principio di sovrapposizione che ci permette di

operare sugli stati, dobbiamo introdurre il secondo concetto fondamentale, quello di osservabile.

Come sempre unosservabile sar`a una funzione dello stato. Il principio di sovrapposizione e quanto

detto nella sezione 3.2 impongono che sia un operatore lineare. Vediamo come.

Sia F unosservabile e uno stato; F() sar`a la realizzazione di F in . Abbiamo detto, nel

paragrafo 3.2, che compiere unosservazione su un sistema in un certo stato corrisponde a cambiarne

lo stato in uno nuovo. In altre parole F : X X. Lidea che impone la restrizione agli operatori

lineari si basa sul principio che le relazioni siche siano conservate dalle osservabili. Per esempio:

se uno stato `e sovrapposizione di altri due, cio`e = 1 + 2 allora `e naturale che, se F `e

unosservabile, il trasformato di attraverso losservazione F sia la sovrapposizione dei trasformati

F(1) ed F(2)

5

. Cio`e F() = F(1)+F(2). Allo stesso modo lo stato e c, dove c `e un numero

complesso, rappresentano lo stesso stato; pertanto `e naturale che F conservi questa relazione, cio`e

F(c) e F() siano lo stesso stato a meno di una costante moltplicativa c. Per analogia con lalgebra

lineare `e uso denotare lazione di unosservabile F su uno stato col simbolo F, a ricordare che

si tratta di un operatore lineare.

Assioma 3.4 (Osservabili) Si chiama osservabile ogni operatore lineare F : D(F) X X.

5

N.B. : questa `e unipotesi ben precisa che trova conferme sperimentali nelle osservabili pi` u comuni.

12

Notiamo che il concetto di osservabile appena introdotto risponde bene anche al fatto che, in genere,

due osservabili F e G non commutino tra loro, cio`e FG in genere `e diverso da GF. Questo fatto

`e vero non appena si prendono due operatori lineari su uno spazio vettoriale (si pensi ad esempio

al caso delle matrici in R

2

) e costituisce un principio di consistenza con ci`o che stiamo andando a

costruire.

Ora che possediamo il concetto di spazio degli stati e di osservabile possiamo considerare una situ-

azione di grandissima importanza, `e cio`e linterpretazione dei concetti di autovalore ed autovettore.

Supponiamo che F sia unosservabile e che sia uno stato tale che

F = .

Ricordiamo che e rappresentano lo stesso stato, visto che lunica cosa che ci serve degli stati

`e la probabilit`a di trovare la particella da qualche parte, operazione che si eettua come descritto

nel paragrafo precedente (normalizzando cio`e, e quindi dimenticandosi della lunghezza eettiva del

vettore ). Un autostato per losservabile F `e dunque uno stato su cui losservabile non inuisce

poich`e riproduce lo stato stesso, a meno di un fattore intensivo. Possiamo interpretare questo

fattore come il valore eettivo dellosservabile

6

. Il valore pu`o essere ottenuto attraverso la formula

(, ) = (, ) = (F, ),

ovvero

=

(F, )

(, )

.

Nel caso di unosservabile generica F e di uno stato che non sia autostato di F abbiamo la

Denizione 3.5 Si dice valore medio di unosservabile F nello stato il numero

F) :=

(F, )

(, )

, D(F).

Osserviamo che se `e unitario allora F) = (F, ).

Si pone ora per`o un altro problema. In genere, per come `e denito, F) non `e detto che sia un

numero reale. Dipende dal fatto che (F, ) lo sia. Daltra parte le sole misurazioni che sicamente

hanno senso sono reali. Si potrebbe pensare di ottenere una misurazione complessa con due mis-

urazioni successive, di due quantit`a reali. Tuttavia, come abbiamo detto, una misura sul sistema

cambia lo stato delle cose ed inuir`a sullesito della seconda misurazione. Daltro canto lordine `e

fondamentale, quindi non si riesce a dare un senso ad una misurazione complessa. Vediamo anzitutto

cosa caratterizza lessere reale dei valori medi:

Lemma 3.6 F) R per ogni stato X se e solo se

(F, ) = (, F), , D(F).

In altre parole: se e solo se F `e simmetrico.

Dim. Che se F `e simmetrico allora i suoi valori medi sono reali `e una semplice verica: se

D(F) `e unitario allora

F) = (F, ) = (, F) = (F, ) = F).

Viceversa: sia D(F) unitario. La stessa relazione scritta sopra (assumendo che F) = F))

porta a

(F, ) = (F, ) = (, F),

6

Si potrebbe argomentare come segue. Losservabile F valutata su restituisce restituisce interamente

, ovverosia con certezza. Vedremo nella sezione 3.7 in che senso sintende con certezza.

13

per ogni D(F). Al caso generale si passa con tecniche standard di spazi di Hilbert (cio`e

sostituendo con + e svolgendo i conti). Vediamo:

(F( +), +) = ( +, F( +)),

(F, ) + (F, ) + (F, ) + (F, ) = (, F) + (, F) + (, F) + (, F),

(F, ) + (F, ) = (, F) + (, F),

(F, ) (, F) = (, F) (F, ),

Ora: rimpiazziamo con i. Facendo i conti otteniamo

(F, i) (, iF) = (i, F) (iF, ),

i(F, ) +i(, F) = i(, F) i(F, ),

(F, ) (, F) = ((, F) (F, )) = ((F, ) (, F))

da cui, inne, (F, ) (, F) = 0.

Dunque gli operatori simmetrici rivestono un ruolo importante nella teoria, essendo corrispondenti

alle osservabili reali. Per unoperatore qualunque possiamo denire lanalogo del complesso coniugato

che verr`a chiamato aggiunto: se F `e loperatore, laggiunto di F, indicato con F

, sar`a loperatore

soddisfacente lequazione

(F, ) = (, F

).

`

E facile provare, ad esempio, che (FG)

= G

e lordine `e importante. Questo fra laltro mette

in luce che non `e detto che il prodotto di due osservabili reali sia ancora unosservabile reale: questo

accade se e solo se F e G commutano.

3.4 Parentesi di Poisson

Seguendo la reppresentazione di Heisenberg dobbiamo ora introdurre le parentesi di Poisson. Infatti,

al momento, non disponiamo delle equazioni di Newton per conoscere levoluzione degli stati. Il

programma consiste allora nellintrodurre le nuove parentesi di Poisson quindi, attraverso lequazione

di Heisenberg, levoluzione delle osservabili ed inne dedurre levoluzione degli stati. Loperazione

di costruzione delle parentesi di Poisson quantistiche viene chiamata quantizzazione.

Indicheremo con [, ] le nuove parentesi quantistiche. Imponiamo che soddisno le propriet`a (2.5),

(2.6), (2.7) e (2.8). Bisogna fare in realt`a un po dattenzione con la (2.7). In eetti per le parentesi

di Poisson classiche `e pur vero che tutti gli oggetti sono funzioni ed il prodotto `e denito come

prodotto punto per punto, per cui `e commutativo. In altre parole le quattro espressioni

|f, hg +f|g, h, g|f, h +f|g, h, g|f, h +|g, hf, |f, hg +|g, hf,

sono identiche. Se ora le osservabili sono operatori e le parentesi di Poisson di due osservabili `e ancora

unosservabile in generale ci sar`a da aspettarsi che le quattro espressioni di cui sopra, nel contesto

quantistico, siano tutte diverse. Come denire allora le parentesi? Bisogna ssare una convenzione

una volta per tutte. Tale convenzione `e la cosidetta convenzione dellordine, che corrisponde alla

scelta della (2.7):

Assioma 3.7 (Parentesi quantistiche) Le parentesi [, ] soddisfano le seguenti condizioni:

i) (linearit`a) : [c1F1 +c2F2, G] = c1[F1, G] +c2[F2, G];

ii) (antisimmetria) : [F, G] = [G, F];

iii) (derivazione) : [FG, H] = [F, H]G+F[G, H];

iv) (identit`a di Lie) : [F, [G, H]] + [[F, G], H] + [[F, H], G] = 0;

14

v) (chiusura) : se F e G sono osservabili reali allora anche [F, G] lo `e.

Ci`o detto riusciamo a determinare la forma esplicita delle parentesi:

Teorema 3.8 (Dirac) Esiste una costante universale h R tale che

ih[F, G] = (FGGF).

La costante h si chiama costante di Planck.

Dim. Scriviamo la formula del prodotto [A, BC] applicando la ii) e la iii). Risulta:

[A, BC] = [BC, A] = ([B, A]C +B[C, A]) = [A, B]C +B[A, C]. (3.2)

Calcoliamo ora il prodotto [AB, CD] usando le due formule per il prodotto in cascata prima in un

ordine e poi in quello inverso.

[AB, CD] = [A, CD]B +A[B, CD]

= ([A, C]D +C[A, D]) B +A([B, C]D +C[B, D])

= [A, C]DB +AC[B, D] + C[A, D]B +A[B, C]D.

(3.3)

Allo stesso modo ma usando prima la regola (3.2) si perviene a

[AB, CD] = [A, C]BD +CA[B, D] + A[B, C]D +C[A, D]B.

Eguagliando con la (3.3) e cancellando le parti comuni si arriva a

[A, C](BD DB) = (AC CA)[B, D],

ovvero

(7)

(AC CA)

1

[A, C] = [B, D](BD DB)

1

.

Questo per ogni quaterna di operatori A, B, C, D. Poich`e il primo membro non dipende da B, D ed

il secondo da A, C segue che devono essere costanti, nel senso che devono essere loperatore kI

per un opportuno k C indipendente da A, B, C, D, ovvero

[F, G] = k(FGGF).

Vediamo ora che k `e immaginario puro. Se F e G sono osservabili reali la condizione che [F, G] lo

sia si legge come:

[F, G]

= [F, G]. (3.4)

Del resto

[F, G]

=

k(FGGF)

=

k(G

) =

k(GF FG) =

k(FGGF) =

k

k

[F, G].

Per cui la (3.4) pu`o essere vera solo se

k =

k,

ovvero k `e immaginario puro.

Le parentesi

ih[F, G] = (FGGF),

soddisfano lassioma 3.7 e dunque saranno il nostro punto di partenza per la costruzione delle

equazioni di evoluzione, oltre alla caretterizzazione delle funzioni Q e P (posizione ed impulso) che

dovranno soddisfare la relazione

[Q, P] = I. (3.5)

7

Sebbene un po sportivamente. . .

15

Vedremo tra poco come sia possibile costruire le versioni quantistiche delle funzioni Q, P che

soddisno la (3.5) e la versione quantistica dellhamiltoniana H. Notiamo ora il seguente particolare:

lequazione di commutazione (3.5) pu`o essere esplicitamente riscritta come

QP PQ = ihI.

In meccanica classica `e ben noto che le coordinate canoniche Q e P commutano. Ci`o corrisponde al

valore h = 0. In eetti la costante h `e molto piccola una volta rapportata alle situazioni concrete.

Possiamo in questo modo intravedere lo spiraglio che permette di riottenere la meccanica classica

da quella quantistica come caso limite quando la costante h tende a 0.

3.5 Il principio dindeterminazione

Mostriamo la potenza del linguaggio introdotto recuperando una delle pi` u sorprendenti conclusioni

della teoria: il principio dindeterminazione di Heisenberg.

A tal ne introduciamo un concetto nuovo. Abbiamo detto che se F `e unosservabile allora il

suo valore medio nello stato `e dato dal numero F) = (F, ) (se `e unitario).

`

E importante

introdurre una quantit`a che misuri lo scostamento dal valore medio:

Denizione 3.9 (Varianza) Se F `e unosservabile si pone

Var(F, ) := (F F)I)

2

) = ((F F)I)

2

, )

Due importanti fatti sono i seguenti:

i) Se F `e unosservabile reale allora

Var(F, ) = ((F F)I)

2

, ) = ((F F)I), (F F)I)) = |(F F)I)|

2

.

ii) Se `e un autostato per losservabile F, cio`e F = , allora F) = , per cui

Var(F, ) =

(F F)I)

2

_

= ((F I)(F I), ) = 0,

ovvero Var(F, ) = 0.

Questo evidentemente corrisponde allinterpretazione che abbiamo dato agli autostati e cio`e che su

di essi la misura della grandezza di cui sono autostati `e determinata con certezza. Questa perfetta

descrizione mostra come le nuove regole di calcolo che stiamo introducendo siano coerenti con

linterpretazione cui esse corrispondono; questo `e un punto fondamentale in tutta la sica teorica.

Consideriamo ora la relazione

QP PQ = ihI,

ammettendo di aver costruito Q e P come osservabili reali. Poniamo

Q :=

_

Var(Q, ) = |(QQ)I)|,

ed una simile denizione per P.

Teorema 3.10 (Principio dindeterminazione di Heisenberg)

QP

h

2

.

Osservazione 3.11 Detta in parole povere: il prodotto fra gli errori che si possono commettere

misurando Q e P simultaneamente `e limitato inferiormente. Nella notazione di Heisenberg qp

h

2

, per cui se uno degli errori `e piccolo laltro deve essere grosso.

16

Dim. Osserviamo che dallidentit`a

QP PQ = ih,

segue immediatamente la stessa con Q e P centrate rispetto al valore medio:

(QQ)I)(P P)I) (P P)I)(QQ)I) = ihI.

Per alleggerire la notazione indichiamo con Q := Q Q)I ed unanaloga denizione per P.

Dunque lequazione precedente si riscrive come

(Q)(P) (P)(Q) = ihI.

Ma allora, preso D(Q) D(P) unitario abbiamo

ih = i(, )

= ((QP PQ) , )

= (QP, ) (PQ, )

= (P, Q) (Q, P) Q, P simmetrici perche reali

= (P, Q) (P, Q)

= i2Im(P, Q) ,

da cui

h

2

[(P, Q)[

|P||Q| per CauchySchwarz

= QP.

3.6 Quantizzazione delle osservabili fondamentali

Fin qui abbiamo introdotto lo spazio degli stati e come sono fatte le osservabili. Tenendo conto

di ci`o abbiamo derivato la forma delle parentesi di Poisson compatibili con tali impostazioni.

Nellintrodurre i vari concetti abbiamo anche visto come siano coerenti con alcune interpretazioni

siche: dal concetto di valore medio, autovalore, no al principio dindeterminazione di Heisenberg.

Questultimo caso mette in gran risalto le osservabili Q e P, dalla cui propriet`a formale [Q, P] = I

abbiamo dedotto il principio dindeterminazione.

Ma come sono deniti esplicitamente Q e P?

`

E giunto il momento di scendere un po pi` u nel

concreto e di denire compiutamente tali osservabili.

`

E un passaggio fondamentale perche la quan-

tizzazione di Q e P permetter`a di denire anche la quantizzazione dellhamiltoniana H (che,

ricordiamo, sicamente rappresenta lenergia).

3.6.1 Quantizzazione di Q

Questa `e loperazione pi` u semplice. Dobbiamo denire Q : D(Q) X X. Ricordiamoci anzitutto

che gli elementi di X sono distribuzioni di probabilit`a (una volta normalizzate) che ci danno in-

formazione sulla localizzazione della particella. In ambito classico la particella `e individuata da un

numero q che ne determina la posizione nello spazio. Non `e dicile costruire una distribuzione di

probabilit`a che traduca ci`o: lo stato dovr`a essere tale che

_

b

a

[(x)[

2

dx =

_

0 se q / [a, b]

1 se q [a, b].

17

Tale stato `e rappresentato dalla celebre delta di Dirac q(x), nel senso che (x) = q(x). Ora una

simile funzione, com`e noto, non esiste come funzione ordinaria, bens` come funzione generalizzata.

Procediamo formalmente, come se q X. Allora chiaramente

(Qq)(x) =

_

q se x = q

0 se x ,= q

_

= qq(x) = xq(x).

Il primo e lultimo membro delleguaglianza precedente si leggono, estesi ad ogni stato, come

[Q](x) = x(x), x R. (3.6)

Assumiamo quasta come denizione di Q.

`

E da notare che anch`e Q X bisogna che

_

R

[Q(x)[

2

dx =

_

R

x

2

[(x)[

2

dx.

Lesistenza di questo integrale in genere non `e garantita dal fatto che X com`e facile vedere.

Questo signica che Q non sar`a denito su tutto X, ma avr`a un dominio:

D(Q) :=

_

X :

_

R

x

2

[(x)[

2

dx <

_

.

Questo fatto si porta appresso una complicazione non da poco, cio`e che come trasformazione da X

in X, Q non `e continuo (esercizio). Non ci occuperemo di questo aspetto se non per commentare in

seguito, dopo lintroduzione anche di P, che lequazione [Q, P] = I gi`a contiene questo spiacevole

imprevisto.

Notiamo, per concludere, che Q `e unosservabile reale:

(Q, ) =

_

R

x(x)(x)dx =

_

R

(x)x(x)dx = (, Q).

3.6.2 Quantizzazione di P

Cerchiamo di costruire P in modo tale che valga lidentit`a fondamentale

QP PQ = ihI.

Avendo gi`a costruito Q ci si pu`o attendere che la precedente sia una sorta di equazione per P.

Vediamo pi` u concretamente lequazione, applicandola allo stato generico :

QP PQ = ih.

Ora Q(x) = x(x). Possiamo riscrivere lidentit`a precedente come

8

P(x(x)) = x[P](x) ih.

Ora unidentit`a come quella appena scritta ricorda le propriet`a di derivata di un prodotto, dove P

`e loperazione di derivazione. In altre parole: poniamo

[P](x) := ih

(x). (3.7)

`

E ora immediato vericare che con questa posizione lidentit`a fondamentale di commutazione `e

soddisfatta.

Abbiamo dedotto una denizione di P di modo tale che lidentit`a fondamentale fosse soddisfatta.

Tutto ci`o potrebbe sembrare un po astratto. Tuttavia P sta al momento della particella come Q

sta alla posizione. In eetti se q(t) `e la posizione della particella,

q(t)

`e lo stato corrispondente.

8

Ad essere rigorosi andrebbe riscritta come

[P( ()] (x) = x[P](x) ih(x),

ma chiaramente cos` la notazione sarebbe molto pi` u pesante.

18

Supponiamo che t t0. Allora q(t) q(t0) +p(t t0), ove p = q(t0). Pertanto

q(t)

q(t

0

)+p(tt

0

)

.

In altre parole un momento p fa traslare la funzione donda. Sostituendo la con la generica

avremo un usso di stati

M

(x) = (x +)

La generalizzazione della formula q(t) q(0) +tp `e data dalla formula di Taylor:

M

(x) (x) +

(x).

Possiamo allora, per analogia con il caso classico, pensare che

(x) sia, a meno di costanti, il

momento generalizzato di . La costante va scelta di modo che la regola di commutazione con Q

valga oppure imponendo che P sia osservabile reale.

Osserviamo, come gi`a per Q, che P non sar`a denito su tutto X, ma avr`a un dominio

D(P) =

_

X :

,

_

R

[

(x)[

2

dx <

_

.

Tale dominio `e pi` u dicile da identicare del dominio di Q. Infatti non `e chiaro quali condizioni su

X determinino lesistenza (ed in che senso) di

. Per esempio C

c

`e sicuramente in D(P),

ovvero C

c

D(P). Su tale parte del dominio `e facile vedere che P `e reale: si tratta della formula

dintegrazione per parti. Se infatti , C

c

allora

(P, ) =

_

R

ih

(x)(x)dx

= [ih(x)(x)]

x=+

x=

+ih

_

R

(x)

(x)dx

=

_

R

(x)(ih

(x))dx = (, P).

Chiudiamo questa sezione osservando che il fatto che sia Q che P risultino non continui non `e una

sorpresa, ma `e profondamente legato alla equazione fondamentale di commutazione e questo `e un

fatto puramente algebricotopologico! Infatti:

Teorema 3.12 Se Q, P soddisfano la relazione

QP PQ = ihI,

allora almeno uno dei due deve essere illimitato

(9)

(ovvero discontinuo).

Dim. Osserviamo anzitutto che

Q

n

P = Q

n1

QP = Q

n1

(PQ+ihI) = Q

n1

PQ+ihQ

n1

= Q

n2

(QP)Q+ihQ

n1

= Q

n2

(PQ+ihI)Q+ihQ

n1

= Q

n2

PQ

2

+i2 hQ

n1

.

.

.

= PQ

n

+inhQ

n1

,

cos` che

Q

n

P PQ

n

= inhQ

n1

.

Similmente P

n

Q QP

n

= inhP

n1

. Ora: se Q e P fossero continui (cio`e le rispettive norme

operatoriali fossero nite) avremmo che

nh|Q

n1

| = |Q

n

P PQ

n

| |Q

n1

||QP|+|PQ||Q

n1

|, = nh |QP|+|PQ|, n N.

Essendo n arbitrario si ha una contraddizione.

9

Ricordiamo qui che un operatore L : X X si dice limitato se `e continuo. In tal caso e solo in questo

`e ben denita la norma operatoriale

|L| := sup

jj

X

1

|L|

X

.

Direttamente dalla denizione segue che |L|

X

|L|||

X

per ogni X. Inoltre |LM| |L||M|.

19

3.6.3 Quantizzazione di H

Tutto sommato questa `e la parte facile del lavoro. Infatti lidea `e sbalorditivamente semplice. Pren-

diamo lhamiltoniana classica del sistema, cio`e la funzione H H(q, p) che descriverebbe in contesto

classico la dinamica del sistema secondo le equazioni (2.4). Lidea `e di sostituire alle coordinate

generalizzate classiche q e p quelle quantistiche Q e P. Si tratta cio`e di vedere come costruire una

funzione di operatori. In alcuni casi questoperazione `e semplice. Supponiamo ad esempio che f(q)

sia un polinomio in q,

f(q) = a0 +a1q +a2q

2

+. . . +anq

n

.

`

E facile costruire lespressione f(Q) ponendo

f(Q) = a0I +a1Q+a2Q

2

+. . . +anQ

n

,

dove le potenze sono semplicemente la composizione. In particolare, tenendo conto del fatto che

Q(x) := x(x) avremo che

Q

n

(x) = x

n

(x), = [f(Q)] (x) = a0(x) +a1x(x) +. . . +anx

n

(x) = f(x)(x),

cos` che f(Q) altro non `e che loperatore di moltiplicazione per f se f `e un polinomio. In generale,

se f `e una funzione arbitraria, possiamo assumere che

[f(Q)] (x) := f(x)(x),

cio`e che f(Q) sia loperatore di moltiplicazione per f. Lo stesso discorso potrebbe essere formalmente

ripetuto per una funzione di p. Nuovamente: se g(p) = a0 + a1p + a2p

2

+ . . . anp

n

`e un polinomio,

allora potremmo porre

g(P) = a0 +a1P +. . . +anP

n

.

Osservato che

[P

n

] (x) = (ih)

n

d

n

dx

n

(x) = (ih)

n

(n)

(x).

In questo caso g(P) diventa unoperatore dierenziale. Se per`o g non `e un polinomio le cose si

complicano notevolmente. Se g(p) = sin p cosa sarebbe sin P? Oppure P

1

3

? Questo `e un problema,

cos` come `e un problema il fatto che noi dobbiamo quantizzare la funzione H che dipende con-

giuntamente da q e p. Se si pensa al caso di una del tipo H(q, p) = qp ci simbatte nel problema che,

se nei numeri qp = pq tra gli operatori QP ,= PQ! E dunque non `e chiaro quale sia (ammesso che ce

ne sia una) la funzione da quantizzare. Fortunatamente, nella meccanica quantistica, tutte queste

sono chiacchiere superabili facilmente perche la dipendenza da q e p `e separata e non compaiono

funzioni strane della p. Vedremo, tuttavia, che quando si passer`a a quantizzare i campi allora il

problema si porr`a in maniera fondamentale.

Prendiamo allora lhamiltoniana dellinizio:

H(q, p) =

1

2m

p

2

+V (q). (3.8)

Ora la sostituzione formale produce:

1(Q, P) 1 =

1

2m

P

2

+V (Q).

Quindi almeno il problema della non commutativit`a fra Q e P non si pone. Per quanto detto sopra

[P

2

](x) = (ih)

2

(x) = h

2

(x),

mentre

[V (Q)](x) = V (x)(x).

Ci`o detto la quantizzazione di H `e compiuta:

1 :=

h

2

2m

d

2

dx

2

+V , (3.9)

ovvero, sulla funzione donda

1 =

h

2

2m

(x) +V (x)(x).

Osserviamo che C

c

D(1) e che 1 `e simmetrico (quindi `e unosservabile reale) su C

c

.

20

3.7 Equazione di Schrodinger

Vogliamo ora determinare le equazioni di evoluzione degli stati e delle osservabili. Avendo introdotto

le parentesi di Poisson [, ] e avendo quantizzato le osservabili fondamentali Q, P, 1 assumeremo

come base di partenza che levoluzione di una generica osservabile sia descritta dallequazione di

Heisenberg:

Assioma 3.13 Levoluzione Ft di unosservabile `e governata dallequazione

Ft = [Ft, 1] = [F, 1]t

Nel formalismo classico levoluzione delle osservabili `e descritta, equivalentemente, conoscendo il

moto nello spazio delle fasi dalla regola

ft(q, p) = f(Tt(q, p)),

dove |Tt

tR

`e il usso ad un parametro di dieomorsmi dello spazio delle fasi, determinato

dalla risoluzione delle equazioni di Hamilton. Qui non disponiamo delle equazioni di Hamilton,

ma potremmo generalizzare la precedente posizione per legare il moto degli stati a quello delle

osservabili. Se infatti lespressione ft(q, p) =valore dellosservabile f al tempo t nello stato (q, p),

potremmo sostituire tale espressione con Ft) =valore medio dellosservabile F al tempo t sullo

stato . Dunque avremmo una nuova equazione

Ft) = F)t

, (3.10)

dove F = F0. Il primo fatto interessante `e il seguente:

Proposizione 3.14 (conservazione dellenergia ed unitariet`a della dinamica)

1)t

= 1), |t| = ||.

Dim. Infatti:

d

dt

1)t

=

d

dt

1t) =

_

d

dt

1t,

_

= ([1, 1]t, ) = 0.

Per la seconda basta osservare che |t|

2

= Id)t

e ripetere largomento

(10)

.

Si pu`o andare oltre. Scriviamo T(t) := t. Lunitariet`a signica che |T(t)| = ||, ovvero

(T(t), T(t)) = (, ), X.

In eetti T(t) non lascia invariate solo le lunghezze in X ma anche gli angoli, nel senso che

Proposizione 3.15

(T(t), T(t)) = (, ), , X.

Dim. Basta ricordare lidentit`a di polarizzazione

(, ) =

1

4

_

| +|

2

| |

2

+i| +i|

2

i| i|

2

.

Allora

(T(t), T(t)) =

1

4

_

|T(t)( +))|

2

|T(t)( )|

2

+i|T(t)( +i)|

2

i|T(t)( i)|

2

=

1

4

_

| +|

2

| |

2

+i| +i|

2

i| i|

2

= (, ).

10

Pi` u in generale osserviamo che se F `e unosservabile tale che [F, 1] = 0, che nella fattispecie signica F

commuta con 1, allora i valori medi di F si conservano; se si osserva che nel caso della meccanica classica

la condizione f, H esprime il fatto che f `e un integrale primo per le equazioni di Hamilton, potremmo

intendere la condizione suddetta sulle osservabili come condizione caratteristica degli integrali primi nella

versione quantistica.

21

In modo perfettamente identico introduciamo la forma bilineare a(, ) = (1, ). Questo `e una

sorta di prodotto scalare che viene lasciato inalterato dalla dinamica:

Proposizione 3.16

a (T(t), T(t)) = a(, ), , D(1).

Dim. Simile alla precedente.

Reintroducendo lenergia, la proposizione precedente aerma che

(1T(t), T(t)) = (1, ) , , D(1).

In termini geometrici T(t) `e una rotazione in X che lascia invariati gli angoli calcolati sia

rispetto allenergia che rispetto al prodotto scalare di X. Verrebbe dunque da pensare T(t) come una

matrice unitaria. Al momento non `e per`o nemmeno evidente che debba essere lineare. Mostriamo

questo fatto.

Proposizione 3.17

T(t) L(X), t R.

Dim. A titolo di esempio mostriamo ladditivit`a. Chiamiamo T := T(t), T

1

= T(t). Dalla

proposizione 3.15 abbiamo che

(T(1 +2), ) =

_

1 +2, T

1

_

=

_

1, T

1

_

+

_

2, T

1

_

= (T1, ) + (T2, )

= (T1 +T2, ) .

Dunque: T(t) `e unisometria lineare che deve conservare il prodotto dellenergia. Non `e inoltre

dicile osservare che |T(t)

tR

`e un gruppo ad un parametro di tali isometrie, nel senso che

T(t +s) = T(t)T(s) e T(0) = I. Invero, osservato che

F)

T(t+s)

= Ft+s) = (Ft)s) = Ft)

T(s)

= F)

T(t)T(s)

,

per ogni osservabile F, `e facile vericare che T(t +s) = T(t)T(s). Per vedere questo abbiamo il

Lemma 3.18

F) = F)

, F osservabile, = (mod. e

i

)

Dim. Limplicazione inversa `e evidente. Per la diretta, basta considerare come operatore F gli

operatori F := (, ) e F := (, ) (operatori di proiezione sui vettori e rispettivamente).

`

E facile vedere che sono osservabili. Applicando il primo la relazione F) = F)

diventa

||

4

= [(, )[

2

, ||

2

= [(, )[,

mentre applicando il secondo si ottiene ||

2

= [(, )[. Siccome e sono unitari ne segue che

[(, )[ = 1. Ora: scriviamo = (, ) +

, dove

`e ortogonale a . Se

,= 0, allora per il

teorema di Pitagora

||

2

= |(, )|

2

+|

|

2

> [(, )[

2

||

2

= ||

4

, = || < 1,

che `e impossibile. Dunque

= 0 e quindi = (, ) dove [(, )[ = 1 per cui si pu`o scrivere

= e

i

con R.

22

Dunque T(t + s) = e

i

T(t)T(s) con e

i

unitario. Siccome da un punto di vista sico e

i

accettiamo senzaltro che T(t +s) = T(t)T(s).

A questo punto dovremmo attenderci che esista un operatore / simmetrico (unosservabile) tale

che

T(t) = e

it1

.

Questo, con laggiuntiva e naturale ipotesi che t T(t) C([0, +[; X) `e il teorema di Stone,

che qui accettiamo

(11)

. Il punto `e: chi `e /? Un semplice ragionamento svela il mistero. Osserviamo

anzitutto che, presa unosservabile F,

F)

T(t)

=

_

Fe

it1

, e

it1

_

=

_

e

it1

Fe

it1

,

_

= e

it1

Fe

it1

).

In questo modo

Ft = e

it1

Fe

it1

.

Ma Ft risolve lequazione di Heisenberg

Ft = [Ft, 1], mentre

d

dt

_

e

it1

Fe

it1

_

= iLe

it1

Fe

it1

+ie

it1

Fe

it1

/ = i

_

/e

it1

Fe

it1

e

it1

Fe

it1

/

_

= h

_

/, e

it1

Fe

it1

=

_

e

it1

Fe

it1

, h/

.

Allora deve essere

_

e

it1

Fe

it1

, h/

= [Ft, 1] ,

che per t = 0 si riduce a [F, h/] = [F, 1], per ogni osservabile F, ovvero [F, h/ 1] = 0 F

osservabile.

Lemma 3.19

[F, G] = 0, F osservabile, G = cI.

Dim. Supponiamo che esista una ,= 0 tale che G = c +

, dove

,= 0 `e ortogonale a

. Vogliamo costruire unosservabile F tale che [F, G] ,= 0, ovvero FG GF ,= 0. Per fare questo

osserviamo che

(FGGF) = F

_

c +

_

GF = cF +F

GF.

Deniamo in modo lineare F di modo che F = , F

= 2

e F = 0 sul complementare

ortogonale. Allora

(FGGF) = c + 2

G = c + 2

,= 0.

Dunque G = c per ogni X. Ora supponiamo che G1 = c11, G2 = c22, con 1 e 2

perpendicolari ed unitari. Mostriamo che c1 = c2. Invero consideriamo 1 +2. Deve esistere c tale

che G(1 +2) = c(1 +2). Ma G(1 +2) = c11 +c22, da cui

c1 +c2 = c11 +c22.

Ma questo `e evidentemente possibile se e solo se c1 = c = c2.

Allora / =

1

h

1+cI dove c `e reale (perche sia un osservabile), e quindi

T(t) = e

i

h

t(;+cI)

.

Questo signica che

T(t) =

i

h

(1+cI) T(t) =

i

h

1T(t)

ic

h

T(t),

d

dt

_

e

ic

h

t

T(t)

_

=

i

h

e

ic

h

t

1T(t),

11

Cosa esattamente signichi e

it1

non lo specichiamo qui; in generale L non `e un operatore continuo per

cui lesponenziale non viene denito attraverso la serie esponenziale. Quello che ci interessa `e che abbia le

stesse propriet` a formali dellesponenziale come se / fosse unoperatore lineare continuo.

23

ovvero che (t) = e

ic

h

t

T(t) risolve

(t) =

i

h

1(t), (t) = e

i

h

t;

(0), T(t) = e

i

c

h

t

e

i

h

t;

.

Nuovamente, siccome il fattore e

i

c

h

t

`e immaginario puro e e

i

c

h

t

e

i

h

t;

e e

i

h

t;

rappresentano

lo stesso stato, poniamo c = 0 ed abbiamo

T(t) = e

i

h

t;

.

Abbiamo cio`e il

Teorema 3.20 La (3.10) `e valida se e solo se t `e soluzione dellequazione di Schrodinger

t =

i

h

1t. (3.11)

Osservazione 3.21 Sosituendo lespressione (3.9) nella (3.11) si trova:

iht(t, x) =

h

2

2m

xx(t, x) +V (x)(t, x).

La soluzione dellequazione di Schrodinger viene indicata con la scrittura

t = e

i

h

t;

.

Vale la pena di osservare che loperatore di Schrodinger

i

h

1 `e antisimmetrico essendo

_

i

h

1,

_

=

i

h

(1, ) =

i

h

(, 1) =

_

,

i

h

1

_

,

per cui loperatore e

i

h

t;

`e unitario, per quanto visto gi`a nel Corollario 2.7. Inoltre, di speciale

importanza sono gli stati nei quali lenergia 1 assume un valore certo , vale a dire gli autostati

tali che 1 = . Infatti, per tali stati levoluzione `e molto semplice: procedendo formalmente

avremmo

e

i

h

t;

=

n

_

i

h

t

_

n

n!

1

n

=

n

_

i

h

t

_

n

n!

n

= e

i

h

t

.

Sebbene apparentemente tale identit`a poggi sul nulla, la risposta nale `e corretta perche se u(t, x) =

e

i

h

t

(x) allora

tu(t, x) =

i

h

e

i

h

t

(x) =

i

h

e

i

h

t

(1)(x) =

i

h

_

1e

i

h

t

_

(x) =

i

h

1u(t, )(x)

=

i

h

_

h

2

2m

xxu(t, x) +V (x)u(t, x)

_

,

ovvero u risolve lequazione di Schrodinger. Il fatto interessante `e che la formula u(t, x) = e

i

h

t

(x)

illustra molto bene lunitariet`a ed il fatto che lo stato iniziale non viene modicato in ampiezza

quanto in fase (spiegando a posteriori i fenomeni di interferenza citati allinizio). Per fare un

ulteriore passo osserviamo che se poi abbiamo un sistema |n

nN

di autostati per 1 relativi ad

autovalori |n

nN

, sistema che sia una base ortonormale per X

(12)

, allora possiamo ricostruire

integralmente la soluzione dellequazione di Schrodinger attraverso uno sviluppo in serie. Infatti

baster`a osservare che

e

i

h

t;

=

n

cne

i

h

t;

n =

n

cne

i

h

tn

n.

Dunque costruire una base ortonormale di autofunzioni per lhamiltoniana quantistica permette di

risolvere numerosi altri problemi, ivi compresa levoluzione degli stati (che `e ovviamente il problema

fondamentale). Diventa pertanto un problema matematico che `e interessante arontare.

12

Cio`e tale le n siano unitarie, perpendicolari (nel senso che (n, m) = 0 se n ,= m) e che ogni altra

X si scriva =

nN

cnn. In tal caso cn = (, n).

24

3.8 LOscillatore Armonico

Con oscillatore armonico chiameremo il caso di un sistema quantistico la cui hamiltoniana classica

corrisponda a quella appunto di un oscillatore armonico, cio`e

H(q, p) =

1

2m

p

2

+

2

q

2

.

Lanalisi di questo caso `e fondamentale per diversi motivi. Anzitutto costituisce un esempio non

banale completamente calcolabile

(13)

che permette di vedere in maniera limpida come la teoria

permetta di spiegare la stabilit`a della struttura della materia. In secondo luogo costituisce il punto

di partenza per la costruzione del cosidetto campo libero, che pu`o essere immaginato come una

sovrapposizione di inniti oscillatori armonici. Inne `e anche il punto di partenza per le cosidette

perturbazioni, vale a dire dei casi con esergia potenziale V somma di quella di oscillatore armonico

1

2

q

2

con unenergia potenziale V1(q).

Normalizzando opportunamente le costanti (prenderemo m = = 1) consideriamo lhamiltoniana

classica

Hosc(q, p) =

1

2

(q

2

+p

2

),

corrispondente a quella quantistica

1osc :=

h

2

2

d

2

dx

+

1

2

x

2

.

Due sono le questioni che aronteremo: i possibili valori dellenergia e la soluzione dellequazione di

Schrodinger (3.11).

3.8.1 Analisi spettrale

I valori dellenergia sono gli autovalori dellhamiltoniana, come abbiamo detto nella sezione 3.5.

Chiameremo spettro puntuale di 1osc linsieme

p(1osc) := | R : `e autovalore per 1osc .

In questa sezione dimostreremo il seguente

Teorema 3.22

p(1osc) =

_

h

_

1

2

+n

_

: n N |0

_

.

Inoltre: per ogni p(1osc) lautospazio relativo allautovalore ha dimensione 1.

Osservazione 3.23 (Interpretazione) Il teorema 3.22 dice che lenergia assume solo un innit`a

discreta di valori, in forte contrasto con le propriet`a classiche dellenergia. Tuttavia questo non `e

aatto in contrasto con gli esperimenti di sica atomica ed anzi spiega quel fenomeno assurdo

della quantizzazione dellenergia. Ciascuno degli autostati corrisponder`a ad un dierente livello di

energia; verr`a mostrato come sar`a possibile operare su uno stato per farlo passare da un livello ad

un altro di energia, a scatti, conformemente con lesperienza che mostra lesistenza di precise soglie

di energia oltre le quali `e possibile far scattare le particelle da un livello ad unaltro.

La dimostrazione del teorema (3.22) `e piuttosto lunga anche se elementare: avremo modo di ap-

prezzare il formalismo introdotto. Cominciamo dallhamiltoniana quantistica

(14)

nella forma

1osc =

1

2

(P

2

+Q

2

).

Osserviamo che se P e Q fossero numeri si avrebbe

P

2

+Q

2

= (QiP)(Q+iP).

13

Vedremo poi cosa sintende con la locuzione completamente calcolabile.

14

Dora innanzi semplicemente lhamiltoniana

25

Tuttavia Q e P sappiamo non commutano, per cui lordine in un prodotto `e importante. Osserviamo

allora che

(QiP)(Q+iP) = Q

2

+i(QP PQ) +P

2

= Q

2

+P

2

hI = 21osc hI

ovvero

1osc =

1

2

(QiP)

1

2

(Q +iP) +

h

2

I = A

+

h

2

I, (3.12)

ove gli operatori A

e A

sono deniti dalla fattorizzazione del secondo membro della (3.12). Tali

operatori vengono detti (per una ragione che sar`a chiara fra poco) rispettivamente di creazione ed

distruzione. Non sono osservabili reali, ma sono legati fra loro dalla relazione

Lemma 3.24

(A

, ) = (, A

), , X,

ovvero A

=

_

A

.

Dim. Ricordato che Q e P sono osservabili e che il prodotto su X `e hermitiano abbiamo:

((QiP), ) = (Q, ) i(P, )

= (, Q) i(, P)

= (, (Q +iP)).

La fattorizzazione (3.12) si riveler`a importantissima. Tanto per cominciare da qui in poi indicheremo

semplicemente con A loperatore di creazione ed, in virt` u del lemma precedente, A

loperatore di

distruzione.

Proposizione 3.25 Se 0 X `e tale che

A

0 = 0,

allora

1osc0 =

h

2

0.

Lo stato 0 si dice stato fondamentale.

Dunque `e utile risolvere A

0 = 0

(15)

. Scriviamo questa equazione

A

0 = 0 (Q +iP)0 = 0 x0(x) + h

(x) = 0.

Si tratta di una semplice equazione dierenziale la cui soluzione generale `e

0(x) = Ke

1

2 h

x

2

.

`

E evidente che 0 X. Scegliamo K di modo tale che |0| = 1. Otteniamo:

0(x) = (h)

1/4

e

1

2 h

x

2

.

Facciamo qualche considerazione sul signicato di 0. Tornando allinterpretazione originaria,

rispetto allo stato 0 abbiamo che

P(particella [a, b]) =

_

b

a

[0(x)[

2

dx =

1

h

_

b

a

e

x

2

h

dx = A

_

0,

h

2

_

([a, b]),

15

Con linterpretazione di A

come operatore di distruzione,

0

`e lo stato di energia minima, caratterizzato

dal fatto che, levandogli ununit` a (quanto) di energia, cessa di esistere. Una volta trovato

0

costruiremo

tutti gli altri autostati successivamente aggiungendo energia, attraverso A.

26

2

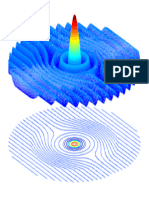

Figure 1: La distribuzione di probabilit`a associata a 0.

cio`e in termini della distribuzione di probabilit`a [0[

2

essa `e una gaussiana di media 0 e varianza

h

2

. Lo stato 0 corrisponde allo stato di quiete, se osserviamo che

Q)

0

= (Q0, 0) =

_

R

(Q0)(x)0(x) dx =

_

R

x0(x)

2

dx = 0,

e

P)

0

=

_

R

ih

0

(x)0(x) dx = ih

_

R

2

h

x0(x)

2

dx = 0.

Inoltre `e lo stato di energia minima. Infatti se `e un autostato unitario per 1, 1 = , allora

= 1) = AA

+

h

2

I) = AA

) +

h

2

||

2

= |A

|

2

+

h

2

>

h

2

,

a meno che A

= 0, che vuol dire = 0.

Procediamo ora nella determinazione degli altri autovalori dellenergia. Prima di immergerci nei

calcoli vediamo qualche utile identit`a:

Lemma 3.26

[A, A

] = iI, [1osc, A] = iA.

Dim. Si tratta di semplici veriche. Abbiamo

ih[A, A

] = (AA

A) =

1

2

[(QiP)(Q+iP) (Q +iP)(QiP)]

=

1

2

_

Q

2

+iQP iPQ+P

2

_

Q

2

+P

2

+iPQiQP

_

= i (QP PQ)

= i ih[Q, P]

= hI,

da cui segue la prima. Per la seconda abbiamo

ih[1osc, A] =

_

AA

+

h

2

I

_

A A

_

AA

+

h

2

I

_

= A(A

AAA

)

= A ih[A

, A]

= hA.

27

Proposizione 3.27

1oscA0 = h

_

1 +

1

2

_

A0.

Dim. Basta applicare il lemma 3.26:

1oscA0 = (1oscAA1osc +A1osc) 0 = ih[1osc, A]0 +

h

2

A0 = h

_

1 +

1

2

_

A0.

Poniamo:

1 :=

A0

|A0|

.

Morale: 1 X, |1| = 1 e 1osc1 = h

_

1 +

1

2

_

1. Ora iteriamo il procedimento. Abbiamo prima

per`o bisogno di estendere il lemma 3.26:

Lemma 3.28

[1osc, A

n

] = inA

n

.

Dim. Per induzione. Sia vera per n 1:

1oscA

n

= 1oscA

n1

A

=

_

A

n1

1osc +ih[1osc, A

n1

]

_

A

=

_

A

n1

1osc + h(n 1)A

n1

_

A (hp dinduzione)

= A

n1