Professional Documents

Culture Documents

Lenguajes Paralelos

Uploaded by

Aries2013herreraOriginal Title

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Lenguajes Paralelos

Uploaded by

Aries2013herreraCopyright:

Available Formats

Qu es la programacin paralela?

La programacin paralela es el uso de varios procesadores trabajando en conjunto

para dar solucin a una tarea en comn, lo que hacen es que se dividen el trabajo

y cada procesador hace una porcin del problema al poder intercambiar datos por

una

red

de

interconexin

travs

de

memoria.

La programacin paralela permite resolver problemas que no caben en un solo

procesador y que no se resuelven en un tiempo razonable, se pueden ejecutar

problemas

con

mayor

complejidad

ms

rpidamente.

El rendimiento de las computadoras tradicionales secuenciales est saturndose

porque las aplicaciones de hoy en da necesitan realizar trabajo ms complejo, por

lo cual la solucin es tener varios procesadores en sistemas paralelos, al as

obtener ganancia de eficiencia siempre y cuando los algoritmos se diseen

adecuadamente.

Lenguajes para computadoras paralelos son flexibles para permitir una

implementacin eficiente y ser an ms fciles para programar.

Con la introduccin de un nuevo paradigma de programacin como lo es el

cmputo paralelo surge tambin la idea de cmo solucionar la programacin de

computadoras paralelas, ya que la idea del cmputo paralelo sugiere la

implementacin de arquitecturas paralelas, algoritmos paralelos y lenguajes de

programacin paralelos.

En nuestros das las arquitecturas paralelas estn en su mayor auge, con la

introduccin de procesadores Multicore, y que no decir de los algoritmos paralelos,

que desde la propuesta de ste nuevo paradigma se han venido desarrollando, sin

embargo, en nuestros das no es muy posible hablar de lenguajes totalmente

paralelizables, o un compilador que de un programa secuencial nos d como

resultado un programa paralelo.

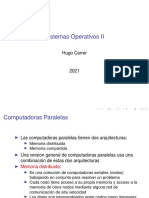

Los lenguajes de programacin concurrentes, bibliotecas, APIs y modelos de

programacin paralela han sido creados para la programacin de computadores

paralelos. Estos generalmente se pueden dividir en clases basadas en las

suposiciones que se hacen sobre la arquitectura de memoria subyacente:

compartida, distribuida, o compartida-distribuida. Los lenguajes de programacin

de memoria compartida se comunican mediante la manipulacin de variables en la

memoria compartida. En la arquitectura con memoria distribuida se utiliza el paso

de mensajes. POSIX Threads y OpenMP son dos de las API ms utilizadas con la

memoria compartida, mientras que Message Passing Interface (MPI) (Interfaz de

Paso de Mensajes) es el API ms utilizado en los sistemas de paso de mensajes.

El concepto valor futuro es muy utilizado en la programacin de programas

paralelos, donde una parte de un programa promete proporcionar un dato

requerido a otra parte del programa en un tiempo futuro.

Dos tcnicas bsicas:

pipeline:

Un pipeline es un conjunto de elementos procesadores de datos conectados en

serie, en el cual la salida de un elemento est conectado en la entrada del que

sigue. Los elementos de esta tcnica son ejecutados en paralelo, debe haber un

tipo

buffer

insertando

los

elementos.

Aplicaciones de pipelines, consiste en mltiples procesos que estn ordenados de

tal forma que el flujo de salida de un proceso se alimenta de la entrada del

siguiente

proceso.

Replicacin asincrnica

Tecnologa en la que una vez que los datos estn escritos en el sitio de

almacenamiento primario, los nuevos datos a este sitio son aceptados, sin tener

que esperar que el sitio de almacenamiento secundario o remoto termine su

escritura.

Espero que mi explicacin les sirva, si tienen algn comentario acerca de esta

entrada, espero me digan ya que estoy abierto a cualquier error.

Lenguajes de programacin en paralelo

POSIX Threads (Pthreads)

OpenMP (Open Multi-Processing)

CUDA (Compute Unified Device Architecture)

OpenCL (Open Compute Language)

POSIX Threads

Thread (Hilo): es un conjunto independiente de instrucciones que

es ejecutado de manera independiente

Un programa puede tener mltiples threads

Implementa un modelo de programacin MIMD

Todos los threads comparten un area de memoria del proceso

principal

Pthreads fue creado en un inicio para dar soporte a la

multiprogramacin en sistemas operativos, no para

programacion en dispositivos multi-core

Con la aparicion de procesadores multi-core, cada thread puede

ser ejecutado por un core diferente (processor affinity)

OpenMP (Open Multi-Processing)

Es un modelo SIMD

Esta compuesto por un conjunto de directivas (#PRAGMA) que

indican al compilador que es un area a paralelizar

Adicionalmente posee variables que permiten definir parmetros

de la paralelizar (ej. el numero de threads a crear)

El momento de la ejecucion, el runtime crea tantos threads como

se haya especificado

Pasa asociar threads a cores, se usa el mismo concepto de

processor affinity

CUDA (Compute Unified Device Architecture)

Estndar propietario de Nvidia

Programacin de Dispositivos Many-core (GPU)

Es SIMT (Single Instruction Multiple Thread)

Variacion de SIMD

Necesita miles de threads para obtener optimo rendimiento

Esconde la latencia de memoria, no la reduce como en el caso

de los CPUs

OpenCL (Open Compute Language)

Estandar universal desarrollado por Khronos

Consorcio: Nvidia, Intel, AMD, Apple, entre otros

Tiene una filosofia de programacion similar a CUDA

Define unicamente el API, la implementacion queda para los

fabricantes de HW

Problema: Interoperabilidad entre plataformas no es posible

hasta este momento

No totalmente optimizado para las diferentes plataformas

You might also like

- Programacion en ParaleloDocument6 pagesProgramacion en ParaleloJoshep DNo ratings yet

- Procesamiento Paralelo PVMDocument23 pagesProcesamiento Paralelo PVMmorris star100% (2)

- Cuadro ComparativoDocument3 pagesCuadro ComparativoMaria GomezNo ratings yet

- E5 Pthread OpenMP MPI Molinas LuqueDocument13 pagesE5 Pthread OpenMP MPI Molinas LuqueNelson182pyNo ratings yet

- Programacion Paralela Aplicada - 6Document30 pagesProgramacion Paralela Aplicada - 6Charliber OficinaNo ratings yet

- Computo ParaleloDocument12 pagesComputo ParaleloErickSobrevillaResendizNo ratings yet

- Programación ConcurrenteDocument5 pagesProgramación ConcurrenteLusdielkaNo ratings yet

- Computo ParaleloDocument173 pagesComputo ParaleloTaniAbbyNo ratings yet

- Resumen Programacion Arduinos y EsoDocument8 pagesResumen Programacion Arduinos y EsoEdwin Astudillo DelgadoNo ratings yet

- Los Algoritmos en PP DIAPOSITIVADocument9 pagesLos Algoritmos en PP DIAPOSITIVAEdwin David D�az MendozaNo ratings yet

- 672554229-Los-Algoritmos-en-PP-DIAPOSITIVADocument9 pages672554229-Los-Algoritmos-en-PP-DIAPOSITIVArichard monteroNo ratings yet

- Computadoras paralelas y programación MPIDocument72 pagesComputadoras paralelas y programación MPIFacu TolayNo ratings yet

- Arquitecturas AvanzadasDocument8 pagesArquitecturas AvanzadasDIRECCION GENERAL DE OPERACION DE TRANSITONo ratings yet

- Computación ParalelaDocument7 pagesComputación ParalelaLuis HermenegildoNo ratings yet

- Trabajo Practico Nº3 de Sistemas Operativos IIDocument42 pagesTrabajo Practico Nº3 de Sistemas Operativos IICamila ToledoNo ratings yet

- Tema 2 Programación en Pararlelo ARGADocument58 pagesTema 2 Programación en Pararlelo ARGACarlos Mauricio Avila MirandaNo ratings yet

- SO MultiprocesadorDocument34 pagesSO MultiprocesadorGabino Arel FernandezNo ratings yet

- Algoritmo Paralelo para Procesar Archivos de TextoDocument31 pagesAlgoritmo Paralelo para Procesar Archivos de TextoJaime SotoNo ratings yet

- Presentacion - P Computacion Paralela PDFDocument58 pagesPresentacion - P Computacion Paralela PDFjcastanedaNo ratings yet

- Clasificación de FLYNNDocument5 pagesClasificación de FLYNNDavid BecerraNo ratings yet

- Glosario Programacion ParalelaDocument7 pagesGlosario Programacion ParalelaGustavo Del AngelNo ratings yet

- Procesamiento ParaleloDocument7 pagesProcesamiento ParaleloAnonymous ukXF7qNo ratings yet

- Balotario Capitulo 7Document2 pagesBalotario Capitulo 7Rosmery MilagrosNo ratings yet

- Estado de ArteDocument3 pagesEstado de ArtelisbrtreosNo ratings yet

- Programacion en ParaleloDocument45 pagesProgramacion en ParaleloJose Antonio Cruz Sanchez100% (1)

- Unidad 4 Arqui de ComputadorasDocument11 pagesUnidad 4 Arqui de ComputadorasIrving CobainNo ratings yet

- Procesos Concurrentes - Sistemas OperativosDocument10 pagesProcesos Concurrentes - Sistemas OperativosMICHAELNo ratings yet

- Programación Concurrente (Multihilos)Document13 pagesProgramación Concurrente (Multihilos)CBTis 227 Planeación y EvaluaciónNo ratings yet

- Procesamiento ParaleloDocument7 pagesProcesamiento ParaleloJuan ThompsonNo ratings yet

- Arquitectura de Las Computadoras Unidad 4Document12 pagesArquitectura de Las Computadoras Unidad 4Fineeve SilverNo ratings yet

- Arquitectura de Computadoras: Computación ParaleloDocument7 pagesArquitectura de Computadoras: Computación ParaleloAntonio Acosta MurilloNo ratings yet

- 03306-Tema 4. Organización ParalelaDocument8 pages03306-Tema 4. Organización Paralelapapatv100% (1)

- Procesamiento ParaleloDocument9 pagesProcesamiento ParaleloCarlos EQNo ratings yet

- Programación ParalelaDocument7 pagesProgramación ParalelaLuis Angel Ortega HuescaNo ratings yet

- Trabajo de Paralelo Calculo de PIDocument5 pagesTrabajo de Paralelo Calculo de PIWilliam Castañeda VilchezNo ratings yet

- Programación ParalelaDocument54 pagesProgramación ParalelaMaggie TretoNo ratings yet

- Computacion ParalelaDocument23 pagesComputacion ParalelaEdgar TorresNo ratings yet

- Sistemas Operativos y MultiprocesamientoDocument6 pagesSistemas Operativos y MultiprocesamientoDaniel PinedaNo ratings yet

- Tarea - 2hilos PosixDocument12 pagesTarea - 2hilos PosixEDDIE SMITH GAME CAMPUZANONo ratings yet

- Diseño Infraestructura Computacion Alto RendimientoDocument15 pagesDiseño Infraestructura Computacion Alto RendimientoAndrs AlvearNo ratings yet

- Arquitectura de SoftwareDocument35 pagesArquitectura de Softwareaiden frostNo ratings yet

- Actividad 1.1.1Document14 pagesActividad 1.1.1luisNo ratings yet

- Definicion Programacion de Sistemas PDFDocument8 pagesDefinicion Programacion de Sistemas PDFjavierNo ratings yet

- Conceptos de Paralelismo - García García Andrea - López Zurita Heriberto LuisDocument5 pagesConceptos de Paralelismo - García García Andrea - López Zurita Heriberto LuisAndrea Garcia GarciaNo ratings yet

- Sistemas DistribuidosDocument8 pagesSistemas DistribuidosJose Guadalupe MateoNo ratings yet

- Introducción a la programación concurrente y concurrenciaDocument12 pagesIntroducción a la programación concurrente y concurrenciaWalter Ramos RoblesNo ratings yet

- Arquitectura de Una PC Un Panorama GeneralDocument14 pagesArquitectura de Una PC Un Panorama GeneralAnonymous jSTkQVC27bNo ratings yet

- Fundamentos de Programación - Algoritmos y Programas - WikilibrosDocument4 pagesFundamentos de Programación - Algoritmos y Programas - WikilibrosJerson O. RiveraNo ratings yet

- Mpi PDFDocument19 pagesMpi PDFJanet Silva GarciaNo ratings yet

- Leccion - 4 - Programacion ConcurrenteDocument4 pagesLeccion - 4 - Programacion ConcurrentetoniskaiNo ratings yet

- 4.5 Casos de EstudioDocument5 pages4.5 Casos de EstudioSilvio Dresser0% (1)

- Aspectos Basicos de La Computacion Paralela y DistribuidaDocument10 pagesAspectos Basicos de La Computacion Paralela y Distribuidaluis hernandez100% (1)

- Universidad Nacional de Ingenieria Instituto de Estudios SuperioresDocument3 pagesUniversidad Nacional de Ingenieria Instituto de Estudios Superioreseduardo janns martinezNo ratings yet

- Programación Paralela: Conceptos Clave, Historia y AplicacionesDocument33 pagesProgramación Paralela: Conceptos Clave, Historia y AplicacionesJoseph Pérez GuédezNo ratings yet

- Programación paralela: problemas, herramientas y estilosDocument32 pagesProgramación paralela: problemas, herramientas y estiloselkillyNo ratings yet

- Procesamiento ParaleloDocument23 pagesProcesamiento ParaleloAlejandro Pérez García0% (1)

- Sitema DitribuidoDocument53 pagesSitema DitribuidoRuben CalleNo ratings yet

- Proyecto Integrales-MPI-OPENMP-HIBRIDA-CDocument6 pagesProyecto Integrales-MPI-OPENMP-HIBRIDA-CGiulianaHeránPinedaNo ratings yet

- Lectura 1 ResumenDocument18 pagesLectura 1 ResumenAries2013herreraNo ratings yet

- Normas APA Sexta EdiciónDocument24 pagesNormas APA Sexta EdiciónAndersontatto95% (20)

- Formato PDGRDocument4 pagesFormato PDGRAries2013herreraNo ratings yet

- Matriz de Procesos PMBOK V5.Document1 pageMatriz de Procesos PMBOK V5.Marcel Rodríguez DelgadoNo ratings yet

- Organigrama WbsDocument1 pageOrganigrama WbsAries2013herreraNo ratings yet

- ProcesadoresDocument6 pagesProcesadoresAries2013herreraNo ratings yet

- Matriz de Procesos PMBOK V5.Document1 pageMatriz de Procesos PMBOK V5.Marcel Rodríguez DelgadoNo ratings yet

- Redes TransporteDocument26 pagesRedes TransporteAries2013herreraNo ratings yet

- Inteligencia de NegociosDocument20 pagesInteligencia de NegociosAries2013herreraNo ratings yet

- Algoritmos de OrdenamientoDocument12 pagesAlgoritmos de OrdenamientoAries2013herreraNo ratings yet

- Qué Es Big DataDocument5 pagesQué Es Big DataAries2013herreraNo ratings yet

- Curva de MuestreoDocument15 pagesCurva de MuestreoEdson SeguraNo ratings yet

- Manual de lectura de planos de arquitecturaDocument39 pagesManual de lectura de planos de arquitecturaFlorchu ArceNo ratings yet

- RodriguezOscar 2020 DiseñoDeshidratadorSolarDocument47 pagesRodriguezOscar 2020 DiseñoDeshidratadorSolarLuis Saavedra Santa MariaNo ratings yet

- Leyes de Afinidad para Bombas CentrífugasDocument2 pagesLeyes de Afinidad para Bombas CentrífugasJoelJátivaCarrilloNo ratings yet

- HistoriadelOrdenador PrimerFinalDocument11 pagesHistoriadelOrdenador PrimerFinaldvfsdssssNo ratings yet

- CERONTE TRICARGO-3000e PDFDocument52 pagesCERONTE TRICARGO-3000e PDFCamilaNo ratings yet

- E Práctica#2Document10 pagesE Práctica#2Sofia Coppiano GarciaNo ratings yet

- Sesion Laboratorio y Sesion Taller UntDocument6 pagesSesion Laboratorio y Sesion Taller UntNelson Diaz VargasNo ratings yet

- Ejercicio Clase #11.xlsxpractica en ClaseDocument105 pagesEjercicio Clase #11.xlsxpractica en ClaseDARIO RIVASNo ratings yet

- Campana Cupula 400Document4 pagesCampana Cupula 400Kimberly AntequeraNo ratings yet

- Investigación científica: características y tiposDocument8 pagesInvestigación científica: características y tiposgene rodriNo ratings yet

- Regla de Trapecio y Simpson 1Document20 pagesRegla de Trapecio y Simpson 1Nilma Fiorella Quispe EnriquezNo ratings yet

- Oscilaciones e inestabilidad en sistemas auto-catalíticos continuosDocument1 pageOscilaciones e inestabilidad en sistemas auto-catalíticos continuosIvan Hernádez GutierrezNo ratings yet

- Leyes de la termodinámica: Primera y Segunda ley explicadasDocument5 pagesLeyes de la termodinámica: Primera y Segunda ley explicadasabelz4No ratings yet

- Prueba Piloto 2 Estadistica IIDocument1 pagePrueba Piloto 2 Estadistica IIHenry CamposNo ratings yet

- Apuntes Morfología Diseño IndustrialDocument23 pagesApuntes Morfología Diseño Industrialcosmicgoo89% (57)

- Precipitaciones Maximas Diarias11Document28 pagesPrecipitaciones Maximas Diarias11Tih FerNo ratings yet

- Tarea Semana 8 Estadística para La Gestión Sergio Espinoza AlmendrasDocument6 pagesTarea Semana 8 Estadística para La Gestión Sergio Espinoza AlmendrasSergio Espinoza100% (1)

- Eclipses Solares Astronomía y Física ProyectoDocument5 pagesEclipses Solares Astronomía y Física Proyectojepibe5134No ratings yet

- Características de Huawei Y7Document6 pagesCaracterísticas de Huawei Y7Kevin Alef Enciso GomesNo ratings yet

- Diferencias entre arquitecturas Dataflow de búsqueda e interconexiónDocument5 pagesDiferencias entre arquitecturas Dataflow de búsqueda e interconexiónAxel Ortiz RicaldeNo ratings yet

- Formulaciones de Productos Del HogarDocument5 pagesFormulaciones de Productos Del HogarMaribel Hernández GaraboteNo ratings yet

- Examenes Johnny Primer Periodo 2018 NovenoDocument1 pageExamenes Johnny Primer Periodo 2018 Novenoturbomilitar-1No ratings yet

- GuiadeEjercicioyProblemas Sistemas 2007 PDFDocument41 pagesGuiadeEjercicioyProblemas Sistemas 2007 PDFOsbel Elver Campos SandovalNo ratings yet

- Distribuciones de Muestreo Capitulo 6 LevinDocument53 pagesDistribuciones de Muestreo Capitulo 6 LevinSofia MeermannNo ratings yet

- Analisis Descriptivo Univariante MarisolDocument79 pagesAnalisis Descriptivo Univariante MarisolmarisolNo ratings yet

- Acidez TitulableDocument2 pagesAcidez TitulableVictor Jesus Martinez MoralesNo ratings yet

- Unidad 5 Cinetica de Los Cuerpos Rigidos en El PlanoDocument68 pagesUnidad 5 Cinetica de Los Cuerpos Rigidos en El Planoamairali62% (13)

- Ud04 So PDFDocument16 pagesUd04 So PDFrosa100% (2)

- Calculo de La Seccion Del Conductor Por Caida de TensionDocument3 pagesCalculo de La Seccion Del Conductor Por Caida de Tensiondiana queralezNo ratings yet